您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

這篇文章將為大家詳細講解有關Linux系統如何部署Hadoop集群,小編覺得挺實用的,因此分享給大家做個參考,希望大家閱讀完這篇文章后可以有所收獲。

Hadoop是Apache旗下的一個用java語言實現開源軟件框架,是一個開發和運行處理大規模數據的軟件平臺

Hadoop允許使用簡單的編程模型在大量計算機集群上對大型數據集進行分布式處理。

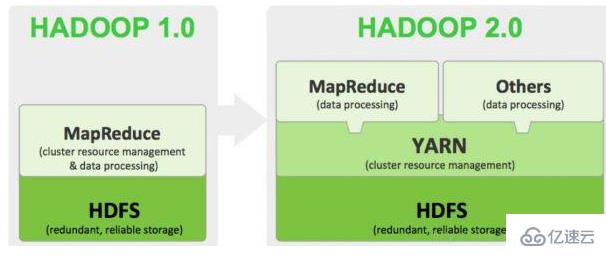

狹義上說,Hadoop指Apache這款開源框架,它的核心組件有:

HDFS(分布式文件系統):解決海量數據存儲

YARN(作業調度和集群資源管理的框架):解決資源任務調度

MAPREDUCE(分布式運算編程框架):解決海量數據計算

廣義上來說,Hadoop通常是指一個更廣泛的概念——Hadoop生態圈。

當下的Hadoop已經成長為一個龐大的體系,隨著生態系統的成長,新出現的項目越來越多,其中不乏一些非Apache主管的項目,這些項目對HADOOP是很好的補充或者更高層的抽象。

安裝ssh服務

進入shell命令,輸入如下命令,查看是否已經安裝好ssh服務,若沒有,則使用如下命令進行安裝:

sudo apt-get install ssh openssh-server

安裝過程還是比較輕松加愉快的。

使用ssh進行無密碼驗證登錄

1.創建ssh-key,這里我們采用rsa方式,使用如下命令:

ssh-keygen -t rsa -P “”

2.出現一個圖形,出現的圖形就是密碼,不用管它

cat ~/.ssh/id_rsa.pub >> authorized_keys(好像是可以省略的)

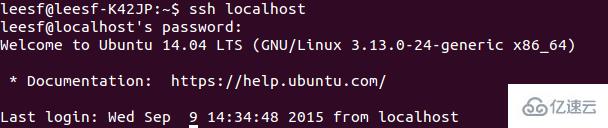

3.然后即可無密碼驗證登錄了,如下:

ssh localhost

成功截圖如下:

下載Hadoop安裝包

下載Hadoop安裝也有兩種方式

1.直接上官網進行下載,http://mirrors.hust.edu.cn/apache/hadoop/core/stable/hadoop-2.7.1.tar.gz

2.使用shell進行下載,命令如下:

wget http://mirrors.hust.edu.cn/apache/hadoop/core/stable/hadoop-2.7.1.tar.gz

貌似第二種的方法要快點,經過漫長的等待,終于下載完成。

解壓縮Hadoop安裝包

使用如下命令解壓縮Hadoop安裝包

tar -zxvf hadoop-2.7.1.tar.gz

解壓縮完成后出現hadoop2.7.1的文件夾

配置Hadoop中相應的文件

需要配置的文件如下,hadoop-env.sh,core-site.xml,mapred-site.xml.template,hdfs-site.xml,所有的文件均位于hadoop2.7.1/etc/hadoop下面,具體需要的配置如下:

1.core-site.xml 配置如下:

其中的hadoop.tmp.dir的路徑可以根據自己的習慣進行設置。

2.mapred-site.xml.template配置如下:

3.hdfs-site.xml配置如下:

其中dfs.namenode.name.dir和dfs.datanode.data.dir的路徑可以自由設置,最好在hadoop.tmp.dir的目錄下面。

補充,如果運行Hadoop的時候發現找不到jdk,可以直接將jdk的路徑放置在hadoop.env.sh里面,具體如下:

export JAVA_HOME=”/home/leesf/program/java/jdk1.8.0_60″

運行Hadoop

在配置完成后,運行hadoop。

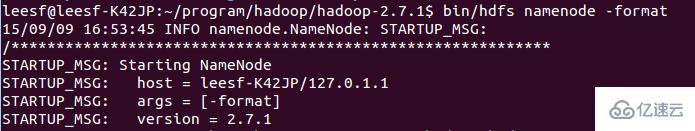

1.初始化HDFS系統

在hadop2.7.1目錄下使用如下命令:

bin/hdfs namenode -format

截圖如下:

過程需要進行ssh驗證,之前已經登錄了,所以初始化過程之間鍵入y即可。

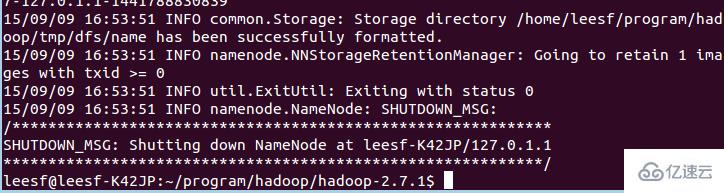

成功的截圖如下:

表示已經初始化完成。

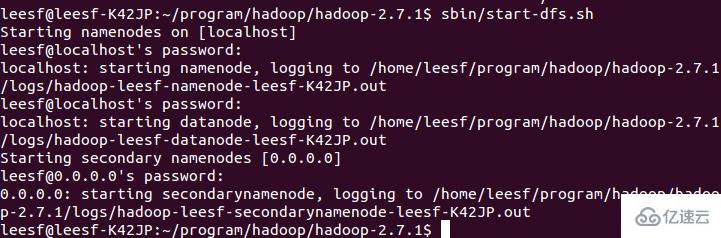

2.開啟NameNode和DataNode守護進程

使用如下命令開啟:

sbin/start-dfs.sh,成功的截圖如下:

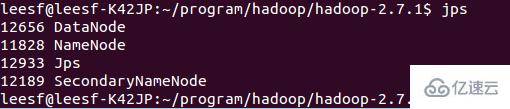

3.查看進程信息

使用如下命令查看進程信息

jps,截圖如下:

表示數據DataNode和NameNode都已經開啟

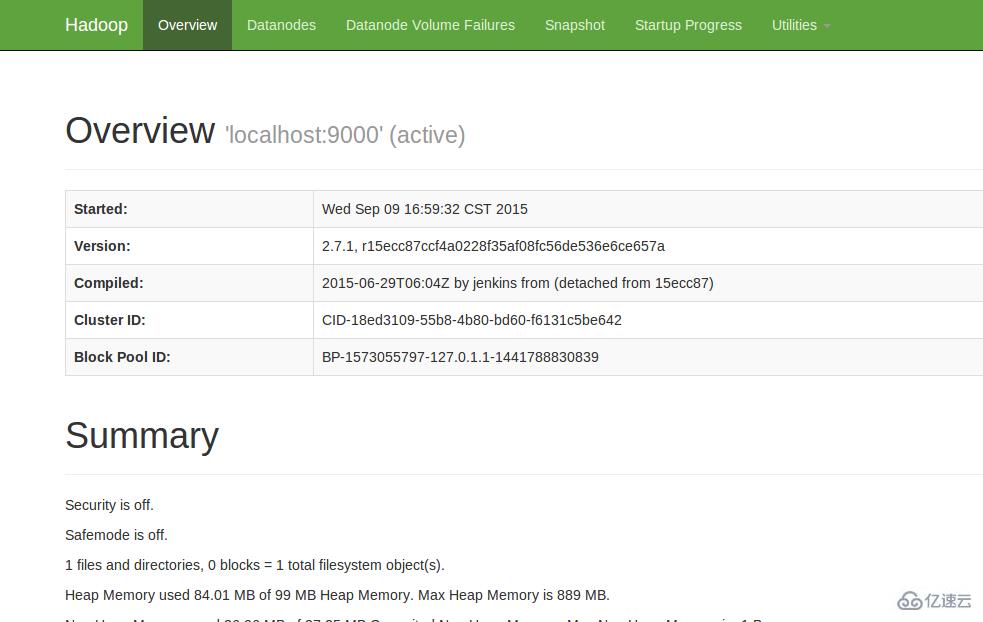

4.查看Web UI

在瀏覽器中輸入,即可查看相關信息,截圖如下:

至此,hadoop的環境就已經搭建好了。下面開始使用hadoop來運行一個WordCount例子。

運行WordCount Demo

1.在本地新建一個文件,筆者在home/leesf目錄下新建了一個words文檔,里面的內容可以隨便填寫。

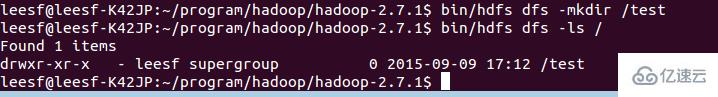

2.在HDFS中新建一個文件夾,用于上傳本地的words文檔,在hadoop2.7.1目錄下輸入如下命令:

bin/hdfs dfs -mkdir /test,表示在hdfs的根目錄下建立了一個test目錄

使用如下命令可以查看HDFS根目錄下的目錄結構

bin/hdfs dfs -ls /

具體截圖如下:

表示在HDFS的根目錄下已經建立了一個test目錄

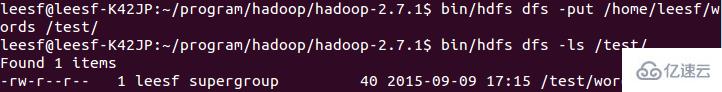

3.將本地words文檔上傳到test目錄中

使用如下命令進行上傳操作:

bin/hdfs dfs -put /home/leesf/words /test/

使用如下命令進行查看

bin/hdfs dfs -ls /test/

結果截圖如下:

表示已經將本地的words文檔上傳到了test目錄下了。

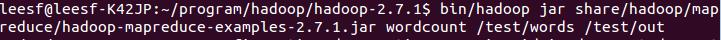

4.運行wordcount

使用如下命令運行wordcount:

bin/hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.1.jar wordcount /test/words /test/out

截圖如下:

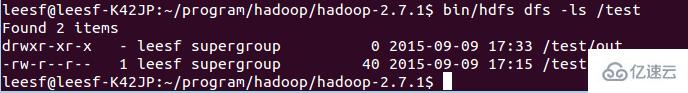

運行完成后,在/test目錄下生成名為out的文件,使用如下命令查看/test目錄下的文件

bin/hdfs dfs -ls /test

截圖如下:

表示在test目錄下已經有了一個名為Out的文件目錄

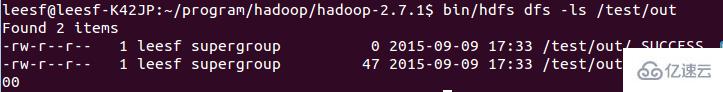

輸入如下命令查看out目錄下的文件:

bin/hdfs dfs -ls /test/out,結果截圖如下:

表示已經成功運行了,結果保存在part-r-00000中。

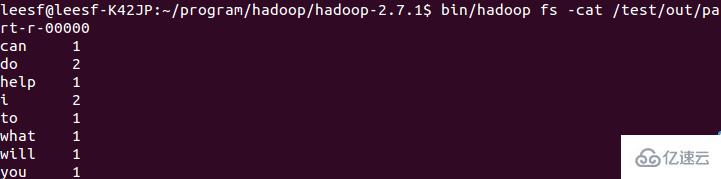

5.查看運行結果

使用如下命令查看運行結果:

bin/hadoop fs -cat /test/out/part-r-00000

結果截圖如下:

關于“Linux系統如何部署Hadoop集群”這篇文章就分享到這里了,希望以上內容可以對大家有一定的幫助,使各位可以學到更多知識,如果覺得文章不錯,請把它分享出去讓更多的人看到。

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。