溫馨提示×

您好,登錄后才能下訂單哦!

點擊 登錄注冊 即表示同意《億速云用戶服務條款》

您好,登錄后才能下訂單哦!

小編給大家分享一下Python Requests爬蟲中如何求取關鍵詞頁面,相信大部分人都還不怎么了解,因此分享這篇文章給大家參考一下,希望大家閱讀完這篇文章后大有收獲,下面讓我們一起去了解一下吧!

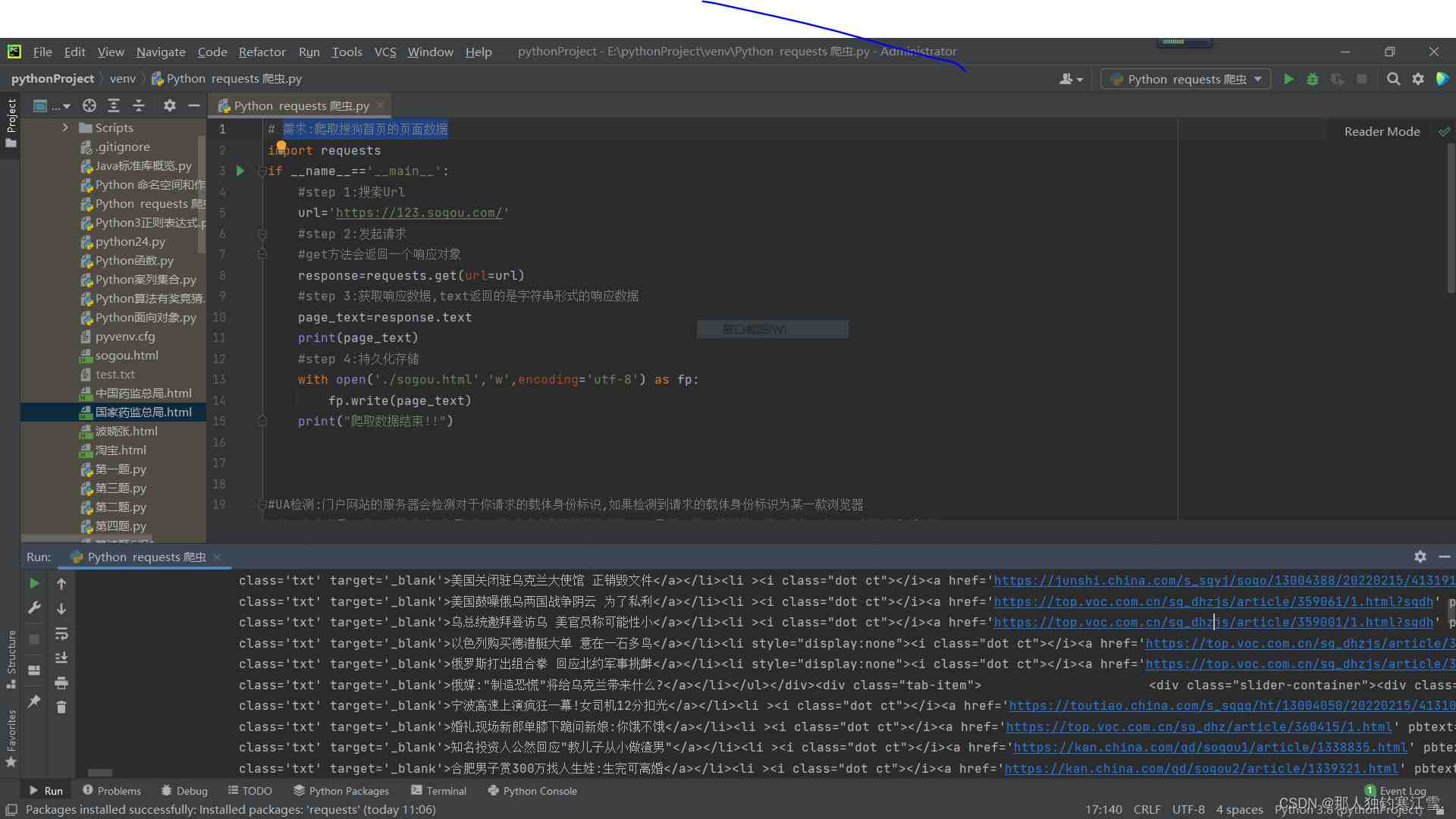

import requestsif __name__=='__main__': #step 1:搜索Url url='https://123.sogou.com/' #step 2:發起請求 #get方法會返回一個響應對象 response=requests.get(url=url) #step 3:獲取響應數據,text返回的是字符串形式的響應數據 page_text=response.text print(page_text) #step 4:持久化存儲 with open('./sogou.html','w',encoding='utf-8') as fp: fp.write(page_text) print("爬取數據結束")import requests

if __name__=='__main__':

#step 1:搜索Url

url='https://123.sogou.com/'

#step 2:發起請求

#get方法會返回一個響應對象

response=requests.get(url=url)

#step 3:獲取響應數據,text返回的是字符串形式的響應數據

page_text=response.text

print(page_text)

#step 4:持久化存儲

with open('./sogou.html','w',encoding='utf-8') as fp:

fp.write(page_text)

print("爬取數據結束")

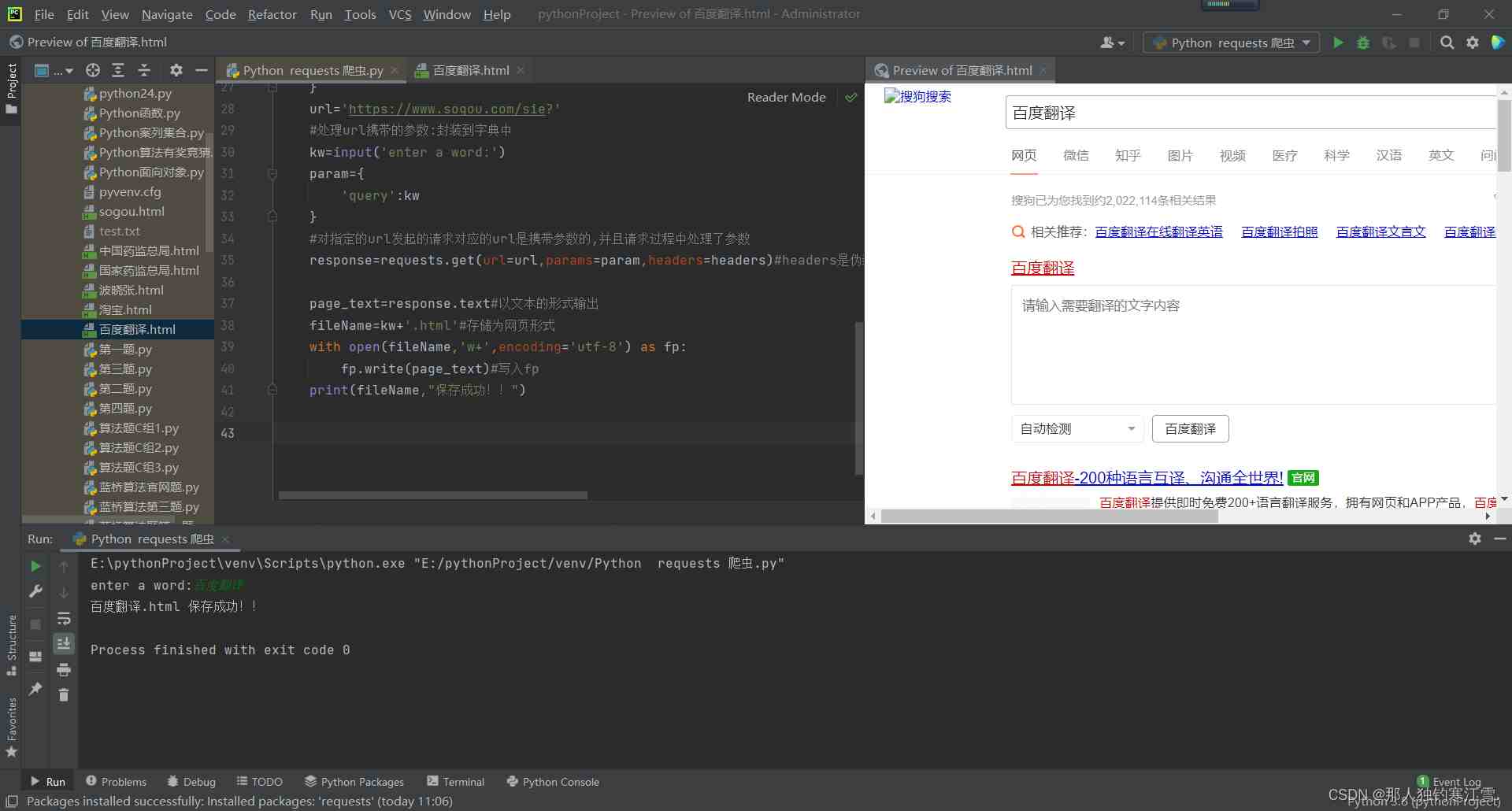

import requests

if __name__=='__main__':

#UA偽裝:將對應的User-Agent封裝到一個字典中

headers={

'User-Agent':'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/98.0.4758.9 Safari/537.36'

}

url='https://www.sogou.com/sie?'

#處理url攜帶的參數:封裝到字典中

kw=input('enter a word:')

param={

'query':kw

}

#對指定的url發起的請求對應的url是攜帶參數的,并且請求過程中處理了參數

response=requests.get(url=url,params=param,headers=headers)#headers是偽裝 params輸入關鍵詞

page_text=response.text#以文本的形式輸出

fileName=kw+'.html'#存儲為網頁形式

with open(fileName,'w+',encoding='utf-8') as fp:

fp.write(page_text)#寫入fp

print(fileName,"保存成功!!")

以上是“Python Requests爬蟲中如何求取關鍵詞頁面”這篇文章的所有內容,感謝各位的閱讀!相信大家都有了一定的了解,希望分享的內容對大家有所幫助,如果還想學習更多知識,歡迎關注億速云行業資訊頻道!

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。