溫馨提示×

您好,登錄后才能下訂單哦!

點擊 登錄注冊 即表示同意《億速云用戶服務條款》

您好,登錄后才能下訂單哦!

今天小編給大家分享一下怎么用python爬取今日說法每期數據的相關知識點,內容詳細,邏輯清晰,相信大部分人都還太了解這方面的知識,所以分享這篇文章給大家參考一下,希望大家閱讀完這篇文章后有所收獲,下面我們一起來了解一下吧。

import xlwt

import re

import requests

# url = "https://tv.cctv.com/lm/jrsf/index.shtml"

def get_data(page):

url = 'https://api.cntv.cn/NewVideo/getVideoListByColumn?id=TOPC145146466500891' \

'4&n=1000&sort=desc&p={pageNo}&mode=0&serviceId=tvcctv&cb=Callback'.format(pageNo=page)

headers = {

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 '

'(KHTML, like Gecko) Chrome/92.0.4515.131 Safari/537.36'

}

response = requests.get(url=url, headers=headers)

return response.text

# print(response.text)

if __name__ == "__main__":

headers = {

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 '

'(KHTML, like Gecko) Chrome/92.0.4515.131 Safari/537.36'

}

book = xlwt.Workbook(encoding='utf-8', style_compression=0)

sheet = book.add_sheet('今日說法', cell_overwrite_ok=True)

count = 0

for page in range(1,5):

page_content = get_data(page)

obj = re.compile(r'url":"(.*?.shtml)"', re.S)

imgUrl = re.findall(obj, page_content.replace('\\', ''))

for i in range(len(imgUrl)):

resp = requests.get(url=imgUrl[i], headers=headers)

resp.encoding = 'utf-8'

obj2 = re.compile(r'更新時間:</em>(.*?)</p>', re.S)

time = re.findall(obj2, resp.text)

obj3 = re.compile(r'視頻簡介:</em>(.*?)</p>', re.S)

jianjie = re.findall(obj3, resp.text)

content = []

content.append(time)

content.append(jianjie)

for j in range(2):

sheet.write(count, j, content[j])

count+=1

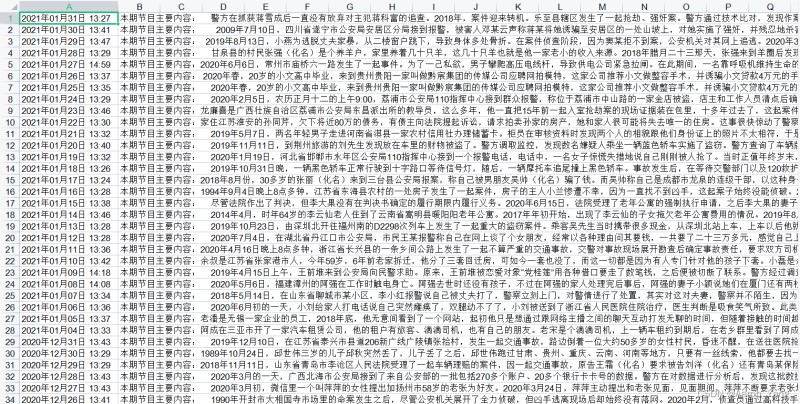

book.save("./data_5.xls")

以上就是“怎么用python爬取今日說法每期數據”這篇文章的所有內容,感謝各位的閱讀!相信大家閱讀完這篇文章都有很大的收獲,小編每天都會為大家更新不同的知識,如果還想學習更多的知識,請關注億速云行業資訊頻道。

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。