您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

本篇內容主要講解“什么是pytorch交叉熵損失函數”,感興趣的朋友不妨來看看。本文介紹的方法操作簡單快捷,實用性強。下面就讓小編來帶大家學習“什么是pytorch交叉熵損失函數”吧!

1.交叉熵損失函數的推導

2. 交叉熵損失函數的直觀理解

3. 交叉熵損失函數的其它形式

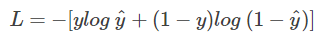

說起交叉熵損失函數「Cross Entropy Loss」,腦海中立馬浮現出它的公式:

我們已經對這個交叉熵函數非常熟悉,大多數情況下都是直接拿來使用就好。但是它是怎么來的?為什么它能表征真實樣本標簽和預測概率之間的差值?上面的交叉熵函數是否有其它變種?

我們知道,在二分類問題模型:例如邏輯回歸「Logistic Regression」、神經網絡「Neural Network」等,真實樣本的標簽為 [0,1],分別表示負類和正類。模型的最后通常會經過一個 Sigmoid 函數,輸出一個概率值,這個概率值反映了預測為正類的可能性:概率越大,可能性越大。

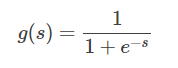

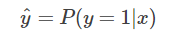

Sigmoid 函數的表達式和圖形如下所示:

其中 s 是模型上一層的輸出,Sigmoid 函數有這樣的特點:s = 0 時,g(s) = 0.5;s >> 0 時, g ≈ 1,s << 0 時,g ≈ 0。顯然,g(s) 將前一級的線性輸出映射到 [0,1] 之間的數值概率上。這里的 g(s) 就是交叉熵公式中的模型預測輸出 。

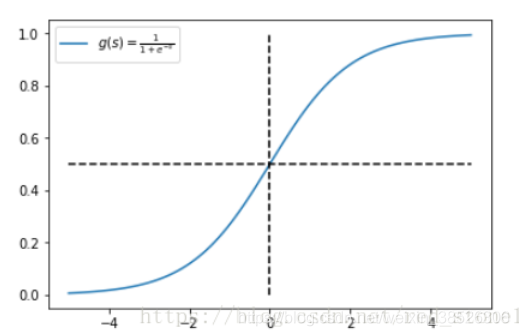

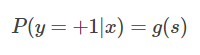

我們說了,預測輸出即 Sigmoid 函數的輸出表征了當前樣本標簽為 1 的概率:

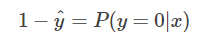

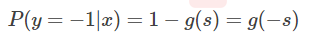

很明顯,當前樣本標簽為 0 的概率就可以表達成:

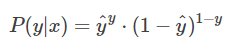

重點來了,如果我們從極大似然性的角度出發,把上面兩種情況整合到一起:

不懂極大似然估計也沒關系。我們可以這么來看:

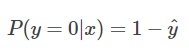

當真實樣本標簽 y = 0 時,上面式子第一項就為 1,概率等式轉化為:

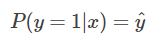

當真實樣本標簽 y = 1 時,上面式子第二項就為 1,概率等式轉化為:

兩種情況下概率表達式跟之前的完全一致,只不過我們把兩種情況整合在一起了。

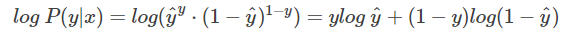

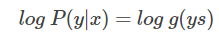

重點看一下整合之后的概率表達式,我們希望的是概率 P(y|x) 越大越好。首先,我們對 P(y|x) 引入 log 函數,因為 log 運算并不會影響函數本身的單調性。則有:

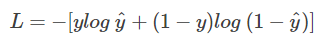

我們希望 log P(y|x) 越大越好,反過來,只要 log P(y|x) 的負值 -log P(y|x) 越小就行了。那我們就可以引入損失函數,且令 Loss = -log P(y|x)即可。則得到損失函數為:

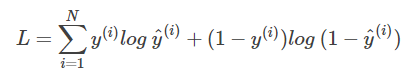

非常簡單,我們已經推導出了單個樣本的損失函數,是如果是計算 N 個樣本的總的損失函數,只要將 N 個 Loss 疊加起來就可以了:

這樣,我們已經完整地實現了交叉熵損失函數的推導過程。

我已經知道了交叉熵損失函數的推導過程。但是能不能從更直觀的角度去理解這個表達式呢?而不是僅僅記住這個公式。好問題!接下來,我們從圖形的角度,分析交叉熵函數,加深理解。

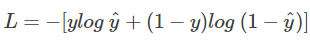

首先,還是寫出單個樣本的交叉熵損失函數:

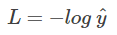

我們知道,當 y = 1 時

這時候,L 與預測輸出的關系如下圖所示:

看了 L 的圖形,簡單明了!橫坐標是預測輸出,縱坐標是交叉熵損失函數 L。顯然,預測輸出越接近真實樣本標簽 1,損失函數 L 越小;預測輸出越接近 0,L 越大。因此,函數的變化趨勢完全符合實際需要的情況。

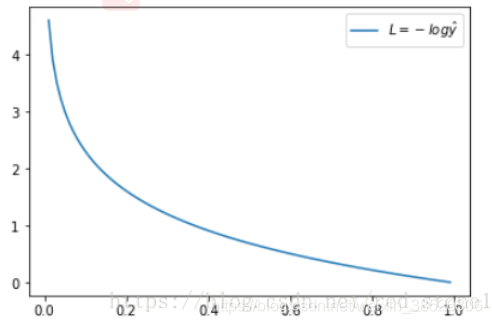

當 y = 0 時:

這時候,L 與預測輸出的關系如下圖所示:

同樣,預測輸出越接近真實樣本標簽 0,損失函數 L 越小;預測函數越接近 1,L 越大。函數的變化趨勢也完全符合實際需要的情況。

從上面兩種圖,可以幫助我們對交叉熵損失函數有更直觀的理解。無論真實樣本標簽 y 是 0 還是 1,L 都表征了預測輸出與 y 的差距。

另外,重點提一點的是,從圖形中我們可以發現:預測輸出與 y 差得越多,L 的值越大,也就是說對當前模型的 “ 懲罰 ” 越大,而且是非線性增大,是一種類似指數增長的級別。這是由 log 函數本身的特性所決定的。這樣的好處是模型會傾向于讓預測輸出更接近真實樣本標簽 y。

什么?交叉熵損失函數還有其它形式?沒錯!我剛才介紹的是一個典型的形式。接下來我將從另一個角度推導新的交叉熵損失函數。

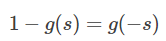

這種形式下假設真實樣本的標簽為 +1 和 -1,分別表示正類和負類。有個已知的知識點是Sigmoid 函數具有如下性質:

這個性質我們先放在這,待會有用。

好了,我們之前說了 y = +1 時,下列等式成立:

如果 y = -1 時,并引入 Sigmoid 函數的性質,下列等式成立:

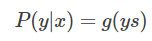

重點來了,因為 y 取值為 +1 或 -1,可以把 y 值帶入,將上面兩個式子整合到一起:

這個比較好理解,分別令 y = +1 和 y = -1 就能得到上面兩個式子。

接下來,同樣引入 log 函數,得到:

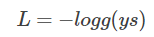

要讓概率最大,反過來,只要其負數最小即可。那么就可以定義相應的損失函數為:

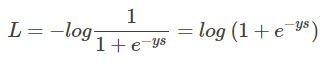

還記得 Sigmoid 函數的表達式吧?將 g(ys) 帶入:

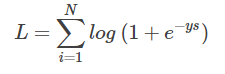

好咯,L 就是我要推導的交叉熵損失函數。如果是 N 個樣本,其交叉熵損失函數為:

接下來,我們從圖形化直觀角度來看。當 y = +1 時:

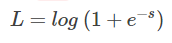

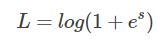

這時候,L 與上一層得分函數 s 的關系如下圖所示:

橫坐標是 s,縱坐標是 L。顯然,s 越接近正無窮,損失函數 L 越小;s 越接近負無窮,L 越大。

另一方面,當 y = -1 時:

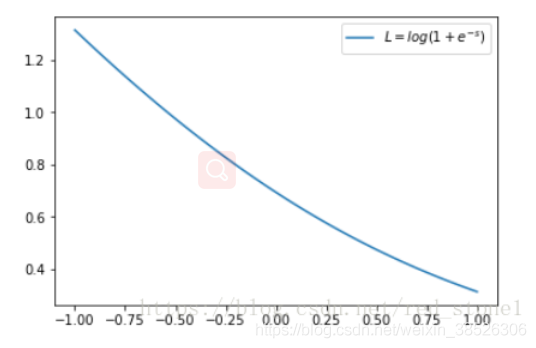

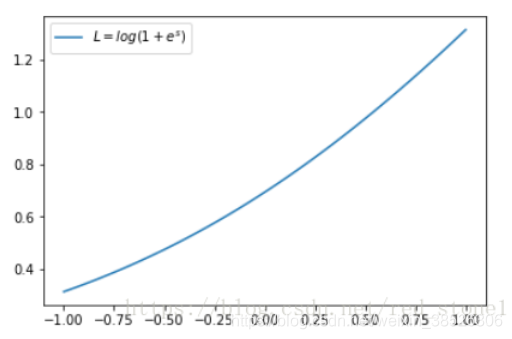

這時候,L 與上一層得分函數 s 的關系如下圖所示:

同樣,s 越接近負無窮,損失函數 L 越小;s 越接近正無窮,L 越大。

到此,相信大家對“什么是pytorch交叉熵損失函數”有了更深的了解,不妨來實際操作一番吧!這里是億速云網站,更多相關內容可以進入相關頻道進行查詢,關注我們,繼續學習!

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。