溫馨提示×

您好,登錄后才能下訂單哦!

點擊 登錄注冊 即表示同意《億速云用戶服務條款》

您好,登錄后才能下訂單哦!

這篇文章主要介紹基于Flink的MQ-Hive實時數據集成如何實現字節跳動,文中介紹的非常詳細,具有一定的參考價值,感興趣的小伙伴們一定要看完!

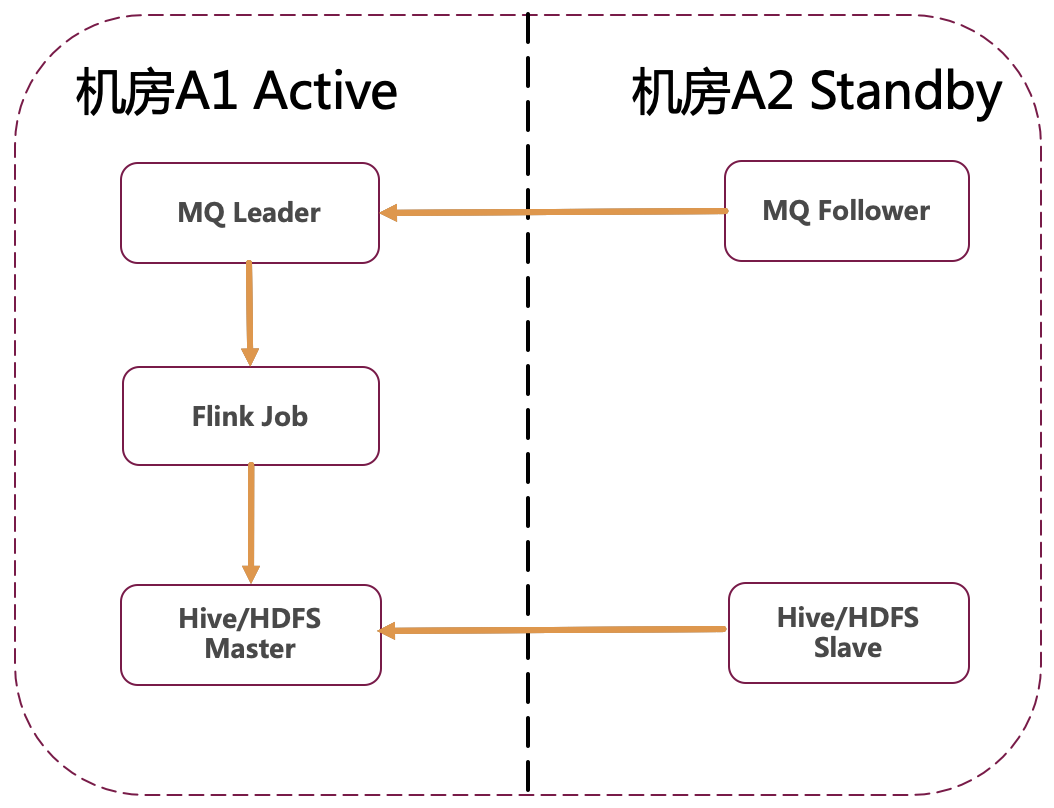

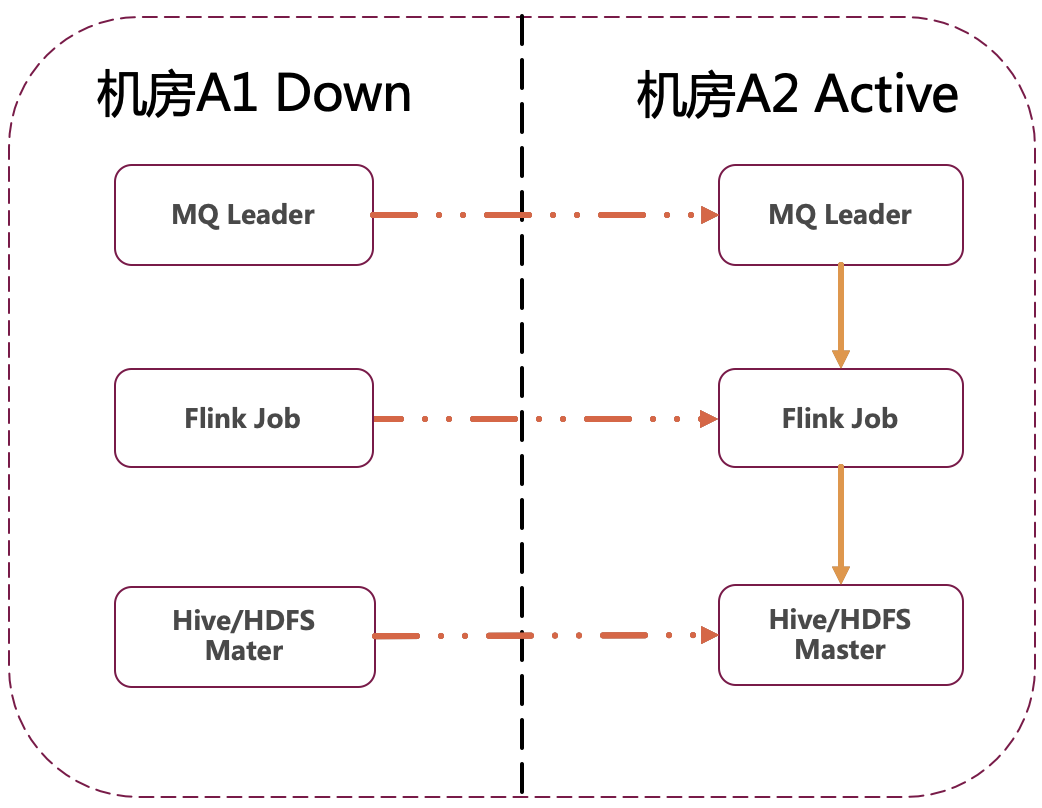

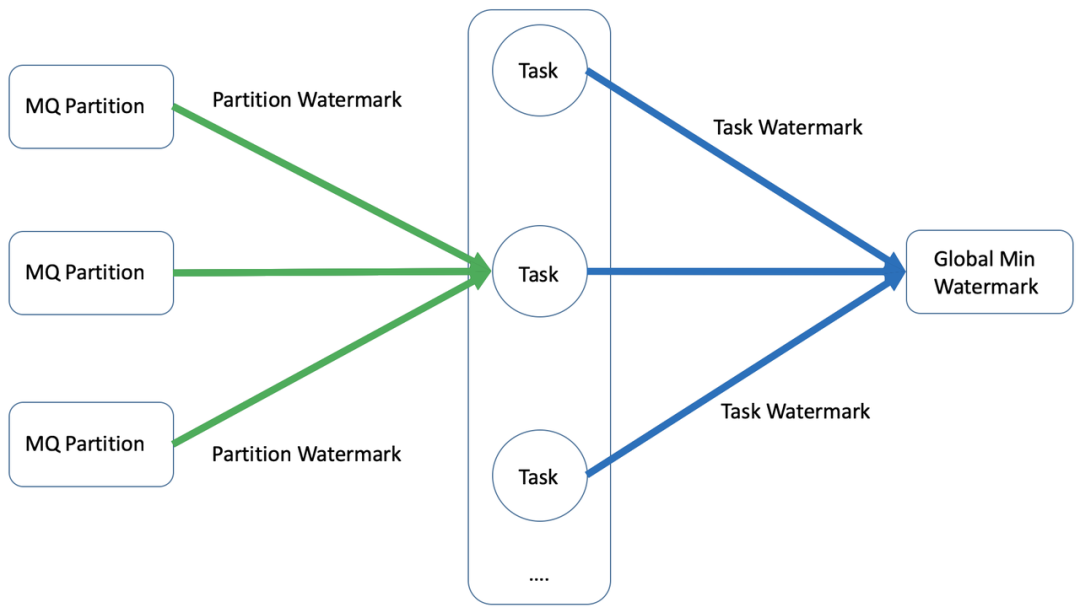

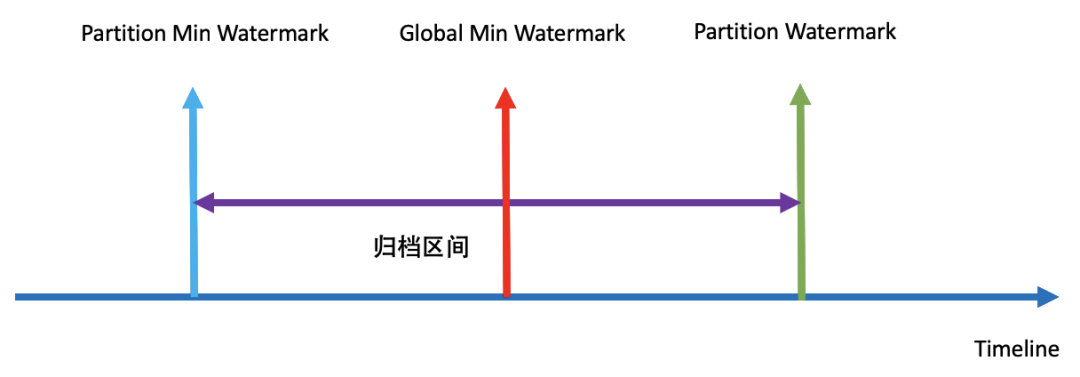

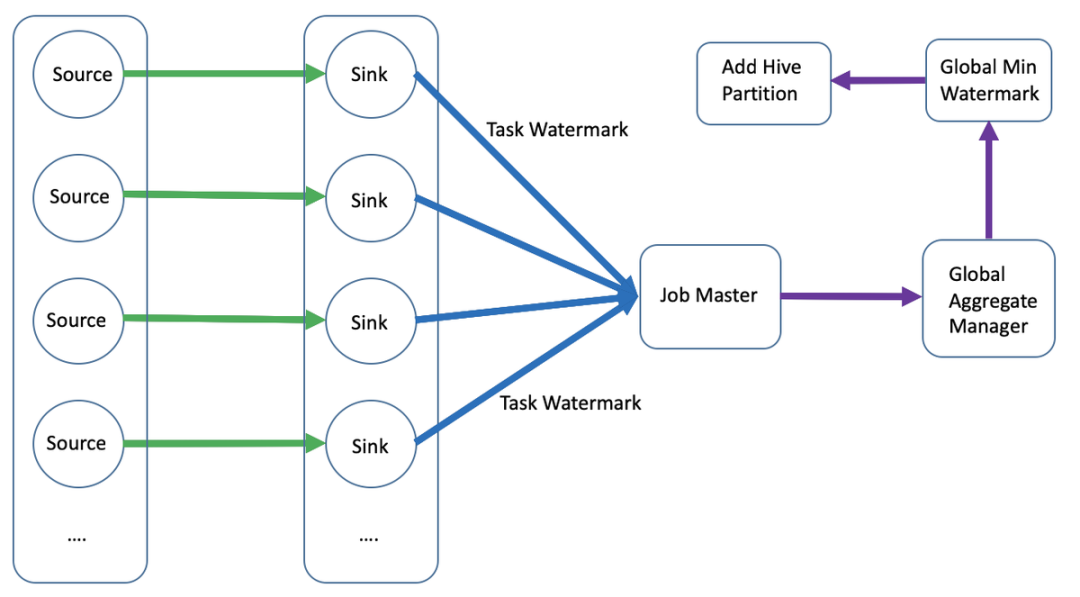

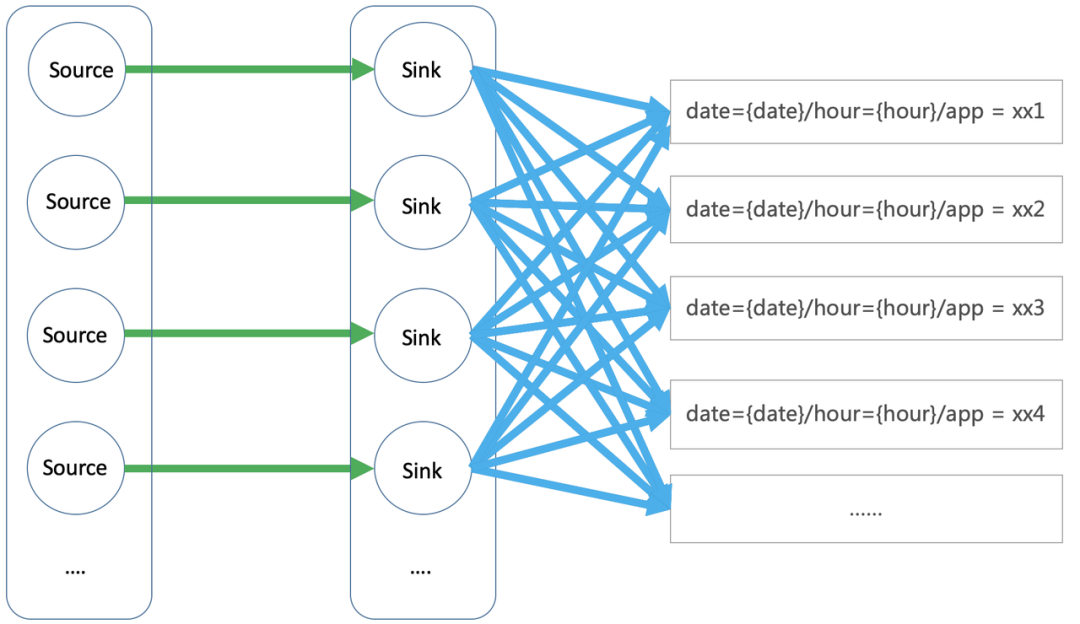

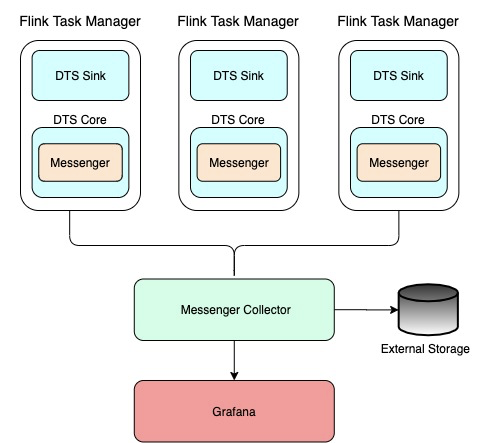

在數據中臺建設過程中,一個典型的數據集成場景是將 MQ (Message Queue,例如 Kafka、RocketMQ 等)的數據導入到 Hive 中,以供下游數倉建設以及指標統計。由于 MQ-Hive 是數倉建設第一層,因此對數據的準確性以及實時性要求比較高。

已有方案及痛點

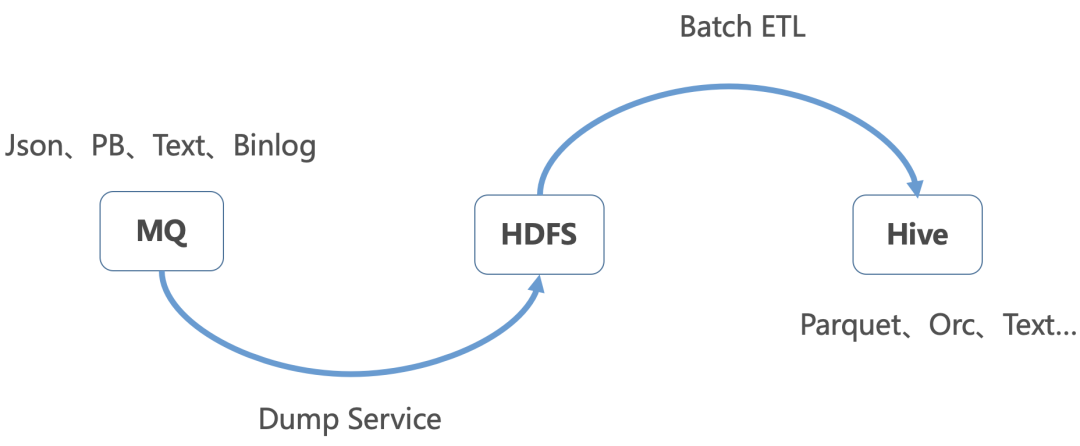

字節跳動內已有解決方案如下圖所示,主要分了兩個步驟:

通過 Dump 服務將 MQ 的數據寫入到 HDFS 文件

再通過 Batch ETL 將 HDFS 數據導入到 Hive 中,并添加 Hive 分區

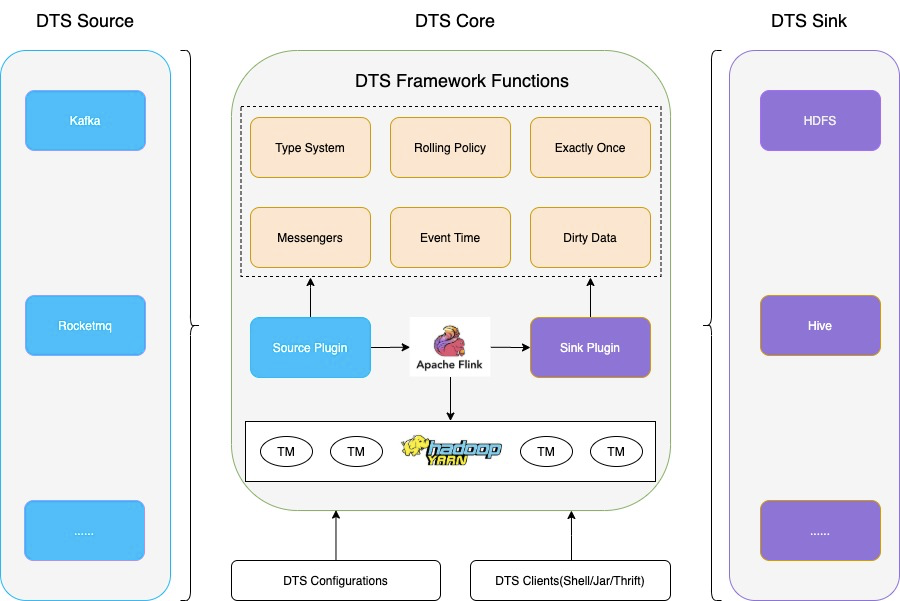

基于 Flink 實時解決方案

以上是“基于Flink的MQ-Hive實時數據集成如何實現字節跳動”這篇文章的所有內容,感謝各位的閱讀!希望分享的內容對大家有幫助,更多相關知識,歡迎關注億速云行業資訊頻道!

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。