您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

這篇文章主要介紹“spark內核RDD的count操作是什么”,在日常操作中,相信很多人在spark內核RDD的count操作是什么問題上存在疑惑,小編查閱了各式資料,整理出簡單好用的操作方法,希望對大家解答”spark內核RDD的count操作是什么”的疑惑有所幫助!接下來,請跟著小編一起來學習吧!

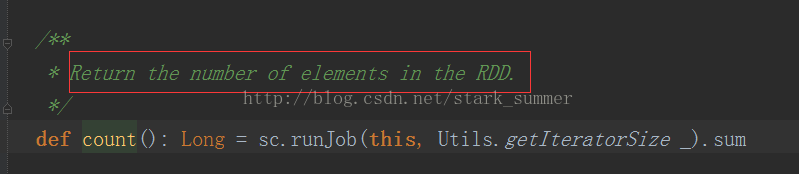

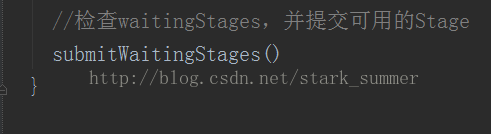

RDD源碼的count方法:

從上面代碼可以看出來,count方法觸發SparkContext的runJob方法的調用:

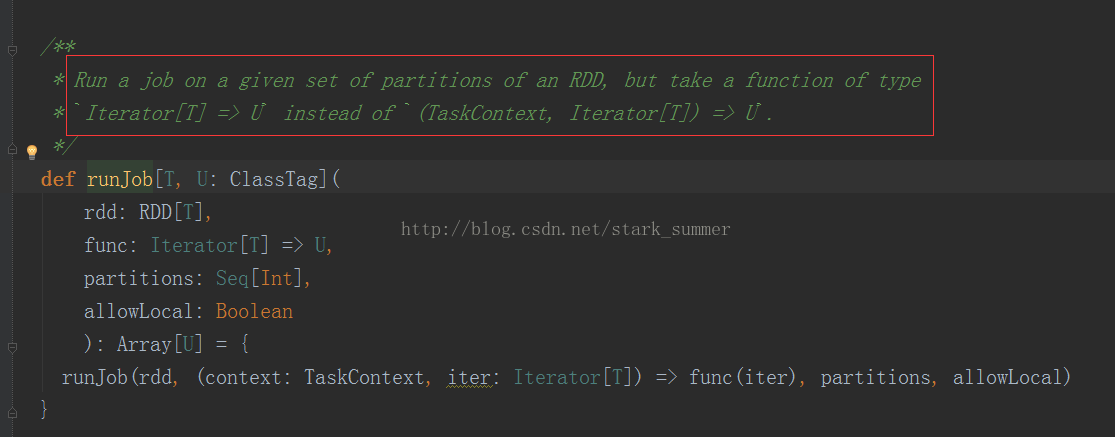

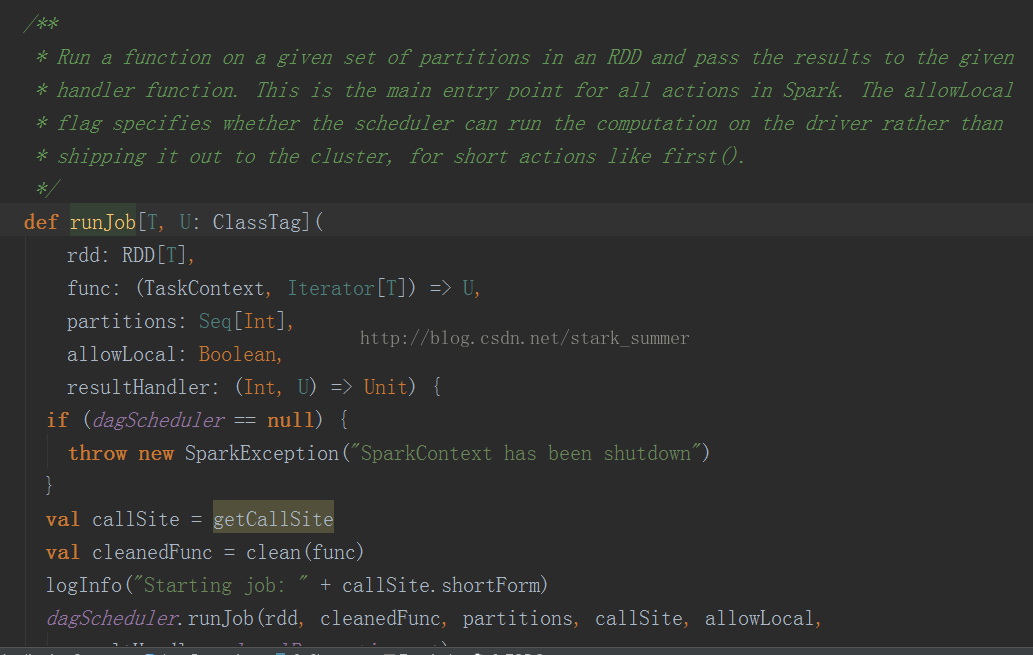

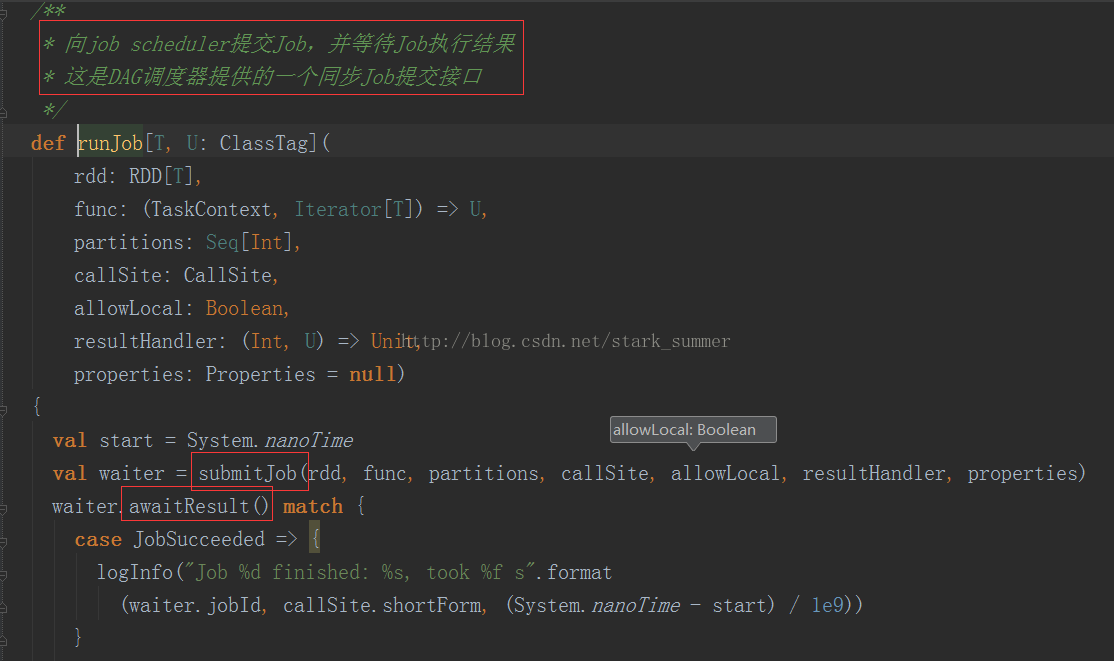

進一步跟蹤runJob(rdd, (context: TaskContext, iter: Iterator[T]) => func(iter), partitions, allowLocal)方法:

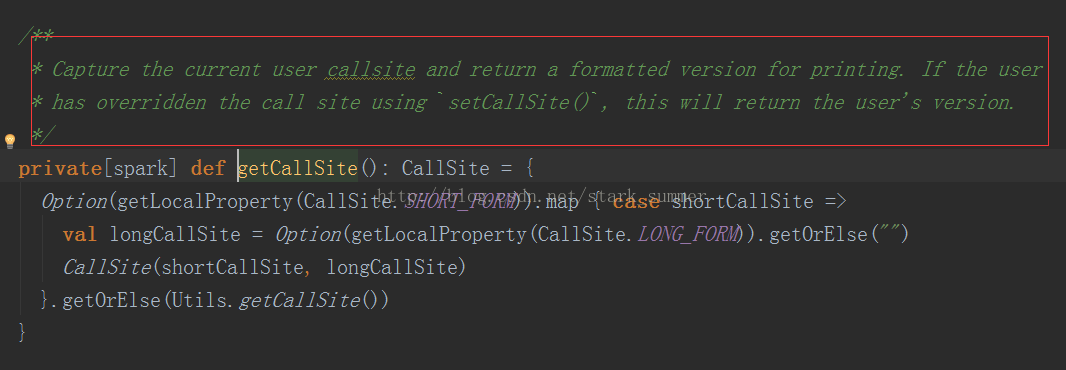

2、clean(func):

代碼分析:

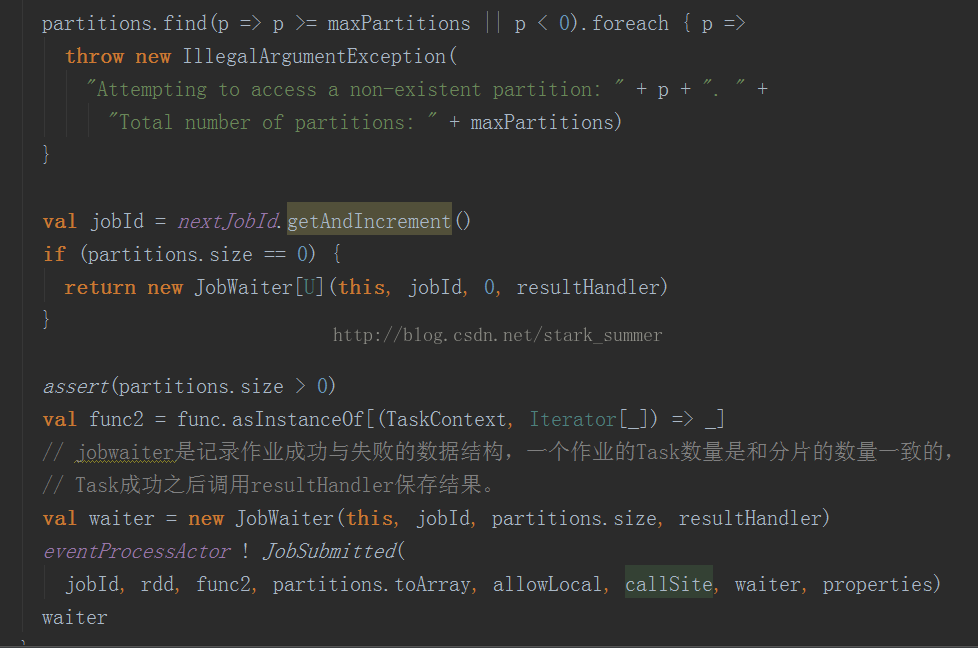

3.1、進入submitJob(rdd, func, partitions, callSite, allowLocal, resultHandler, properties):

上面代碼分析:

3.1.1、 進入new JobWaiter(this, jobId, partitions.size, resultHandler)方法

我們可以看出來,是給自己發消息的

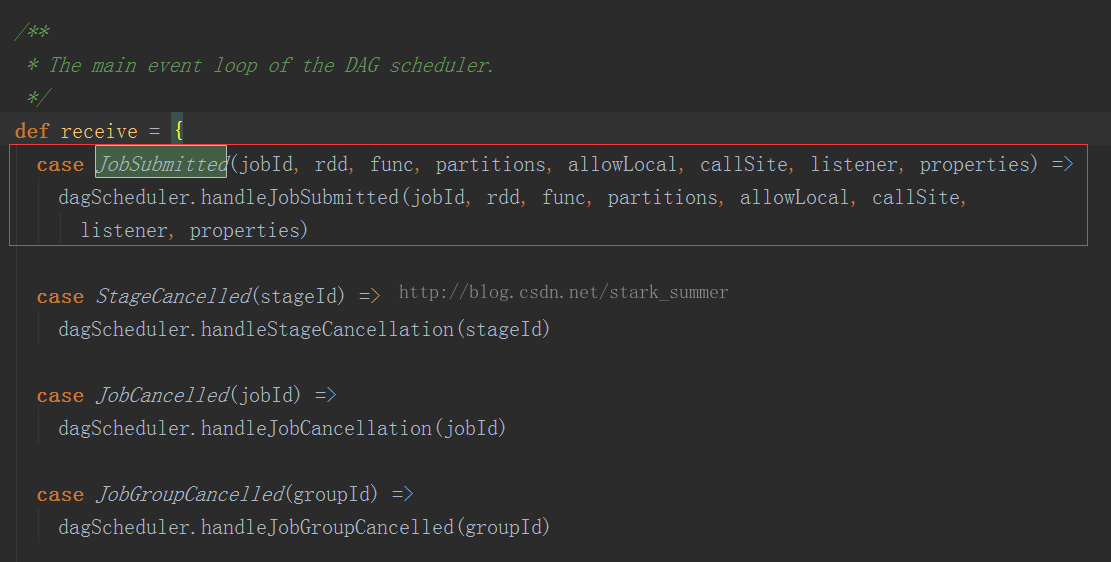

3.1.3、進入 dagScheduler.handleJobSubmitted(jobId, rdd, func, partitions, allowLocal, callSite,listener, properties)方法

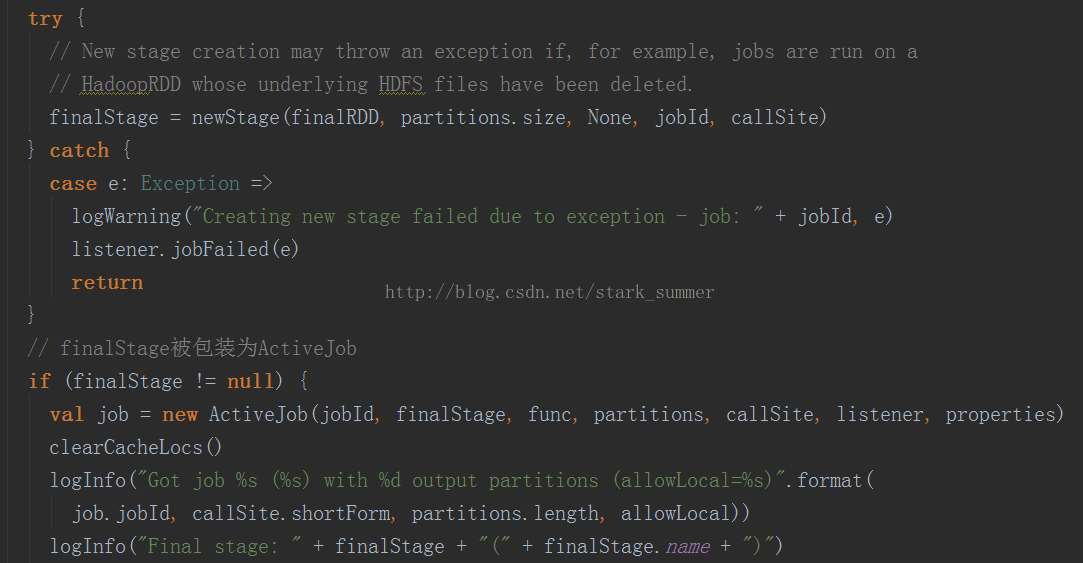

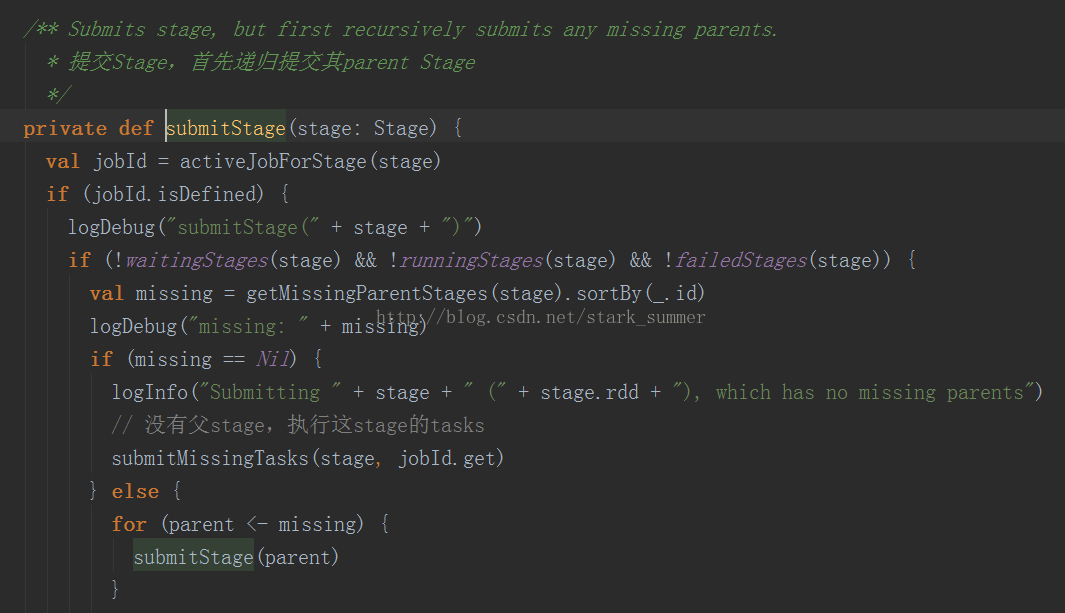

首先構建finalStage,然后又一個getMissingParentsStages方法,可以發現運行有本地運行和集群運行兩種模式,本地運行主要用于本地實驗和調試:

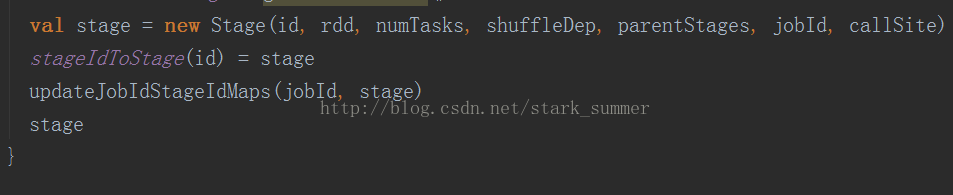

3.1.3.1、進入 finalStage = newStage(finalRDD, partitions.size, None, jobId, callSite)方法:

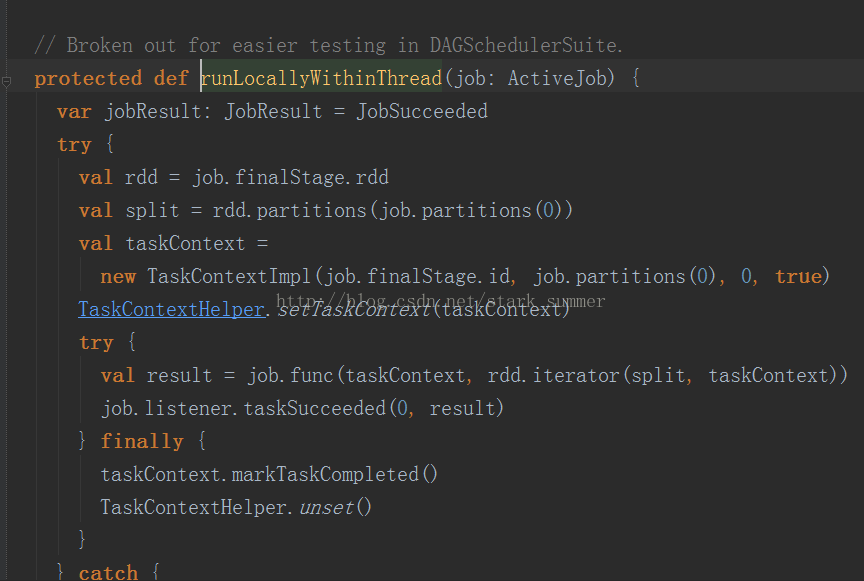

3.1.3.2、進入 runLocally(job)方法:

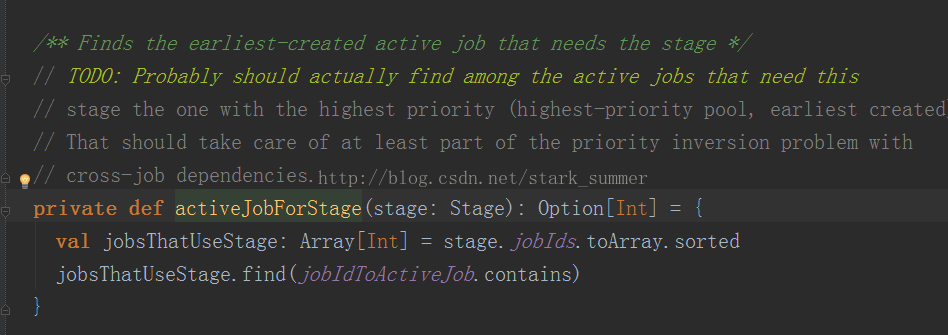

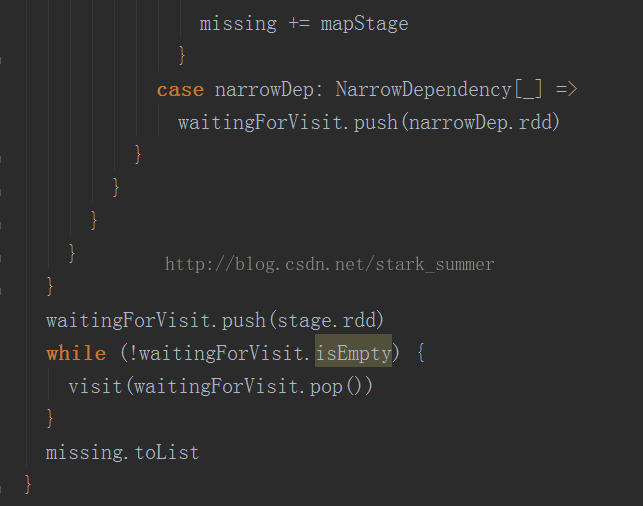

3.1.3.3.2、進入 getMissingParentStages(stage).sortBy(_.id) 方法:

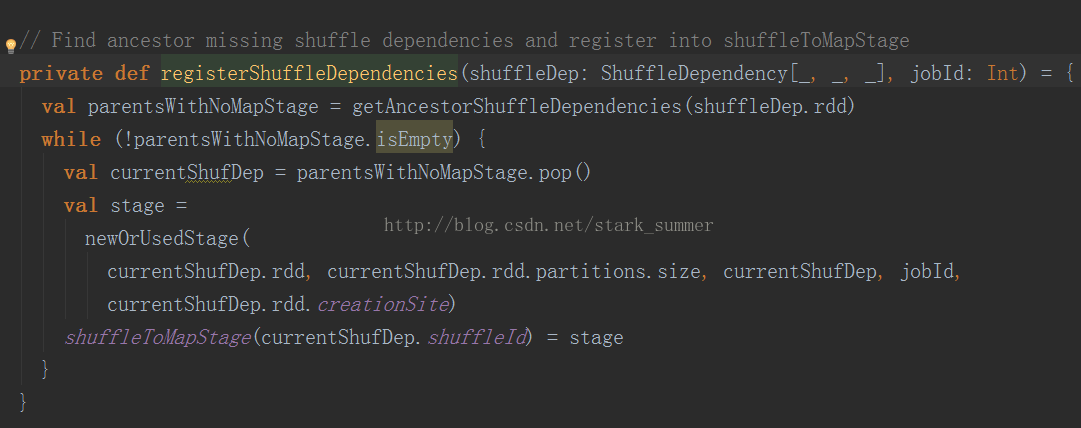

跟進getShuffleMapState方法:

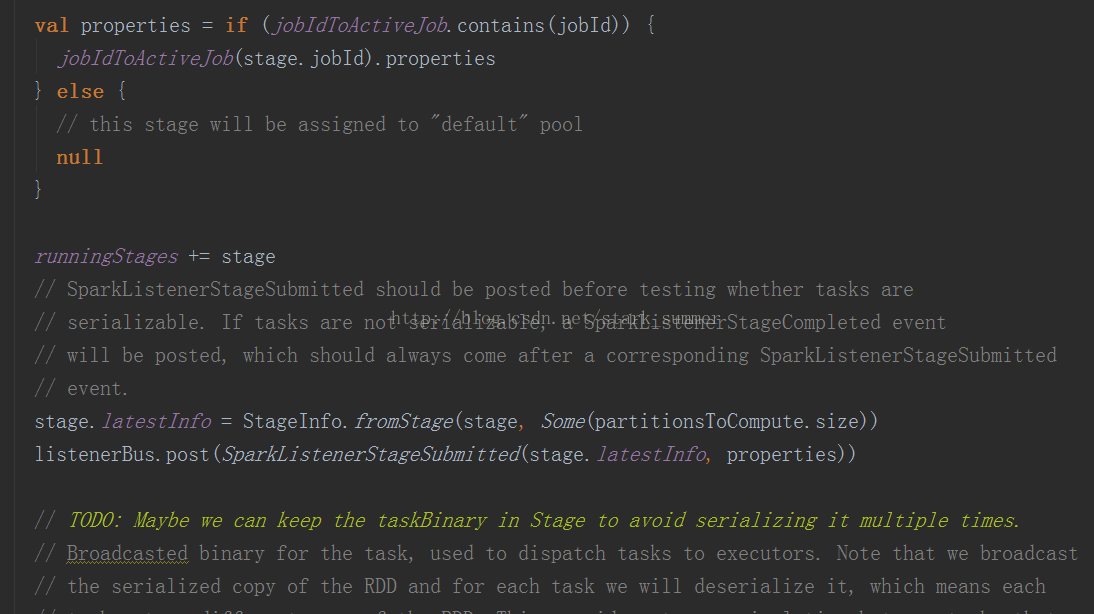

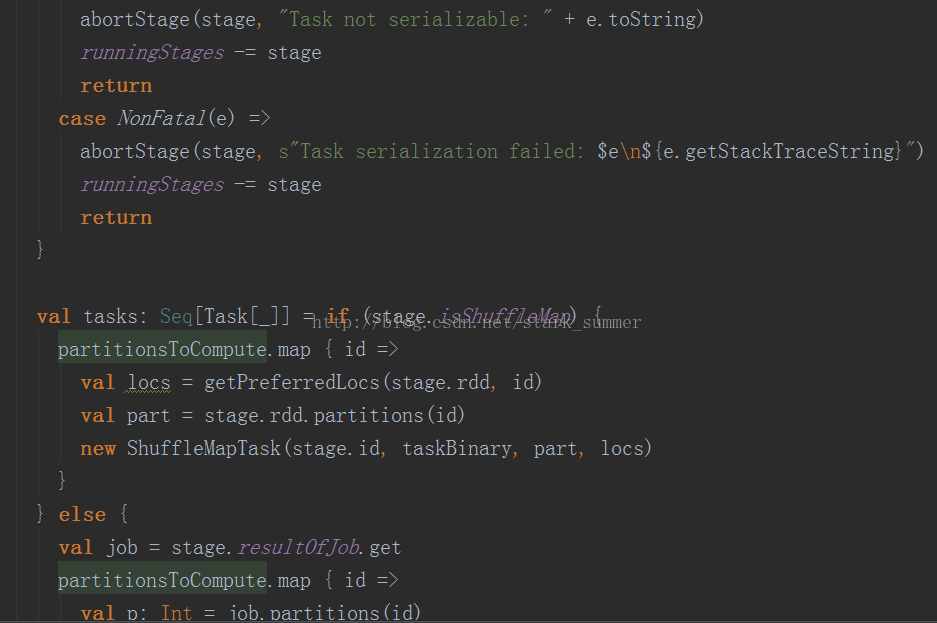

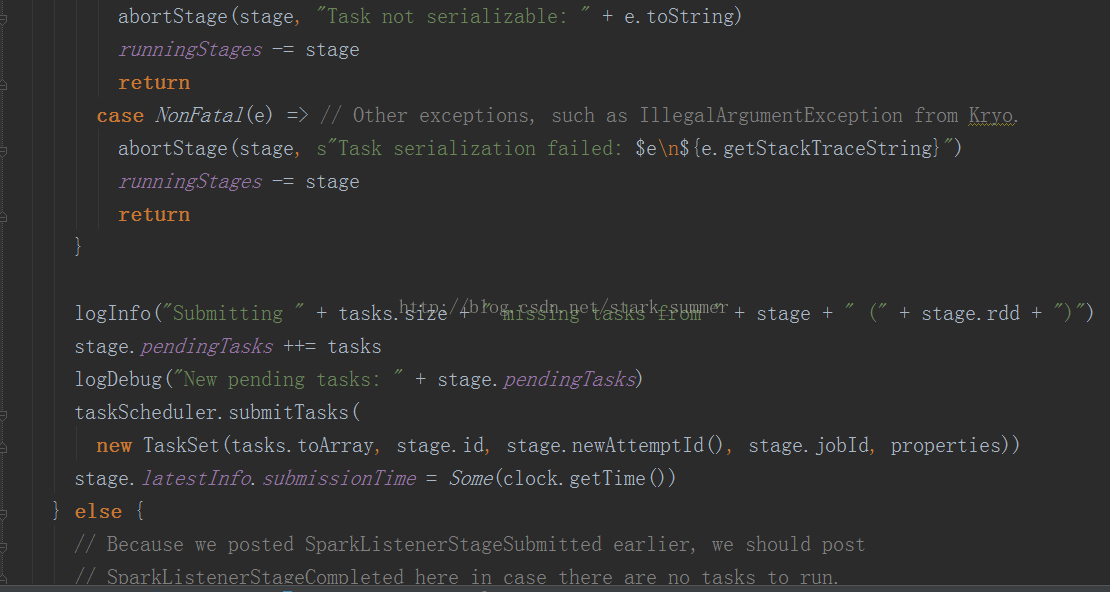

3.1.3.3.3、進入submitMissingTasks(stage, jobId.get) 方法:

到此,關于“spark內核RDD的count操作是什么”的學習就結束了,希望能夠解決大家的疑惑。理論與實踐的搭配能更好的幫助大家學習,快去試試吧!若想繼續學習更多相關知識,請繼續關注億速云網站,小編會繼續努力為大家帶來更多實用的文章!

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。