您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

這篇文章給大家介紹elasticsearch中如何使用ik中文分詞器,內容非常詳細,感興趣的小伙伴們可以參考借鑒,希望對大家能有所幫助。

# 下載地址 https://github.com/medcl/elasticsearch-analysis-ik/releases

直接從網絡地址安裝

cd /Users/huan/soft/elastic-stack/es/es02/bin # 下載插件 ./elasticsearch-plugin -v install https://github.com/medcl/elasticsearch-analysis-ik/releases/download/v7.12.0/elasticsearch-analysis-ik-7.12.0.zip # 查看插件是否下載成功 ./elasticsearch-plugin list

從本地安裝

cd /Users/huan/soft/elastic-stack/es/es02/bin # 下載插件(file后面跟的是插件在本地的地址) ./elasticsearch-plugin install file:///path/to/plugin.zip

注意:

如果本地插件的路徑中存在空格,需要使用雙引號包裝起來。

# 查找es進程 jps -l | grep 'Elasticsearch' # 殺掉es進程 kill pid # 啟動es /Users/huan/soft/elastic-stack/es/es01/bin/elasticsearch -d -p pid01

ik分詞器提供了2種分詞的模式

ik_max_word: 將需要分詞的文本做最小粒度的拆分,盡量分更多的詞。

ik_smart: 將需要分詞的文本做最大粒度的拆分。

語句

GET _analyze

{

"analyzer": "default",

"text": ["中文分詞語"]

}結果

{

"tokens" : [

{

"token" : "中",

"start_offset" : 0,

"end_offset" : 1,

"type" : "<ideographic>",

"position" : 0

},

{

"token" : "文",

"start_offset" : 1,

"end_offset" : 2,

"type" : "<ideographic>",

"position" : 1

},

{

"token" : "分",

"start_offset" : 2,

"end_offset" : 3,

"type" : "<ideographic>",

"position" : 2

},

{

"token" : "詞",

"start_offset" : 3,

"end_offset" : 4,

"type" : "<ideographic>",

"position" : 3

},

{

"token" : "語",

"start_offset" : 4,

"end_offset" : 5,

"type" : "<ideographic>",

"position" : 4

}

]

}可以看到默認的分詞器,對中文的分詞完全無法達到我們中文的分詞的效果。

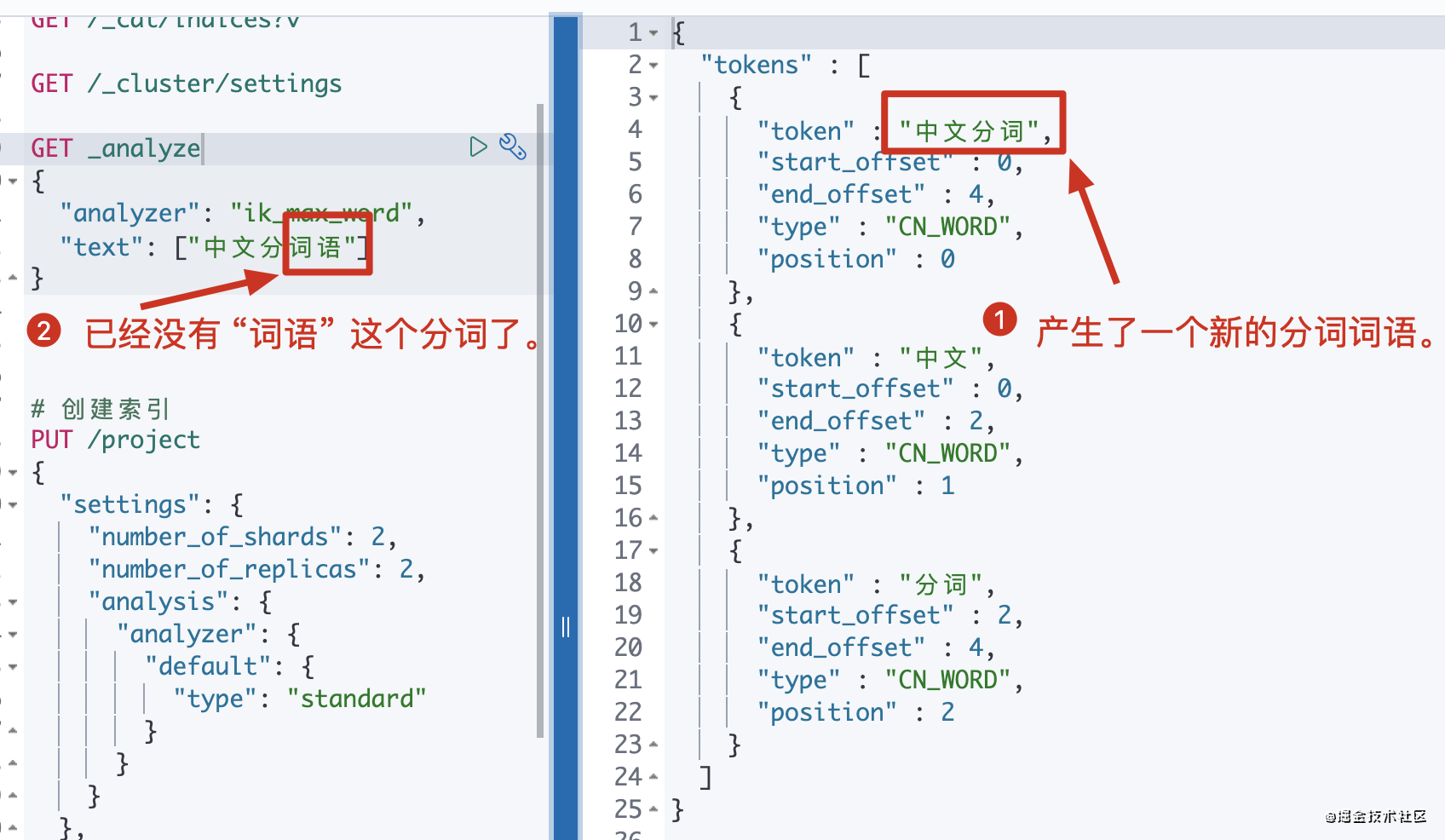

語句

GET _analyze

{

"analyzer": "ik_max_word",

"text": ["中文分詞語"]

}結果

{

"tokens" : [

{

"token" : "中文",

"start_offset" : 0,

"end_offset" : 2,

"type" : "CN_WORD",

"position" : 0

},

{

"token" : "分詞",

"start_offset" : 2,

"end_offset" : 4,

"type" : "CN_WORD",

"position" : 1

},

{

"token" : "詞語",

"start_offset" : 3,

"end_offset" : 5,

"type" : "CN_WORD",

"position" : 2

}

]

}可以看到基于ik分詞可以達到我們需要的分詞效果。

語句

GET _analyze

{

"analyzer": "ik_smart",

"text": ["中文分詞語"]

}結果

{

"tokens" : [

{

"token" : "中文",

"start_offset" : 0,

"end_offset" : 2,

"type" : "CN_WORD",

"position" : 0

},

{

"token" : "分",

"start_offset" : 2,

"end_offset" : 3,

"type" : "CN_CHAR",

"position" : 1

},

{

"token" : "詞語",

"start_offset" : 3,

"end_offset" : 5,

"type" : "CN_WORD",

"position" : 2

}

]

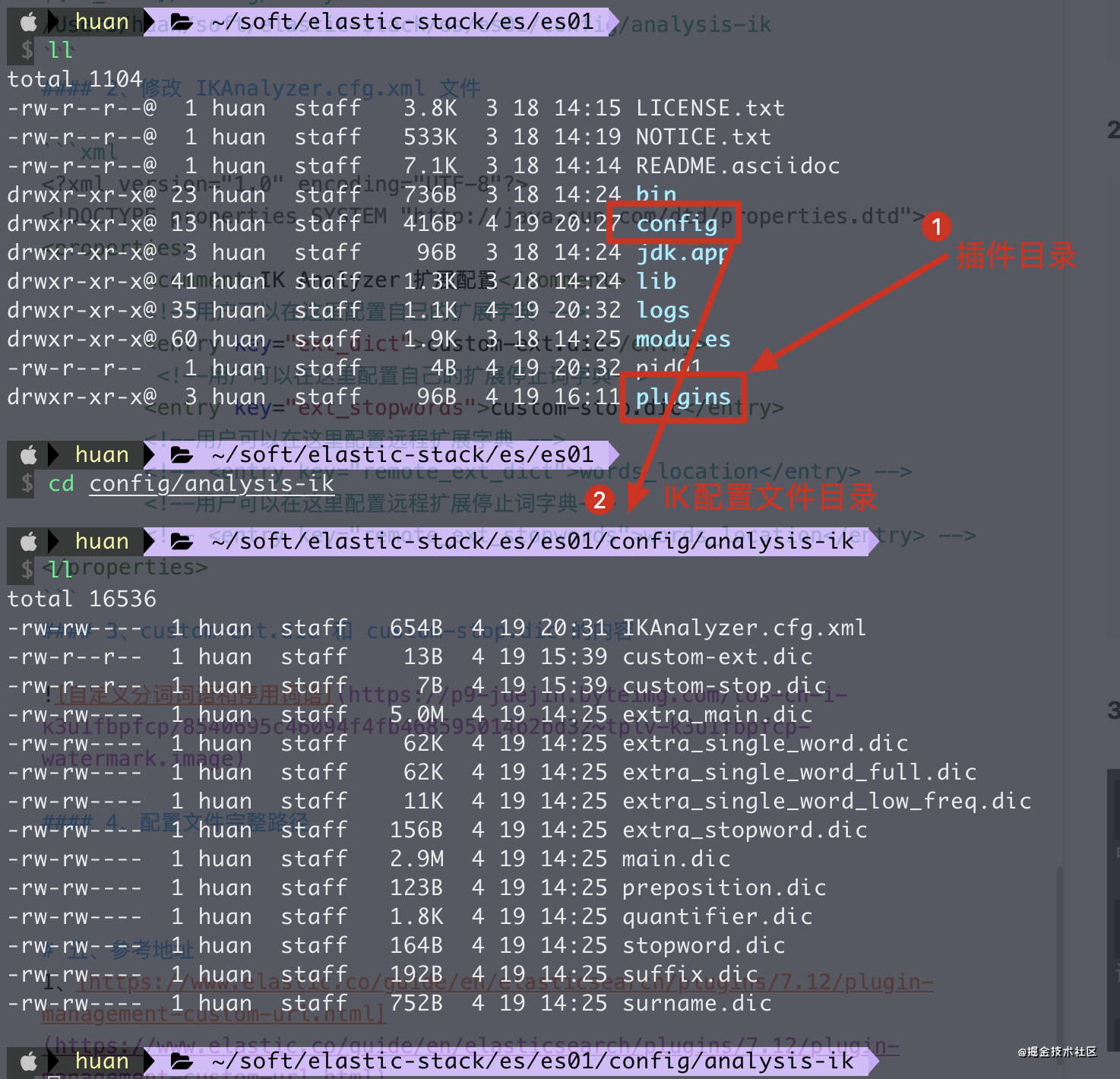

}${IK_HOME}/config/analysis-ik

/Users/huan/soft/elastic-stack/es/es01/config/analysis-ik<!--?xml version="1.0" encoding="UTF-8"?--> <properties> <comment>IK Analyzer 擴展配置</comment> <!--用戶可以在這里配置自己的擴展字典 --> <entry key="ext_dict">custom-ext.dic</entry> <!--用戶可以在這里配置自己的擴展停止詞字典--> <entry key="ext_stopwords">custom-stop.dic</entry> <!--用戶可以在這里配置遠程擴展字典 --> <!-- <entry key="remote_ext_dict">words_location</entry> --> <!--用戶可以在這里配置遠程擴展停止詞字典--> <!-- <entry key="remote_ext_stopwords">words_location</entry> --> </properties>

注意:

1、自定義分詞的文件必須是UTF-8的編碼。

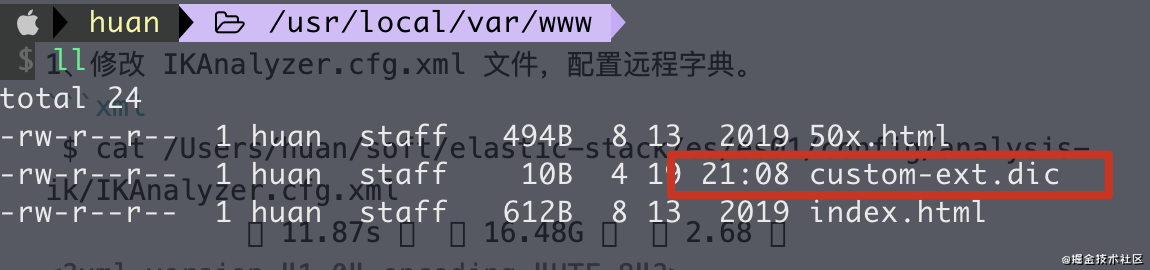

1、修改 IKAnalyzer.cfg.xml 文件,配置遠程字典。

$ cat /Users/huan/soft/elastic-stack/es/es01/config/analysis-ik/IKAnalyzer.cfg.xml 11.87s ? 16.48G ? 2.68 ? <!--?xml version="1.0" encoding="UTF-8"?--> <properties> <comment>IK Analyzer 擴展配置</comment> <!--用戶可以在這里配置遠程擴展字典 --> <entry key="remote_ext_dict">http://localhost:8686/custom-ext.dic</entry> <!--用戶可以在這里配置遠程擴展停止詞字典--> <entry key="remote_ext_stopwords"></entry> </properties>

注意:

1、此處的 custom-ext.dic 文件在下方將會配置到 nginx中,保證可以訪問。

2、http 請求需要返回兩個頭部(header),一個是 Last-Modified,一個是 ETag,這兩者都是字符串類型,只要有一個發生變化,該插件就會去抓取新的分詞進而更新詞庫。

3、http 請求返回的內容格式是一行一個分詞,換行符用 \n 即可。 4、在 nginx 的目錄下放置一個 custom-ext.dic 文件

多次修改 custom-ext.dic 文件,可以看到分詞的結果也會實時變化,如此就實現了分詞的熱更新。

關于elasticsearch中如何使用ik中文分詞器就分享到這里了,希望以上內容可以對大家有一定的幫助,可以學到更多知識。如果覺得文章不錯,可以把它分享出去讓更多的人看到。

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。