您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

小編給大家分享一下Python怎么實現爬取豆瓣電影信息功能,相信大部分人都還不怎么了解,因此分享這篇文章給大家參考一下,希望大家閱讀完這篇文章后大有收獲,下面讓我們一起去了解一下吧!

具體如下:

本案例的任務為,爬取豆瓣電影top250的電影信息(包括序號、電影名稱、導演和主演、評分以及經典臺詞),并將信息作為字典形式保存進txt文件。這里只用到requests庫,沒有用到beautifulsoup庫

step1:首先獲取每一頁的源代碼,用requests.get函數獲取,為了防止請求錯誤,使用try...except..

def getpage(url): try: res=requests.get(url) if res.status_code==200: return res.text return None except RequestException: return None

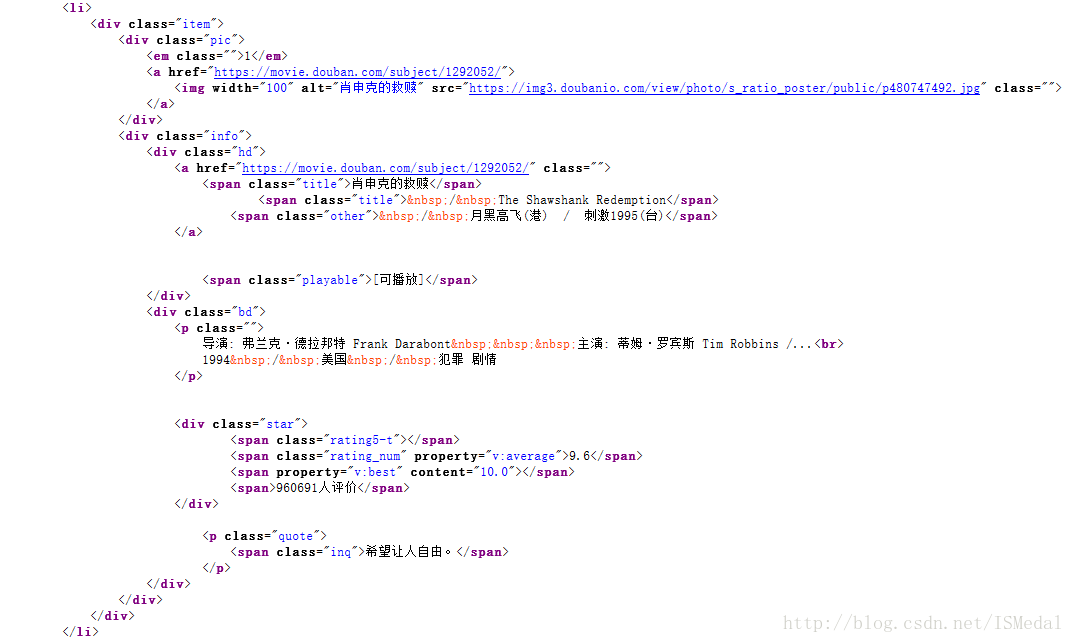

step2:做每一頁的網址解析,打開原網址https://movie.douban.com/top250?,查看網頁源代碼,可以看到每一個電影的源代碼都是從<li>開始,在</li>處結束,寫好正則表達式以后爬到的列表的每一條item都有五個元素,因此將其寫成字典的形式,這里用到yield函數(關于yield函數的用法,廖老師的有一篇文章比較好懂https://www.ibm.com/developerworks/cn/opensource/os-cn-python-yield/)

對單個網頁的進行解析的代碼如下:

def parsepage(html):

pat=re.compile('<li>.*?<em class="">(.*?)</em>.*?<img width="100" alt="(.*?)" src=.*?<p class="">'

+'(.*?)</p>.*?property="v:average">(.*?)</span>.*?<span class="inq">(.*?)</span>.*?</li>',re.S)

items=re.findall(pat,html)

for item in items:

yield{

'index':item[0],

'title':item[1],

'stars':item[2].strip(),

'score':item[3],

'concept':item[4]

}下面的代碼是將每一個item寫入文件,這里encoding='utf-8' 和ensure_ascii=False都是使寫入文件時中文能保持不變,json.dumps可以將(字典)對象轉化成字符串(但前面要先import json),with open的第二個參數為a,表示每次寫入時,是往后追加(續接),而不是后一次寫入將之前內容覆蓋,\n是指要每一次寫入一個item之后要換行。

def write_tofile(content):

with open('doubanfilms.txt','a',encoding='utf-8' ) as f:

f.write(json.dumps(content,ensure_ascii=False)+'\n')

f.close()最后,需要用循環語句將每一頁(共10頁)內容都進行以上操作。這里,第二頁的網址就是在第一頁的url上加上一個start=25, 第三頁是加上start=50,也就是每一頁的start=為25*i。最后一段代碼如下:

def main(): url="https://movie.douban.com/top250?" for i in range(0,9): url_i=url+'start='+str(25*i) html_i=getpage(url_i) for item in parsepage(html_i): print(item) write_tofile(item) if __name__ == '__main__': main()

當然,這一段代碼還有一種寫法:

def main(start): url="https://movie.douban.com/top250?start="+str(start) html=getpage(url) for item in parsepage(html): print(item) write_tofile(item) if __name__ == '__main__': for i in range(10): main(i*10)

如果想讓你的程序跑的更快,可以用多線程爬蟲(當然這里其實沒有必要):

#在最開始加載Pool包 from multiprocessing import Pool #最后的執行段改為: if __name__ == '__main__': for i in range(10): main(i*10) pool=Pool() #在循環外寫 pool.map(main,[i*10 for i in range (10)])

以上是“Python怎么實現爬取豆瓣電影信息功能”這篇文章的所有內容,感謝各位的閱讀!相信大家都有了一定的了解,希望分享的內容對大家有所幫助,如果還想學習更多知識,歡迎關注億速云行業資訊頻道!

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。