您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

本篇內容介紹了“Linux系統性能優化實用命令有哪些”的有關知識,在實際案例的操作過程中,不少人都會遇到這樣的困境,接下來就讓小編帶領大家學習一下如何處理這些情況吧!希望大家仔細閱讀,能夠學有所成!

Linux是一套免費使用和自由傳播的類Unix操作系統,Linux不同的發行版本和不同的內核對各項參數及設置均做了改動,從而使得系統能夠獲得更好的性能。

命令:hdparm -t /dev/sda5 打印:Timing buffered disk reads: 254 MB in 3.01 seconds = 84.34 MB/sec 說明:能夠指定具體的哪塊硬盤進行查詢的哦!

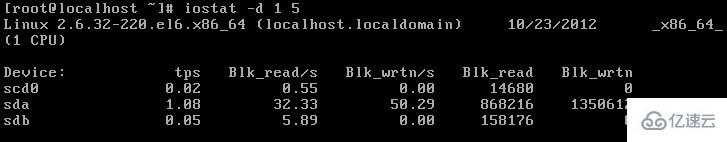

格式:iostat [ -c | -d ] [ -k ] [ -t ] [ -V ] [ -x [ device ] ] [ interval ] 描述:iostat是I/O statistics(輸入/輸出統計)的縮寫,iostat工具將對系統的磁盤操作活動進行監視。它的特點是匯報磁盤活動統計情況,同時也會匯報出CPU使用情況,同vmstat一樣,iostat也有一個弱點,就是它不能對某個進程進行深入分析,僅對系統的整體情況進行分析,每1秒檢測統計一次(共5次)。

blk_read/s 每秒讀取的數據塊數

blk_wrtn/s 每秒寫入的數據塊數

blk_read 表示讀取的所有數據塊數

blk_wrtn 表示寫入的所有數據塊數

名稱:報告虛擬內存的統計信息 格式:vmstat [-n] [延時[次數]]

| R: | 運行和等待CPU時間片的進程數。長期大于CPU的個數,代表CPU不足 |

|---|---|

| B: | 等待資源的進程數,如果等待數量多,問題有可能處在I/O或者內存 |

| Swpd: | 切換到內存交換區的內存大小[以KB為單位] |

| free: | 當前空閑的物理內存數量[以KB為單位] |

| si: | 由磁盤調入內存 |

| so: | 由內存調入磁盤 |

| bi: | 從塊設備讀入數據的總量 |

| bo: | 寫到塊設備的數據總量 |

| bi+bo | 1000 如果超過1000,代表硬盤的讀寫速度有問題 |

| in: | 在某一時間間隔內觀測到的每秒設備中斷數[中斷數太多對性能不好] |

| cs: | 列表示每秒產生的上下文切換次數 |

| us+sy > 80% | 代表CPU資源不足 |

| us: | 用戶進程消耗的CPU時間百分比 |

| sy: | 內核進程消耗的CPU時間百分比 |

| id: | CPU處在空閑狀態的時間百分比 |

| wa: | IO等待所占用的時間百分比 |

| runq-sz: | 內存中可以運行的進程數 |

| plist-sz: | 系統中活躍的任務個數 |

任務計劃 /etc/cron.d/sysstat 日志目錄 /var/log/sa 查看方法 Sar –q –f /var/log/sa/sa10

dmesg 顯示出開機啟動的信息 lscpu 顯示CPU信息 lscpu -p 顯示CPU對應的節點數 getconf LONG_BIT 獲知主機的位數 getconf -a 查看全部的參數 /sys/class/dmi/id 可以查看Bios的信息 bios_*

6,strace顯示程序的調用:

strace –fc elinks –dump http://localhost

?

預先讀取需要寫入的量,然后再處理寫請求,↑讀到的值將會是設置值的一半↑。

設置讀取到緩存中的數值越大.寫入時就會因為數據量大而速度變慢。/sys/block/sda/queue/nr_requests 隊列長度越大,硬盤IO速度會提升,但占用內存

/sys/block/sda/queue/scheduler 調度算法Noop、anticipatory、deadline、[cfq]

?

1、創建200M的/dev/sdb1 格式化為ext3 2、dumpe2fs /dev/sdb1查看文件系統功能中包含的has_journal 3、Tune2fs –O ^has_journal /dev/sdb1 去掉默認原有的日志功能 4、再分一個200M的分區./dev/sdb2. 日志卷的block必須等于 /dev/sdb1 Mke2fs –O journal_dev –b 1024 /dev/sdb2 5、將/dev/sdb2作為/dev/sdb1的日志卷. Tune2fs –j –J device=/dev/sdb2 /dev/sdb1

對于網站文件,頻繁的修改atime是沒有意義的,會影響性能 mount –o remount,noatime DEVICE 即可

默認是5秒提交一次日志,修改更長時間可以提高性能,但容易丟失數據。 mount –o remount,commit=15 DEVICE

?

chunk size.輪循一次寫入的字節.默認是64K,只要沒有寫滿,就不會移動到下一個設備

設置在每個硬盤都只寫一個文件就切換到下一塊硬盤,那么如果都是1K的小文件,就會將系統資源浪費在切換硬盤上

如果將chunk size的值設置很大,比如100M,那么也就沒有了意義,還不如用一塊硬盤。

Stripe size.條帶大小,并不是有數據就寫入,而是設置每次寫入的數據量,一般是16K寫一次。

所以.Chunk size(64K)/stripe size(16K),也就是說每塊硬盤寫四次。

————————————算當前應該把chunk size調成多少————————————

使用iostat –x查看自開機以來每秒的平均請求數avgrq-sz

chunk size = 每秒請求數*512/1024/磁盤數,取一個最緊接2倍數的整數

stride = chunk size /block(默認是4k)創建raid并設置chunk sinze

mdadm –C /dev/md0 –l 0 –n3 –chunk=8 /dev/sdb[123] 修改raid

mke2fs –j –b 4096 –E stride=2 /dev/md0

dumpe2fs /dev/sda1 tune2fs –m 10 /dev/sda1 保留block百分比 tune2fs –r 保留block數 保留的block過少,影響性能,保留的過多又浪費硬盤,默認是5%

“Linux系統性能優化實用命令有哪些”的內容就介紹到這里了,感謝大家的閱讀。如果想了解更多行業相關的知識可以關注億速云網站,小編將為大家輸出更多高質量的實用文章!

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。