您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

requests.gPython用requests.get獲取網頁內容為空的問題怎么解決,針對這個問題,這篇文章詳細介紹了相對應的分析和解答,希望可以幫助更多想解決這個問題的小伙伴找到更簡單易行的方法。

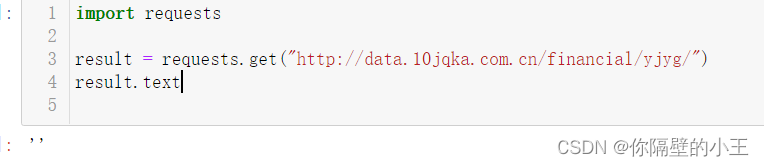

下面先來看一個例子:

import requests

result=requests.get("http://data.10jqka.com.cn/financial/yjyg/")

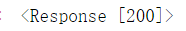

result輸出結果:

表示成功處理了請求,一般情況下都是返回此狀態碼; 報200代表沒問題

繼續運行,發現返回空值,在請求網頁爬取的時候,輸出的text信息中會出現抱歉,無法訪問等字眼,這就是禁止爬取,需要通過反爬機制去解決這個問題。headers是解決requests請求反爬的方法之一,相當于我們進去這個網頁的服務器本身,假裝自己本身在爬取數據。對反爬蟲網頁,可以設置一些headers信息,模擬成瀏覽器取訪問網站 。

拿兩個常用的瀏覽器舉例:

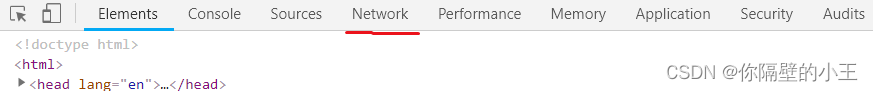

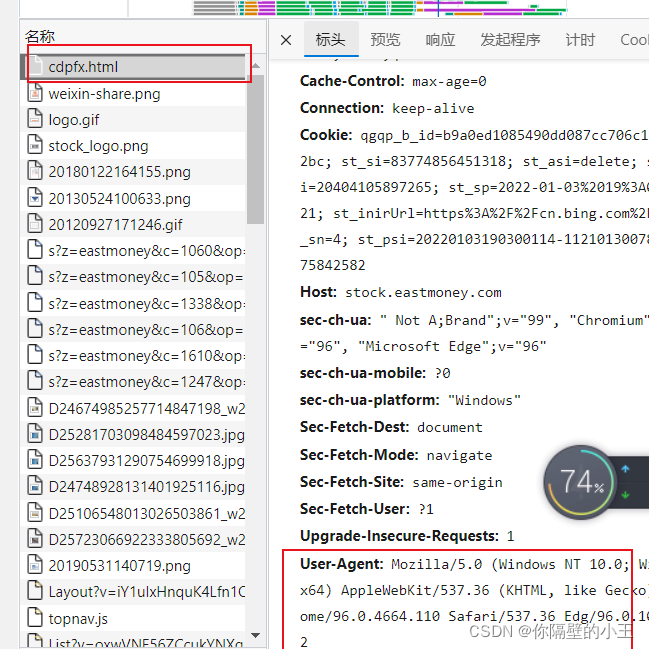

界面 F12

點擊network 鍵入 CTRL+R

單擊第一個 最下邊就是我門需要的 把他設置成headers解決問題

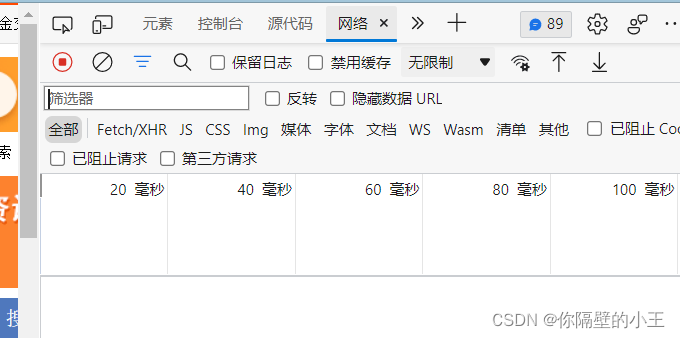

同樣 F12 打開開發者工具

點擊網絡,CTRL+R

前文代碼修改:

import requests

ur="http://data.10jqka.com.cn/financial/yjyg/"

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/70.0.3538.25 Safari/537.36 Core/1.70.3880.400 QQBrowser/10.8.4554.400 '}

result = requests.get(ur, headers=headers)

result.text成功解決不能爬取問題。

關于requests.gPython用requests.get獲取網頁內容為空的問題怎么解決問題的解答就分享到這里了,希望以上內容可以對大家有一定的幫助,如果你還有很多疑惑沒有解開,可以關注億速云行業資訊頻道了解更多相關知識。

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。