您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

Hadoop

hadoop-1.2.1.tar.gz jdk-6u32-linux-x64.bin

Useradd -u 900 hadoop

Mv jdk1.6.0_32 /home/hadoop

Mv hadoop-1.2.1.tar.gz/home/hadoop

Chown hadoop.hadoop /home/hadoop -R

Su -hadoop

Ln -s jdk1.6.0_32 java

Tar zxf hadoop-1.2.1.tar.gz hadoop-1.2.1

Ln -s hadoop-1.2.1 hadoop

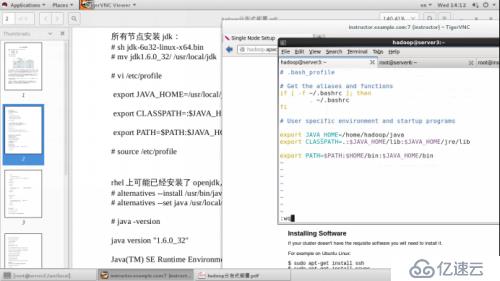

更改環境變量:

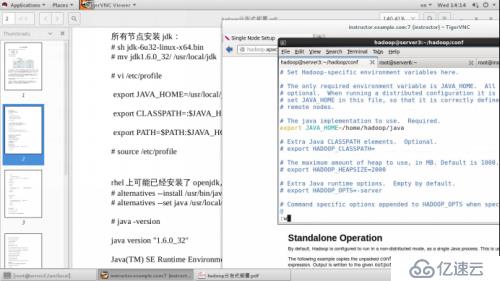

Vim /hadoop/conf/hadoop-env.sh

Cd /hadoop

Mkdir input

Cp conf/*.xml input

Bin/hadoop jar hadoop-examples-1.2.1.jar grep input output ‘dfs[a-z.]+’

設置無密碼登陸:

Ssh-keygen

Ssh-copy-id 172.25.60.1

保證 master 到所有的 slave 節點都實現無密碼登錄

Cd ~/hadoop/conf

Vim slaves ---->172.25.60.1

Vim masters---->172.25.60.1

Vim core-site.xml 在configuration中間添加以下內容

<configuration>

<property>

<name>fs.default.name</name>

<value>hdfs://172.25.60.1:9000</value>

</property>

</configuration>

Vim hdfs-site.xml 在configuration中間添加以下內容

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration>

Vim mapred-site.xml 在configuration中間添加以下內容

<configuration>

<property>

<name>mapred.job.tracker</name>

<value>172.25.60.1:9001</value>

</property>

</configuration>

格式化一個新的分布式文件系統:

$ bin/hadoop namenode -format

啟動 Hadoop 守護進程:

$ bin/start-all.sh

在各個節點查看 hadoop 進程:

$ jps

Hadoop 守護進程的日志寫入到 ${HADOOP_HOME}/logs 目錄

瀏覽 NameNode 和 JobTracker 的網絡接口,它們的地址默認為:

NameNode – http://172.25.60.1:50070/

JobTracker – http://172.25.60.1:50030/

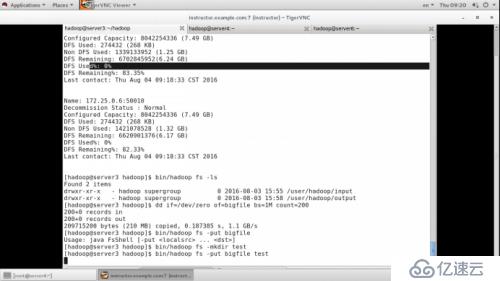

將輸入文件拷貝到分布式文件系統:

$ bin/hadoop fs -put conf input

運行發行版提供的示例程序:

$ bin/hadoop jar hadoop-*-examples.jar grep input output 'dfs[a-z.]+'

查看輸出文件:

將輸出文件從分布式文件系統拷貝到本地文件系統查看:

$ bin/hadoop fs -get output output

$ cat output/*

或者

在分布式文件系統上查看輸出文件:

$ bin/hadoop fs -cat output/*

完成全部操作后,停止守護進程:

$ bin/stop-all.sh

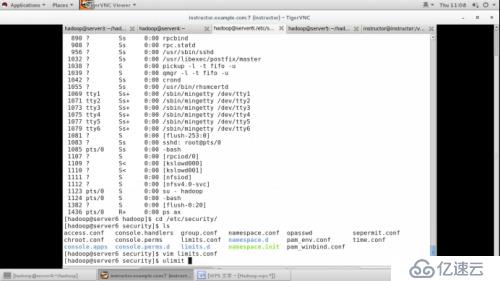

完全分布式(三個節點)server1 server2 server4:

在三個節點上安裝 rpcbind nfs-utils 并打開rpcind nfs服務

Vim /etc/exports

/home/hadoop *(rw,all_squash,anonuid=900,anongid=900)

在slave2 4上添加用戶 useradd -u 900 hadoop

mount 172.25.60.1:/home/hadoop/ /home/hadoop/

在1上分別進行ssh 連接 ssh 172.25.60.2ssh272.25.60.4

在master上:vim ~/hadoop/conf

Vim slaves

172.25.60.2

172.25.60.4

Vim hdfs-site.xml

<Value>1</value> ------> <Value>2</value>

(刪除tmp------>格式化---->bin/start-dfs.sh----->bin/hadoop fs -put conf/ input----->bin/start-mapred.sh

bin/hadoop jar hadoop-examples-1.2.1.jar grep input output 'dfs[a-z.]+')

bin/hadoop dfsadmin-report:查看節點運行狀態

bin/hadoop fs -ls :查看輸出文件

添加一個節點文件:

在線添加節點:

添加用戶 useradd -u 900 hadoop

mount 172.25.60.1:/home/hadoop/home/hadoop

su - hadoop

vim slaves加入該節點 ----->>172.25.60.5

bin/hadoop-daemon.sh start datanode

bin/hadoop-daemon.sh start tasktracker

在線刪除節點:

先做數據遷移:

在server上:vim mapred-site.xml

<property>

<name>dfs.hosts.exclude</name>

<value>/home/hadoop/hadoop/conf/hostexclude</value>

</property>

Vim hadoop/hadoop/conf/hostexclude------->172.25.60.4

Bin/hadoop dfsadmin -refreshNodes ####刷新節點

回收站功能:

vimcore-site.xml添加以下:

<property>

<name>fs.trash.interval</name>

<value>1440</value> 1440=60*24

</property>

實驗:bin/hadoop fs -rm input/hadoop-env.sh

bin/hadoop fs -ls input 查看是否刪除

bin/hadoop fs -ls 此時新增目錄 .Trash

bin/hadoop fs -ls .Trash/Current/user/hadoop/input

將此文件移回原目錄即可恢復

bin/hadoop fs -mv .Trash/Current/user/hadoop/input/hadoop-env.sh input

優化:

更新hadoop至2.6版本

刪除之前的鏈接,解壓hadoop-2.6.4.tar.gz jdk-7u79-linux-x64.tar.gz到hadoop家目錄,并更改權限為hadoop.hadoop進入hadoop用戶,鏈接成hadoop和java,進入hadoop/etc/hadoop/

vim hadoop-env.sh export JAVA_HOME=/home/hadoop/java

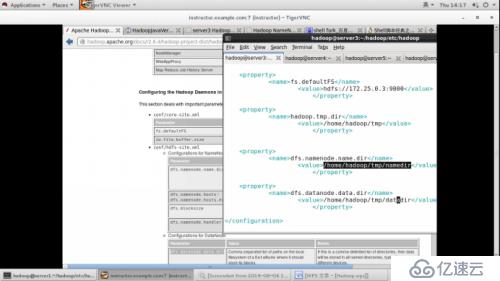

cd /hadoop/etc/hadoop

vim core-site.xml

<property>

<name>fs.defaultFS</name>

<value>hdfs://172.25.60.1:9000</value>

</property>

vim hdfs-site.xml

<property>

<name>dfs.replication</name>

<value>2</value>

</property>

vim yarn-env.sh

# some Java parameters

export JAVA_HOME=/home/hadoop/java

cp mapred-site.xml.template mapred-site.xml

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

vim yarn-site.xml

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

vim slaves

172.25.60.4

172.25.60.5

bin/hdfs namenode -format

sbin/start-dfs.sh

bin/hdfs dfs -mkdir /user

bin/hdfs dfs -mkdir /user/hadoop

bin/hdfs dfs -put etc/hadoop input

sbin/start-yarn.sh

bin/hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.6.4.jar grep input output 'dfs[a-z.]+'

訪問 172.25.60.1:50070 172.25.60.1:8088

##########替換lib下文件為64位(不更改的話啟動時會有warn警告)

mv hadoop-native-64-2.6.0.tar /home/hadoop/hadoop/lib/native

tarxf hadoop-native-64-2.6.0.tar

###########指定節點目錄

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。