溫馨提示×

您好,登錄后才能下訂單哦!

點擊 登錄注冊 即表示同意《億速云用戶服務條款》

您好,登錄后才能下訂單哦!

上一遍文章中其實最主要的就是JAVA環境變量以及hadoop環境變量的設置,這兩個設置好了的話,運行hadoop基本上不會出問題。

在hadoop的基礎上安裝spark好簡單。

安裝Spark之前需要先安裝Hadoop集群,因為之前已經安裝了hadoop,所以我直接在之前的hadoop集群上安裝spark。

硬件環境:

hddcluster1 10.0.0.197 redhat7

hddcluster2 10.0.0.228 centos7 這臺作為master

hddcluster3 10.0.0.202 redhat7

hddcluster4 10.0.0.181 centos7

軟件環境:

scala-2.11.7

spark-2.0.2-bin-hadoop2.7.tgz

#所有操作用hadoop

基本流程:

1、master解壓scala-2.11.7和spark-2.0.2-bin-hadoop2.7.tgz到相應的目錄

2、配置scala和spark環境變量

3、修改配置文件

4、拷貝scala和spark到各個節點,授權

5、啟動spark集群

#hadoop用戶下操作,下載scala,安裝 wget http://downloads.lightbend.com/scala/2.11.7/scala-2.11.7.tgz tar -zxvf scala-2.11.7.tgz mv scala-2.11.7 /usr/local/scala sudo mv scala-2.11.7 /usr/local/scala vim .bashrc #添加 export SCALA_HOME=/usr/local/scala export PATH=$PATH:$HADOOP_HOME/sbin:$HADOOP_HOME/bin:$SCALA_HOME/bin source .bashrc [hadoop@hddcluster2 ~]$ scala -version Scala code runner version 2.11.7 -- Copyright 2002-2013, LAMP/EPFL

#在官網下載spark-2.0.2-bin-hadoop2.7.tgz tar -zxvf spark-2.0.2-bin-hadoop2.7.tgz mv spark-2.0.2-bin-hadoop2.7 spark sudo mv spark /usr/local/ vim .bashrc #添加 export SPARK_HOME=/usr/local/spark export PATH=$PATH:$HADOOP_HOME/sbin:$HADOOP_HOME/bin:$SCALA_HOME/bin:$SPARK_HOME

#修改spark配置文件 cd /usr/local/spark/conf cp spark-env.sh.template spark-env.sh vi spark-env.sh #添加下面內容 ###jdk dir export JAVA_HOME=/usr/lib/jvm/java-1.8.0-openjdk-1.8.0.111-2.b15.el7_3.x86_64 ###scala dir export SCALA_HOME=/usr/local/scala ###the ip of master node of spark export SPARK_MASTER_IP=10.0.0.228 ###the max memory size of worker export SPARK_WORKER_MEMORY=8G ###hadoop configuration file dir export HADOOP_CONF_DIR=/usr/local/hadoop/etc/hadoop/ #修改slave cp slaves.template slaves vi slaves #把localhost改為下面內容 hddcluster1 hddcluster2 hddcluster3 hddcluster4

#把/usr/local/spark 和 /usr/local/scala打包,然后復制到slave節點、 cd /usr/local tar -zcf ~/master.spark.tar.gz ./spark tar -zcf ~/master.scala.tar.gz ./scala scp master.spark.tar.gz hddcluster1:~ scp master.scala.tar.gz hddcluster1:~ #登錄各個節點進行解壓到/usr/local tar -zxf master.spark.tar.gz -C /usr/local/ tar -zxf master.scala.tar.gz -C /usr/local/ chown -R hadoop:hadoop /usr/local/spark chown -R hadoop:hadoop /usr/local/scala 再配置.bashrc環境變量和master的一樣。 加上hadoop上一篇的.bashrc內容是這樣子: #scala export SCALA_HOME=/usr/local/scala #spark export SPARK_HOME=/usr/local/spark #java and hadoop export JAVA_HOME=/usr/lib/jvm/java-1.8.0-openjdk-1.8.0.111-2.b15.el7_3.x86_64 export HADOOP_HOME=/usr/local/hadoop export HADOOP_INSTALL=$HADOOP_HOME export HADOOP_MAPRED_HOME=$HADOOP_HOME export HADOOP_COMMON_HOME=$HADOOP_HOME export HADOOP_HDFS_HOME=$HADOOP_HOME export YARN_HOME=$HADOOP_HOME export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native export PATH=$PATH:$HADOOP_HOME/sbin:$HADOOP_HOME/bin:$SCALA_HOME/bin:$SPARK_HOME export HADOOP_PREFIX=$HADOOP_HOME export HADOOP_OPTS="-Djava.library.path=$HADOOP_PREFIX/lib:$HADOOP_PREFIX/lib/native" 到此Spark集群搭建完畢

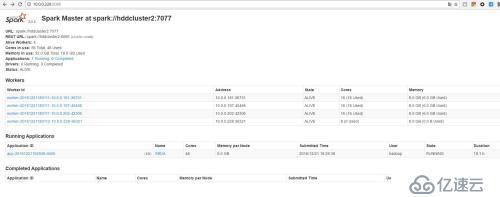

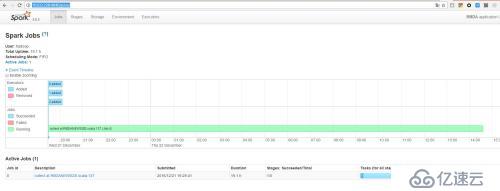

.啟動Spark集群: 啟動Spark之前需要先將hadoop的dfs以及yarn啟動。 /usr/local/spark/sbin/start-all.sh 啟動所有服務之后,在命令行輸入jps: [hadoop@hddcluster2 ~]$ jps 29601 ResourceManager 32098 SparkSubmit 29188 DataNode 29364 SecondaryNameNode 29062 NameNode 29915 NodeManager 30251 Master 30380 Worker 30062 JobHistoryServer 18767 Jps 比hadoop集群啟動時多了Master和worker /usr/local/spark/bin/spark-shell.sh 出現scala>時說明成功。 在瀏覽器中輸入10.0.0.228:8080時,會看到如下圖,有4個Worker

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。