您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

這篇文章給大家介紹基于Spark訓練線性回歸模型的實戰入門是怎樣的,內容非常詳細,感興趣的小伙伴們可以參考借鑒,希望對大家能有所幫助。

最開始接觸分布式計算框架的是Hadoop中的MapReduce,雖然開發起來很復雜(Map與Reduce都要有相應的實現類)但是我也成功的啟動了第一個“Hello word”(word count)。

由于MapReduce每個步驟都要將中間結果存到磁盤中,而且會將job jar 包分發到每個相關的Datanode上,雖然我的Txt文件不到1M, 但是啟動計算加上返回結果的時間大概也有40秒左右,還能忍,畢竟是懷揣著我將要處理TB級別數據的夢想。

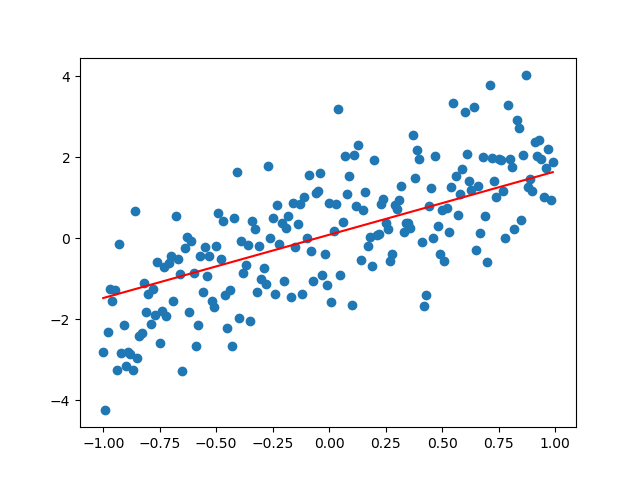

Spark作為分布式計算框架,采用的是一種基于內存的計算,減少了反復讀取磁盤的數次,另外還提供了除了map與reduce更多的操作。這無疑是提供了最好的MapReduce替代品。然而最吸引我的不是spark的mapreduce有多么的快,而是spark集成了Machine Learning packages。

下面提供了一種接近實際生產環境,在Spark集群環境中,訓練機器學習模型的完整方法

此項目教程主要特點:

文檔齊全,代碼簡潔,教程操作性強,帶有一步一步講解

spark體驗線性回歸模型,屬于最好的入門實戰例子教程,初學者入門的不二之選

共分解為10個步驟,通俗易懂,操作性強:

關于基于Spark訓練線性回歸模型的實戰入門是怎樣的就分享到這里了,希望以上內容可以對大家有一定的幫助,可以學到更多知識。如果覺得文章不錯,可以把它分享出去讓更多的人看到。

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。