您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

今天就跟大家聊聊有關如何進行Docker下kafka的本地環境搭建,可能很多人都不太了解,為了讓大家更加了解,小編給大家總結了以下內容,希望大家根據這篇文章可以有所收獲。

我們通過實戰來學習如何編寫這些腳本,搭建本地kafka環境;

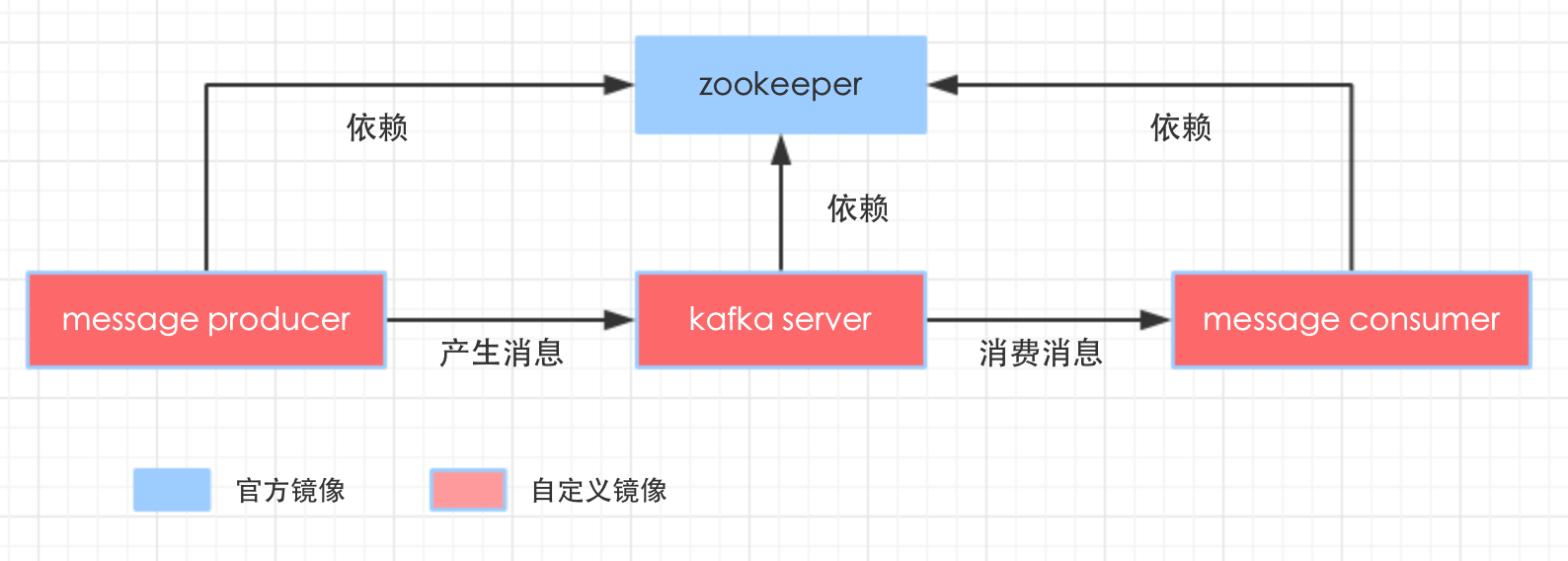

本次實踐會制作docker鏡像,整個環境涉及到多個容器,我們先把它們全部列出來,再梳理一下之間的關系,如下圖:

kafka sever提供消息服務; message producer的作用是產生執行主題的消息; message consumer的作用是訂閱指定主題的消息并消費掉。

###zookeeper### zookeeper使用單機版,沒什么需要定制的,因此直接使用官方鏡像即可,daocloud.io/library/zookeeper:3.3.6

###kafka sever### 去hub.docker.com上搜索kafka,沒看到官方標志的鏡像,還是自己做一個吧,寫Dockerfile之前先準備兩個材料:kafka安裝包和啟動kafka的shell腳本;

kafka安裝包用的是2.9.2-0.8.1版本,在 git@github.com:zq2599/docker_kafka.git中,請clone獲取;

啟動kafka server的shell腳本內容如下,很簡單,在kafka的bin目錄下執行腳本啟動server即可:

#!/bin/bash $WORK_PATH/$KAFKA_PACKAGE_NAME/bin/kafka-server-start.sh $WORK_PATH/$KAFKA_PACKAGE_NAME/config/server.properties

接下來可以編寫Dockerfile了,如下:

# Docker image of kafka # VERSION 0.0.1 # Author: bolingcavalry #基礎鏡像使用tomcat,這樣可以免于設置java環境 FROM daocloud.io/library/tomcat:7.0.77-jre8 #作者 MAINTAINER BolingCavalry <zq2599@gmail.com> #定義工作目錄 ENV WORK_PATH /usr/local/work #定義kafka文件夾名稱 ENV KAFKA_PACKAGE_NAME kafka_2.9.2-0.8.1 #創建工作目錄 RUN mkdir -p $WORK_PATH #把啟動server的shell復制到工作目錄 COPY ./start_server.sh $WORK_PATH/ #把kafka壓縮文件復制到工作目錄 COPY ./$KAFKA_PACKAGE_NAME.tgz $WORK_PATH/ #解壓縮 RUN tar -xvf $WORK_PATH/$KAFKA_PACKAGE_NAME.tgz -C $WORK_PATH/ #刪除壓縮文件 RUN rm $WORK_PATH/$KAFKA_PACKAGE_NAME.tgz #執行sed命令修改文件,將連接zk的ip改為link參數對應的zookeeper容器的別名 RUN sed -i 's/zookeeper.connect=localhost:2181/zookeeper.connect=zkhost:2181/g' $WORK_PATH/$KAFKA_PACKAGE_NAME/config/server.properties #給shell賦予執行權限 RUN chmod a+x $WORK_PATH/start_server.sh

如腳本所示,操作并不復雜,復制解壓kafka安裝包,啟動shell腳本,再把配置文件中zookeeper的ip改成link時zookeeper的別名;

Dockerfile編寫完成后,和kafka_2.9.2-0.8.1.tgz以及start_server.sh放在同一個目錄下,用控制臺在此目錄下執行:

docker build -t bolingcavalry/kafka:0.0.1 .

鏡像構建成功后,新建一個目錄編寫docker-compose.yml腳本,如下:

version: '2' services: zk_server: image: daocloud.io/library/zookeeper:3.3.6 restart: always kafka_server: image: bolingcavalry/kafka:0.0.1 links: - zk_server:zkhost command: /bin/sh -c '/usr/local/work/start_server.sh' restart: always message_producer: image: bolingcavalry/kafka:0.0.1 links: - zk_server:zkhost - kafka_server:kafkahost restart: always message_consumer: image: bolingcavalry/kafka:0.0.1 links: - zk_server:zkhost restart: always

docker-compose.yml中配置了四個容器:

zookeeper是官方的;

其他三個都是用剛剛制作的bolingcavalry/kafka做鏡像生成的;

kafka_server在啟動時執行了start_server.sh腳本把服務啟動起來了;

message_producer和message_consumer都僅僅是將kafka環境安裝好了,以便于通過命令行發送或者訂閱消息,但是這兩個容器本身并未啟動server;

kafka_server,message_producer,message_consumer都通過link參數連接到了zookeeper容器,并且message_producer還連接到了kafka server,因為發送消息的時候會用到kafka server的ip地址;

現在打開終端,在docker-compose.yml所在目錄下執行<font color="blue">docker-compose up -d</font>,即可啟動所有容器。

看完上述內容,你們對如何進行Docker下kafka的本地環境搭建有進一步的了解嗎?如果還想了解更多知識或者相關內容,請關注億速云行業資訊頻道,感謝大家的支持。

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。