您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

這期內容當中小編將會給大家帶來有關Ambari HDP集群搭建的示例分析,文章內容豐富且以專業的角度為大家分析和敘述,閱讀完這篇文章希望大家可以有所收獲。

最近因為工作上需要重新用Ambari搭了一套Hadoop集群,就把搭建的過程記錄了下來。

Ambari Ubuntu14.04 最新版本 2.2.1

HDP Ubuntu14.04 最新版本 2.4.3.0

Apache Ambari是一種基于Web的工具,支持Apache Hadoop集群的供應、管理和監控。

Ambari已支持大多數Hadoop組件,包括HDFS、MapReduce、Hive、Pig、 Hbase、Zookeeper、Sqoop和Hcatalog等。

Apache Ambari 支持HDFS、MapReduce、Hive、Pig、Hbase、Zookeepr、Sqoop和Hcatalog等的集中管理。也是5個頂級hadoop管理工具之一。(就是一個開源的hadoop一鍵式安裝服務)

我們能用他干什么?我們為什么要用它呢?

我們可以使用ambari快速的搭建和管理hadoop和經常使用的服務組件。

比如hdfs、yarn、hive、hbase、oozie、sqoop、flume、zookeeper、kafka等等。(說白了就是可以偷好多懶)

再說說我們為什么要用它

第一是ambari還算是一個早期的Hadoop管理集群工具

第二主要是現在Hadoop官網也在推薦使用Ambari。

通過一步一步的安裝向導簡化了集群供應。

預先配置好關鍵的運維指標(metrics),可以直接查看Hadoop Core(HDFS和MapReduce)及相關項目(如HBase、Hive和HCatalog)是否健康。

支持作業與任務執行的可視化與分析,能夠更好地查看依賴和性能。

通過一個完整的RESTful API把監控信息暴露出來,集成了現有的運維工具。

用戶界面非常直觀,用戶可以輕松有效地查看信息并控制集群。

Ambari使用Ganglia收集度量指標,用Nagios支持系統報警,當需要引起管理員的關注時(比如,節點停機或磁盤剩余空間不足等問題),系統將向其發送郵件。

此外,Ambari能夠安裝安全的(基于Kerberos)Hadoop集群,以此實現了對Hadoop 安全的支持,提供了基于角色的用戶認證、授權和審計功能,并為用戶管理集成了LDAP和Active Directory。

1、讓我們先做一些安裝前的準備工作

## 先告訴服務器們他們都是誰,小名都叫啥(修改配置hosts文件) vim /etc/hosts 10.1.10.1 master 10.1.10.2 slave1 10.1.10.3 slave2 ## 然后讓我們拿著門禁卡自由的出入他們家 嗶咔進站(配置免密登錄) ssh-keygen -t rsa ##在所有的機器上執行 cat ~/.ssh/id_rsa.pub ## 查看公鑰 cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys ## 將公鑰寫入authorized_keys文件中 ### 首先把所有的公鑰都寫入master服務器 ### 其次把master的公鑰別寫入slave1,slave2 ### 最后使用scp命令把口令告訴別人 (我不會告訴你我的口令是“老狼老狼幾點了”) scp ~/.ssh/authorized_keys slave1:~/.ssh/authorized_keys scp ~/.ssh/authorized_keys slave2:~/.ssh/authorized_keys ##更新時區和系統本地化的配置 apt-get install localepurge ## 一頓enter不要管 (卸載那些不被使用的local翻譯文檔) dpkg-reconfigure localepurge && locale-gen zh_CN.UTF-8 en_US.UTF-8 ## 一頓enter不要管 apt-get update && apt-get install -y tzdata echo "Asia/Shanghai" > /etc/timezone ## 修改時區為上海 rm /etc/localtime dpkg-reconfigure -f noninteractive tzdata vi /etc/ntp.conf server 10.1.10.1

2、然后在做一些Ubuntu系統的優化

###1.1 關閉交換分區 swapoff -a vim /etc/fstab ## 刪除注釋swap那一行 類似下面 # swap was on /dev/sda2 during installation #UUID=8aba5009-d557-4a4a-8fd6-8e6e8c687714 none swap sw 0 0 ### 1.2 修改文件描述符打開數 在最后添加 ulimit vi /etc/profile ulimit -SHn 512000 vim /etc/security/limits.conf ## 調整大小都增大10倍 * soft nofile 600000 * hard nofile 655350 * soft nproc 600000 * hard nproc 655350 ### 1.2 使用命令是修改生效 source /etc/profile ###1.3 修改內核配置 vi /etc/sysctl.conf ### 貼上去就行 fs.file-max = 65535000 net.core.somaxconn = 30000 vm.swappiness = 0 net.core.rmem_max = 16777216 net.core.wmem_max = 16777216 net.ipv4.tcp_rmem = 4096 87380 16777216 net.ipv4.tcp_wmem = 4096 16384 16777216 net.core.netdev_max_backlog = 16384 net.ipv4.tcp_max_syn_backlog = 8192 net.ipv4.tcp_syncookies = 1 net.ipv4.tcp_tw_reuse = 1 net.ipv4.tcp_tw_recycle = 1 net.ipv4.ip_local_port_range = 1024 65000 net.ipv6.conf.all.disable_ipv6=1 net.ipv6.conf.default.disable_ipv6=1 net.ipv6.conf.lo.disable_ipv6=1 ### 執行命令讓配置生效 sysctl -p ###1.4 配置內核關閉THP功能 echo never > /sys/kernel/mm/transparent_hugepage/enabled ##永久關閉。 vi /etc/rc.local if test -f /sys/kernel/mm/transparent_hugepage/enabled; then echo never > /sys/kernel/mm/transparent_hugepage/enabled fi if test -f /sys/kernel/mm/transparent_hugepage/defrag; then echo never > /sys/kernel/mm/transparent_hugepage/defrag fi

3、安裝部署ambari-server (環境:Ubuntu 14.04 + Ambari 2.2.1)

## 更新下載源 wget -O /etc/apt/sources.list.d/ambari.list http://public-repo-1.hortonworks.com/ambari/ubuntu14/2.x/updates/2.2.1.0/ambari.list apt-key adv --recv-keys --keyserver keyserver.ubuntu.com B9733A7A07513CAD apt-get update ## 在master節點安裝ambari-server apt-get install ambari-server -y ## 在所有節點安裝 ambari-agent apt-get install ambari-agent -y

4、修改ambari-agent配置指向ambari-server

vi /etc/ambari-agent/conf/ambari-agent.ini ## 修改hostname [server] hostname=master url_port=8440 secured_url_port=8441 ## 初始化ambari-server配置ambari 服務 Database, JDK(默認1.7), LDAP 一般選默認 ambari-server setup ## 狂點enter ## 啟動ambari ambari-server start ambari-agent start

5、經過頭痛的Shell命令,開始連點人間的東西了。

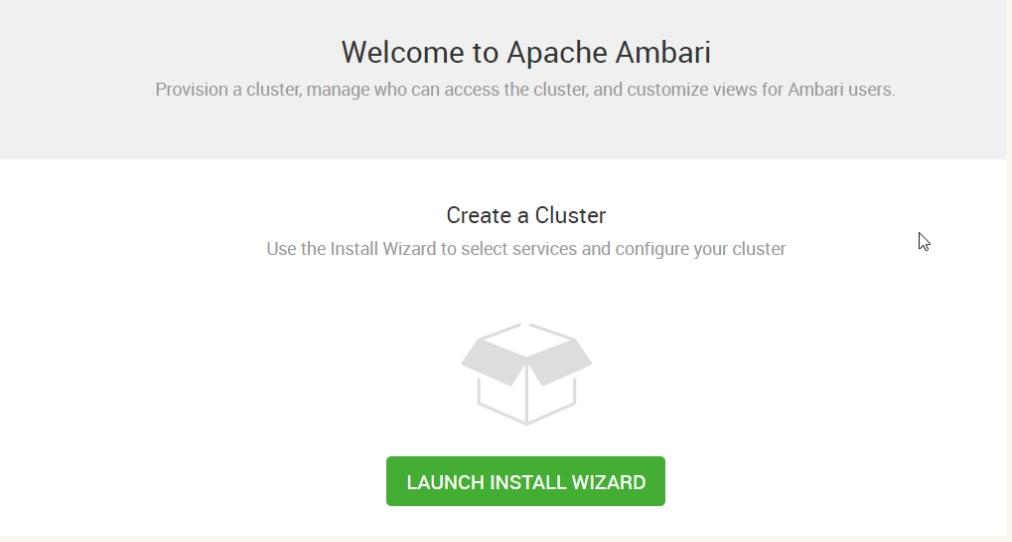

使用你的瀏覽器訪問 http://10.1.10.1:8080/ 賬號密碼默認為amdin/admin 點擊LAUNCH INSTALL WIZARD讓我們愉快的開始吧

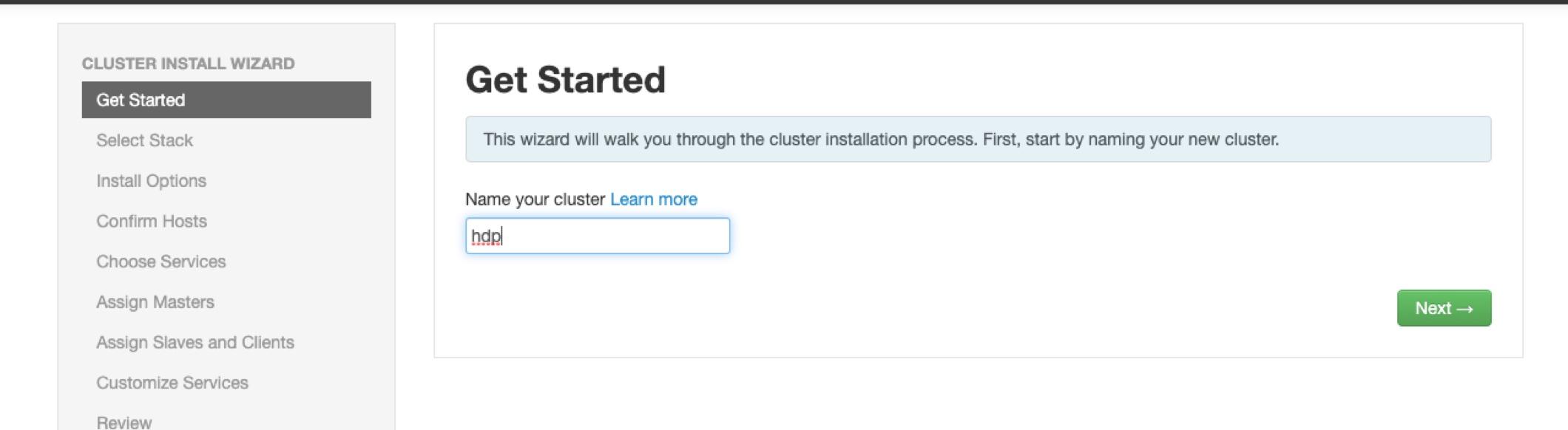

6、給集群起一個名字

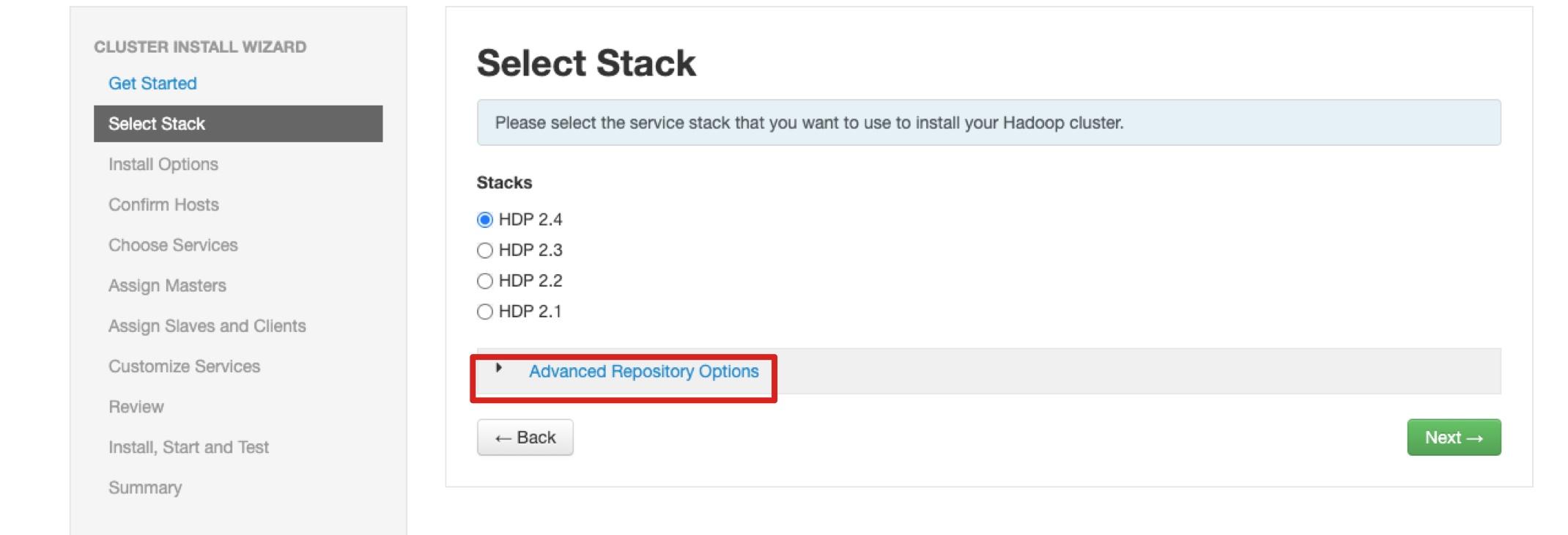

7、這個里要注意一點確定你的hdp版本不然后面會有麻煩

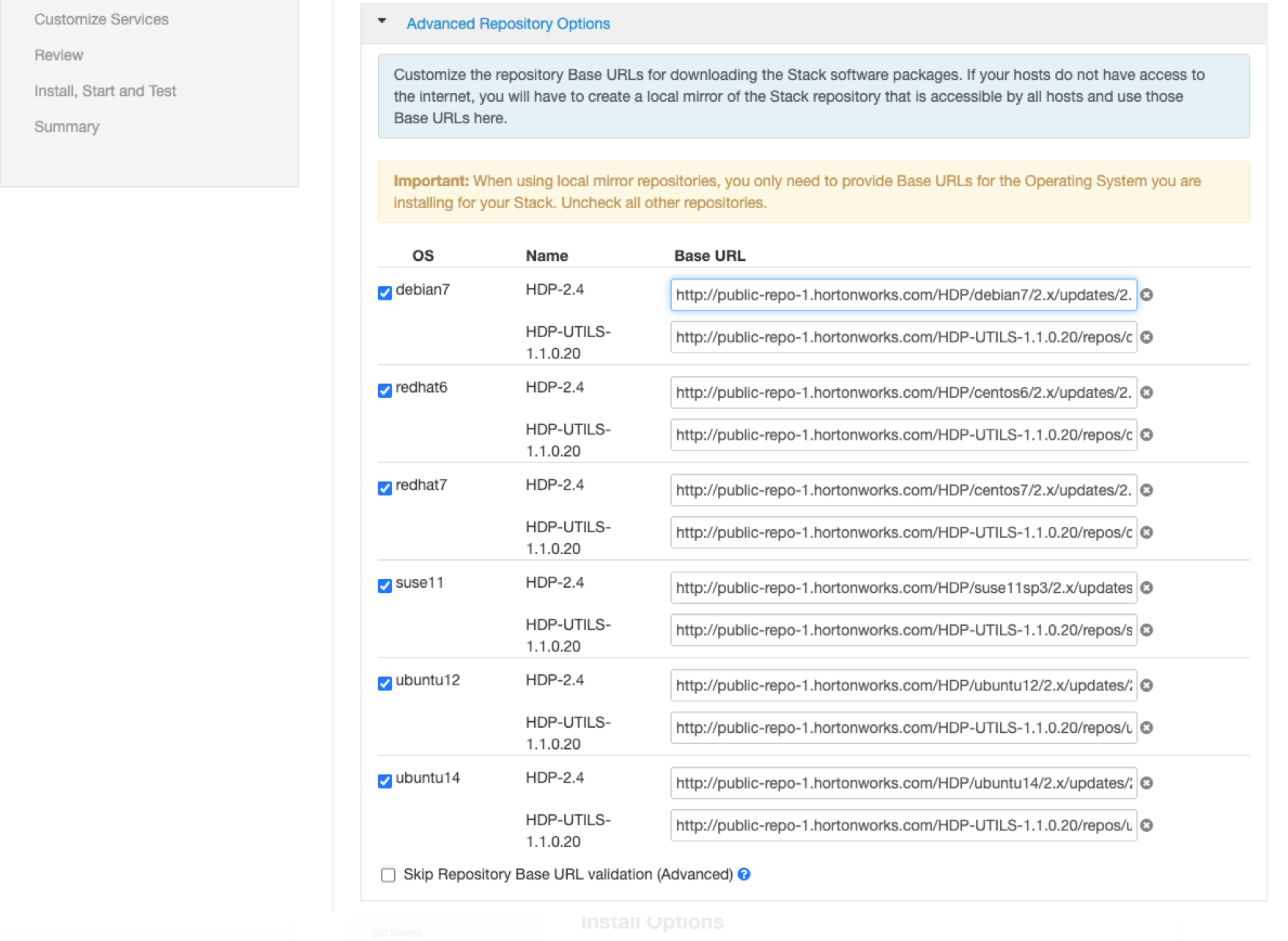

**8、我在這里面配置的是HDP2.4.3 **

例子: http://public-repo-1.hortonworks.com/HDP/debian7/2.x/updates/2.4.3.0

點擊next 會檢查數據源是否正常,如果這里報錯可以點擊 "Skip Repository Base URL validation (Advanced) " 進行跳過檢查

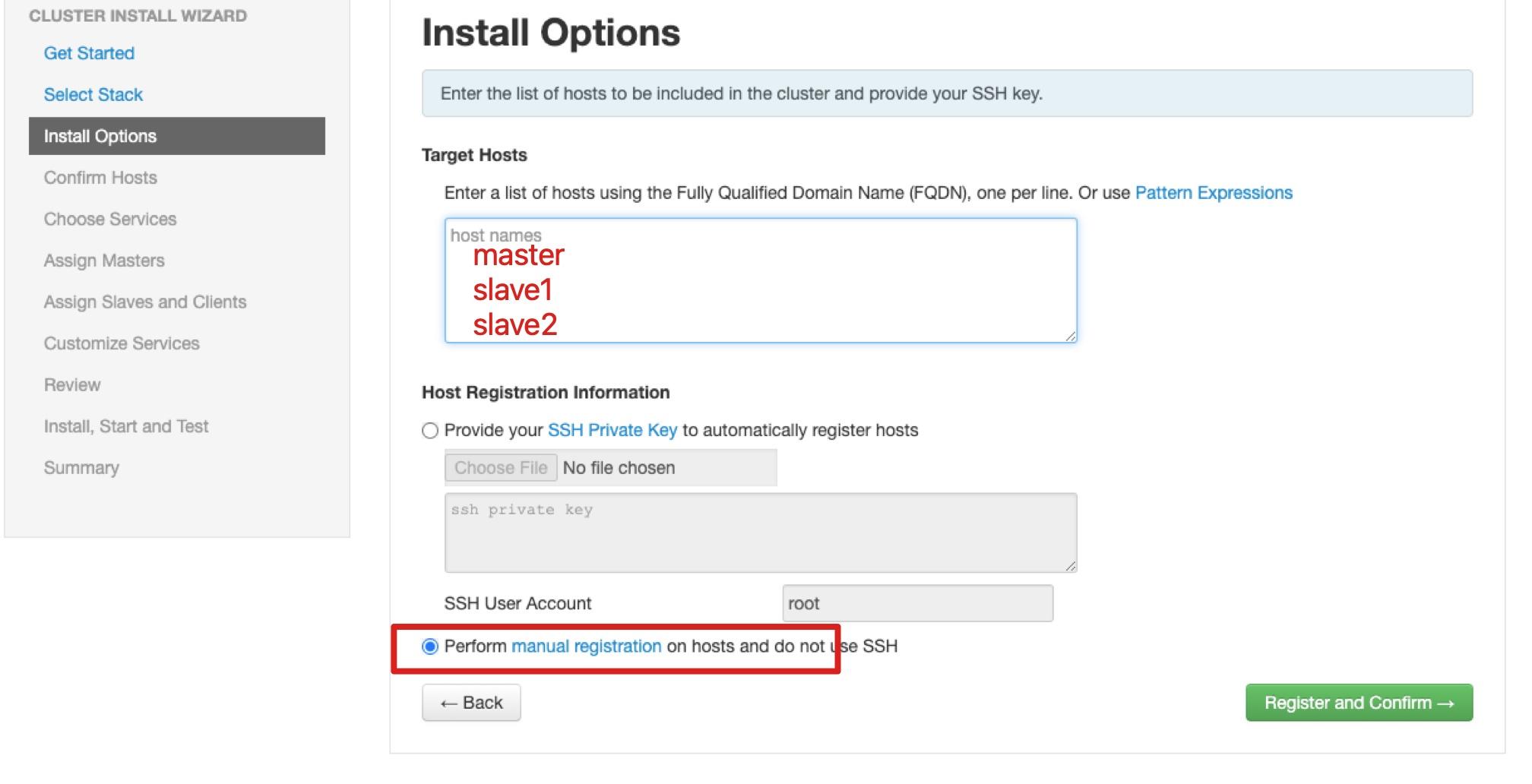

9、填入hostname master slave1 slave2 因為在slave安裝ambari-agent 所以直接選擇不使用ssh

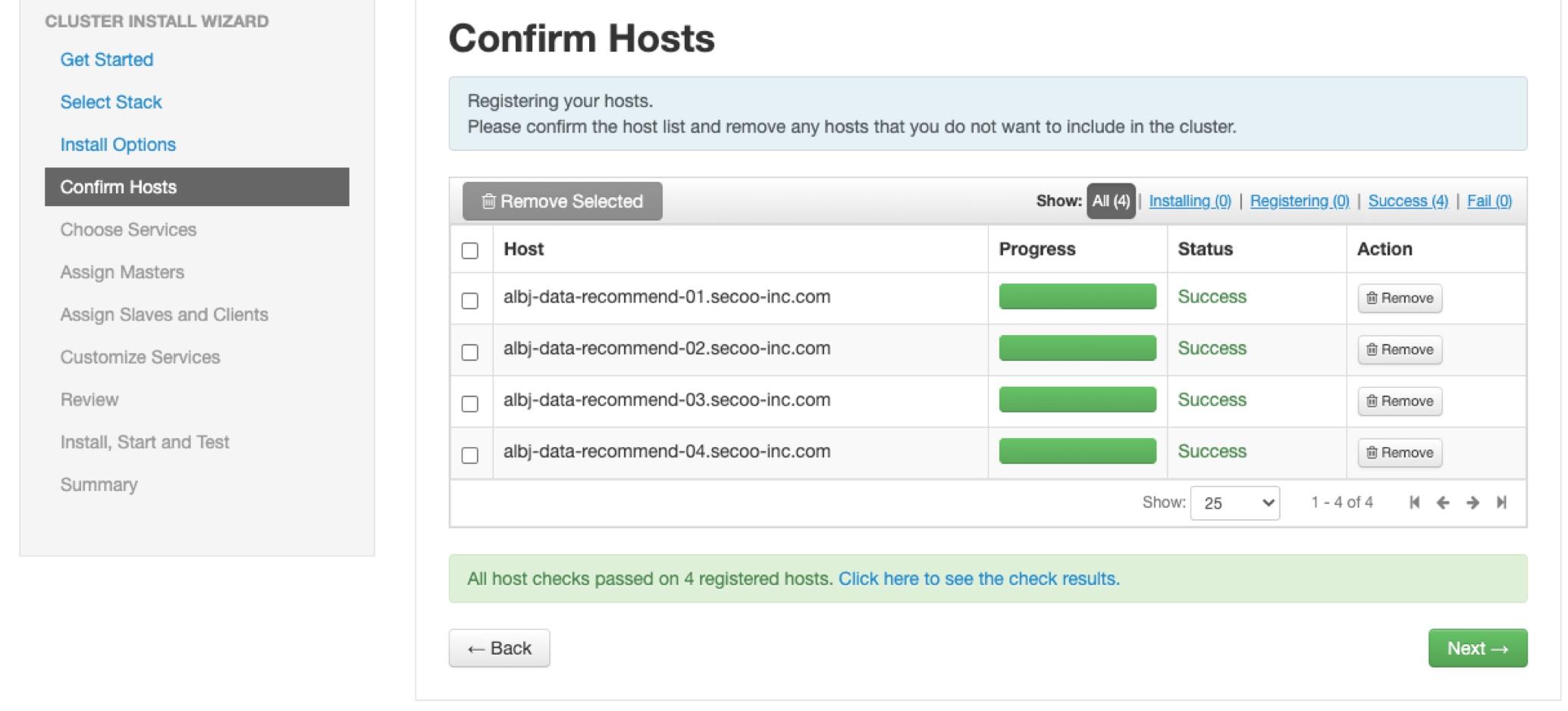

10、檢查服務器狀態--這里需要等待一下 如果等待時間過長可以重啟ambari-server

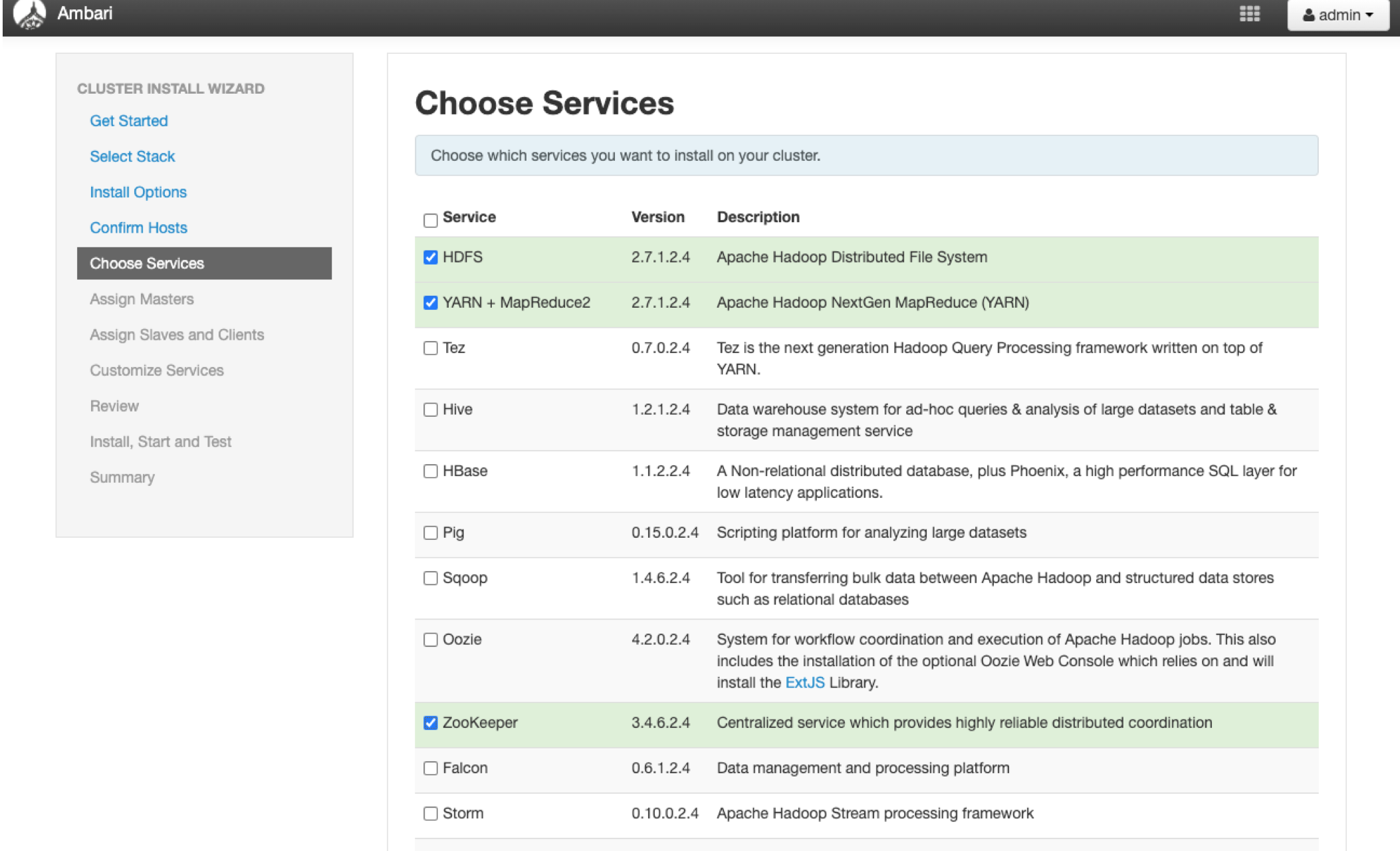

11、選擇我們需要的服務 HDFS YARN ZK

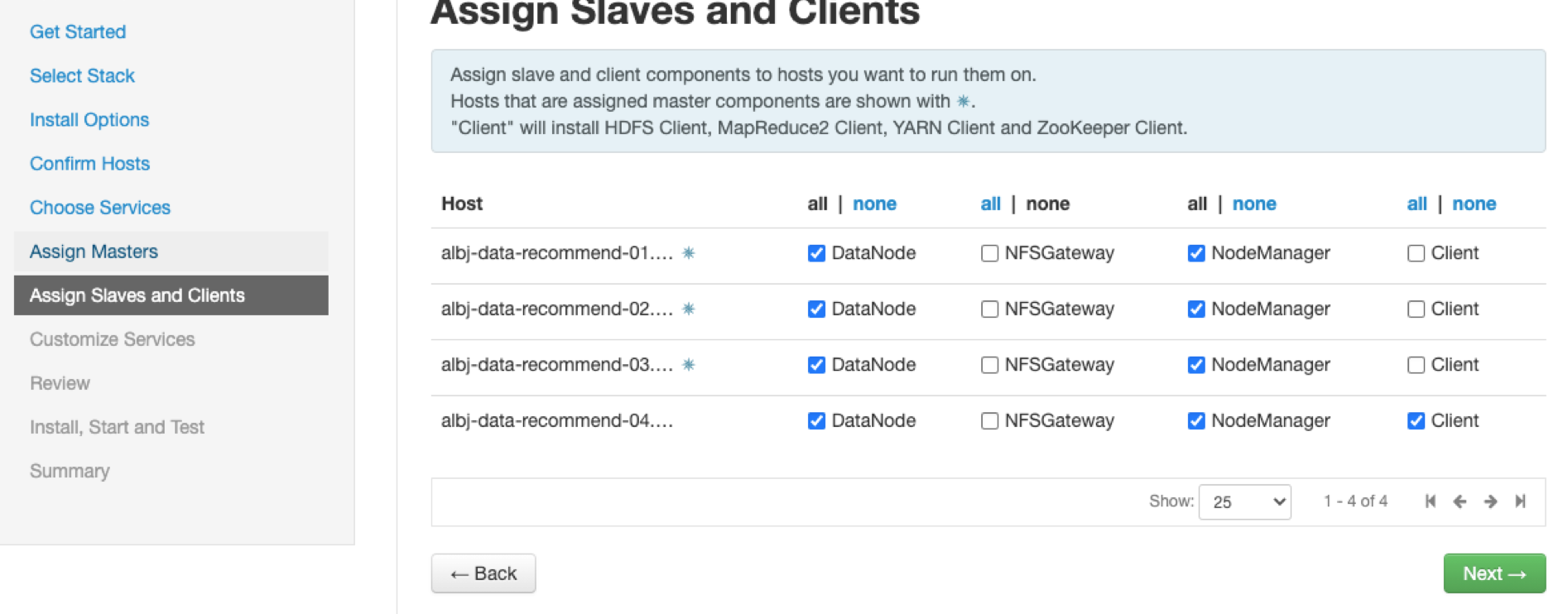

12、直接使用Ambari默認分配方式 點擊下一步開始安裝

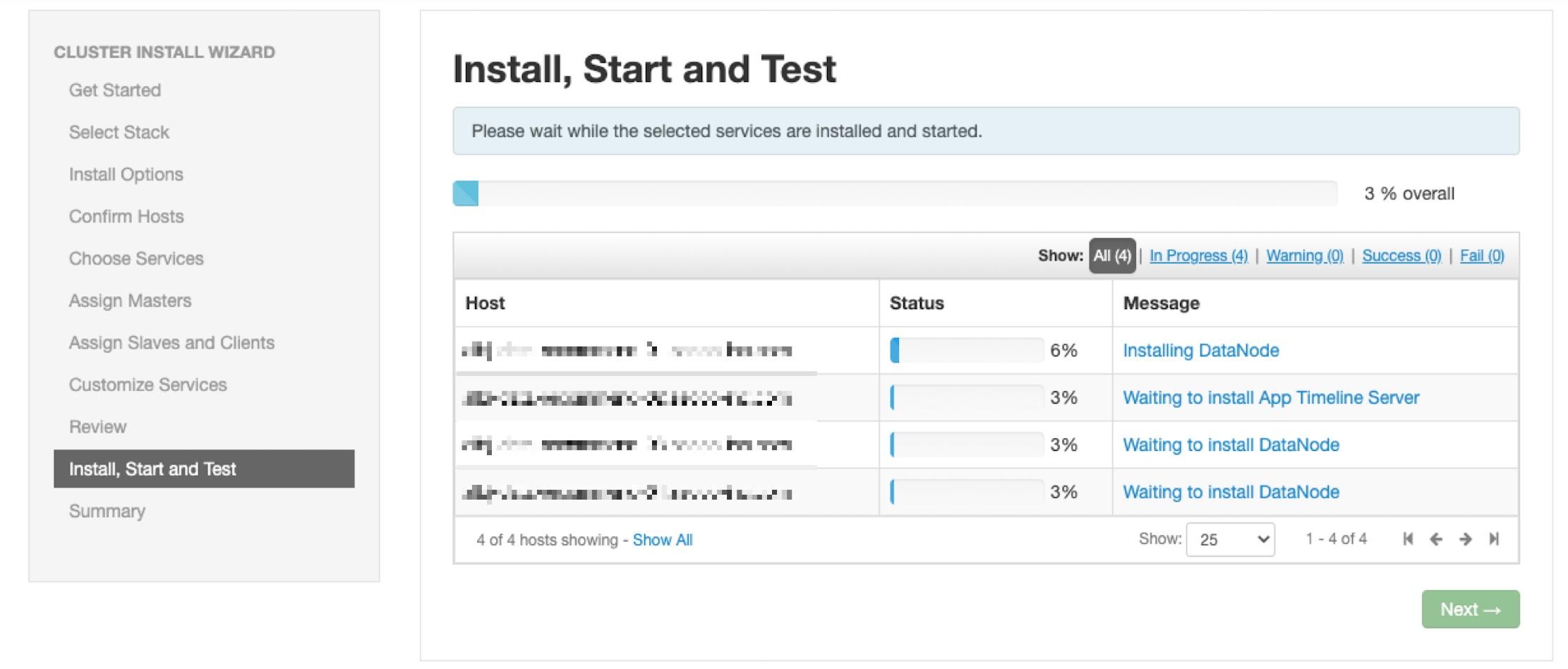

13、下面就是考慮網速的時候了

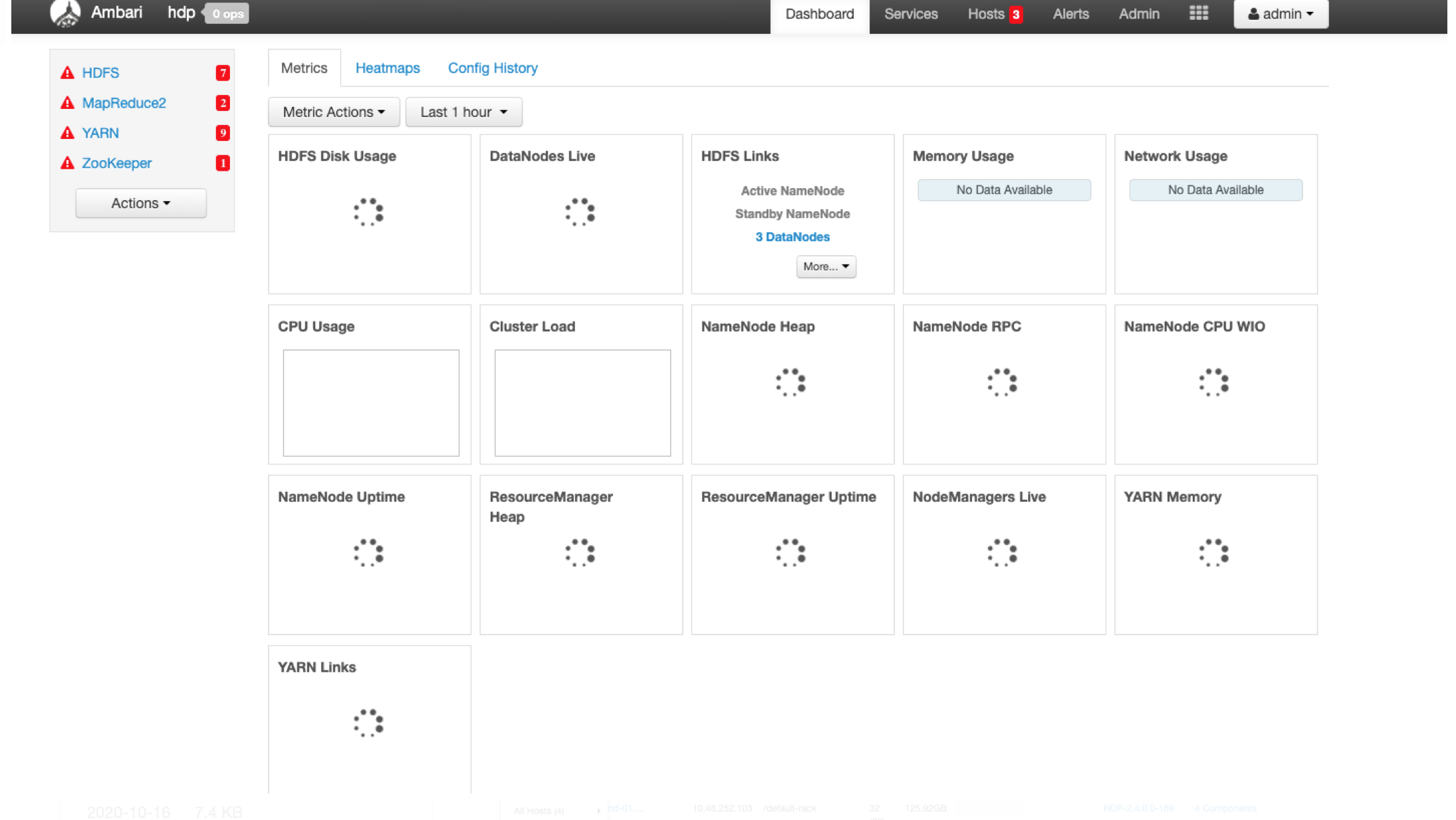

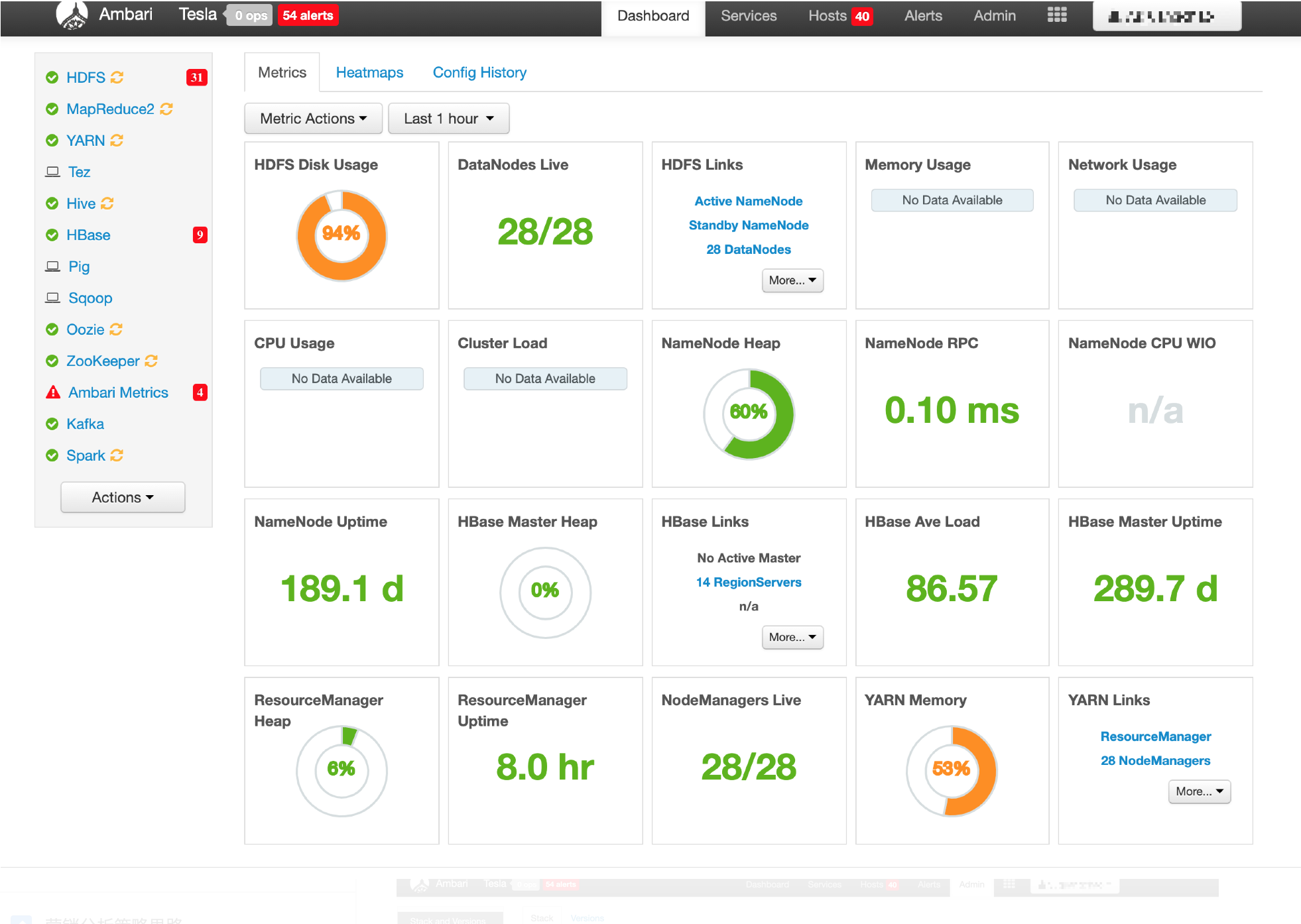

14、安裝完成之后一路Next刷新主頁面就看到了我們的Hadoop集群這里默認都是啟動的

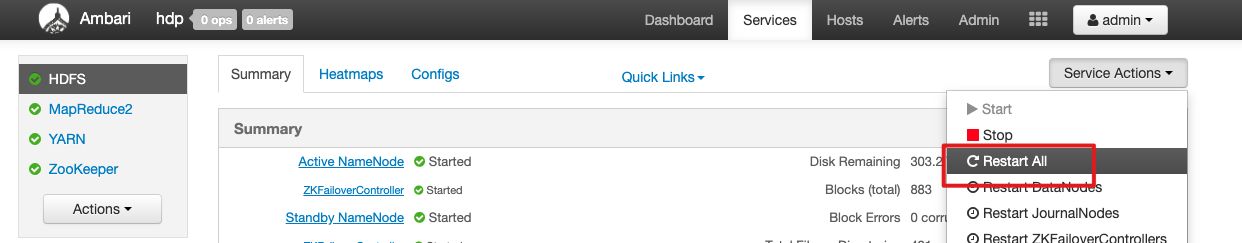

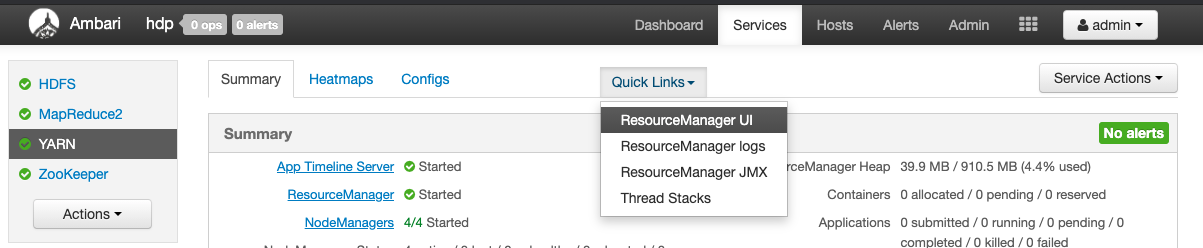

15、進入HDFS下 點擊restart ALL 可以重啟所有組件

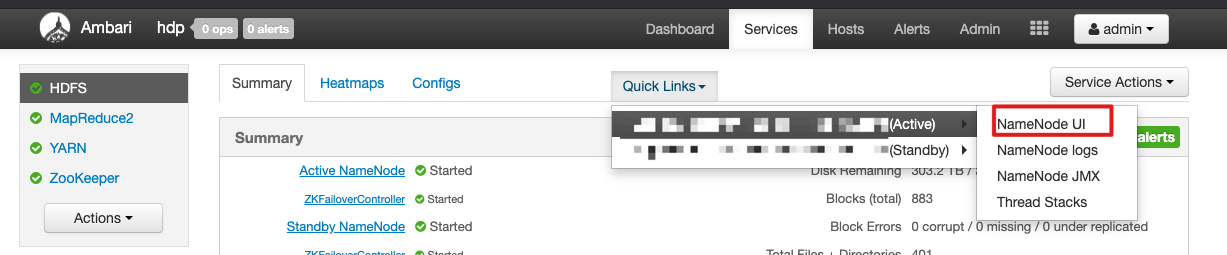

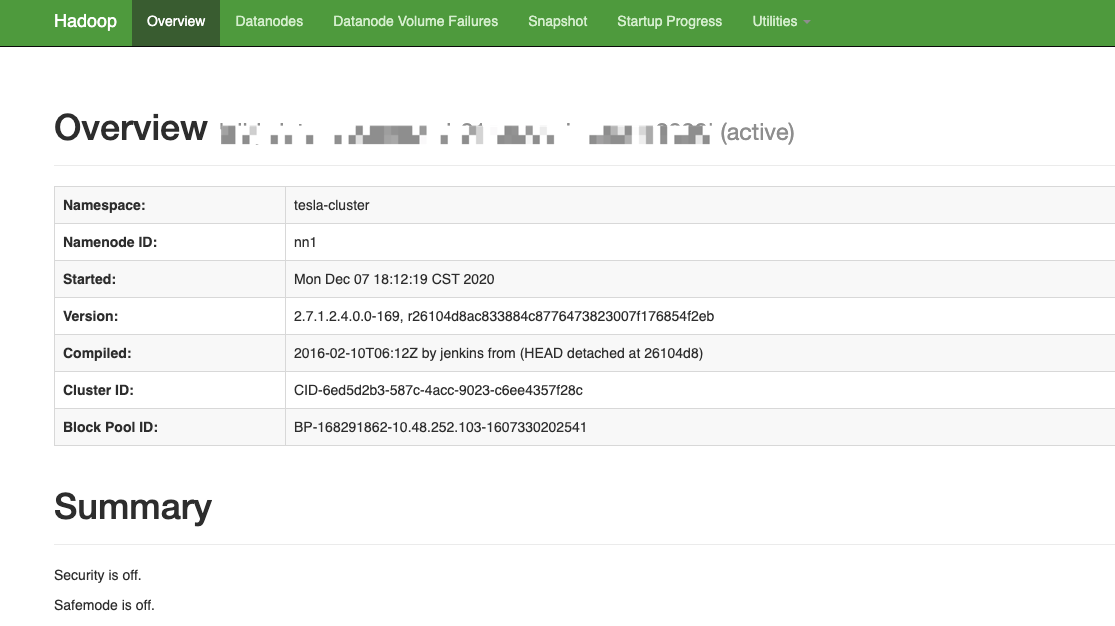

16、驗證一下是否安裝成功 點擊NameNodeUI

17、基礎信息頁

18、Hadoop已經搭建完成完成了不想跑一個任務試試嗎?

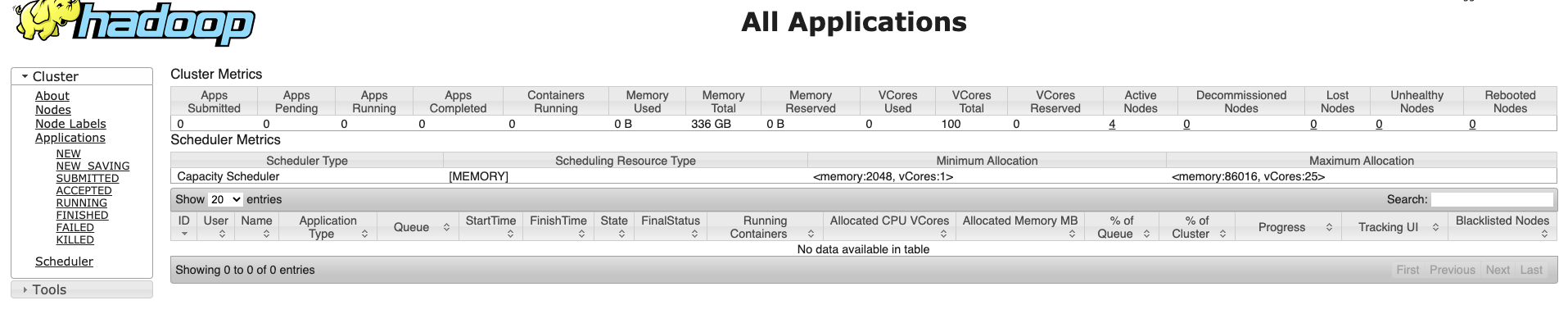

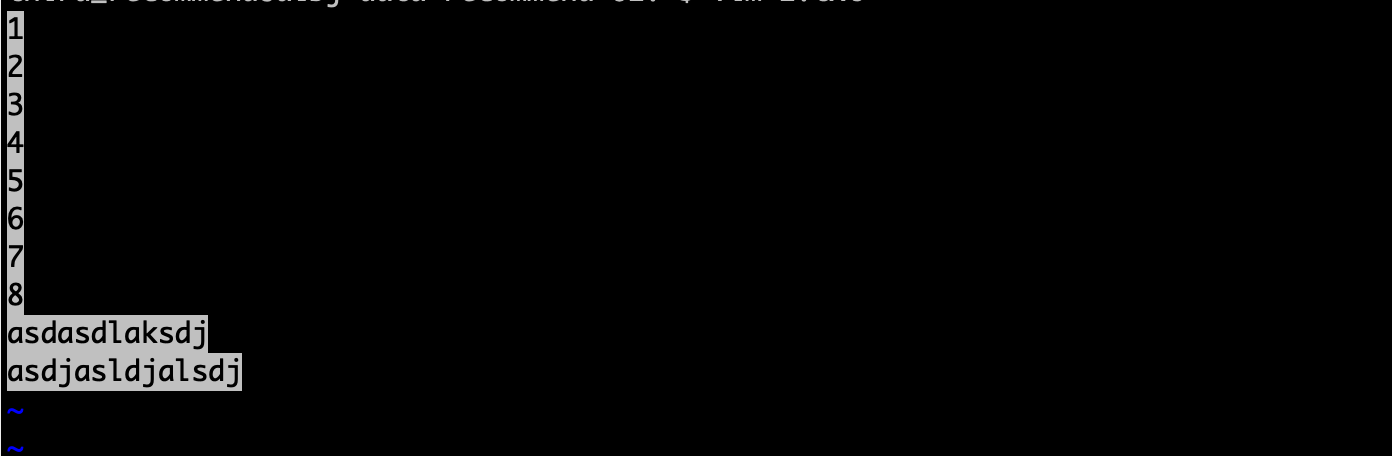

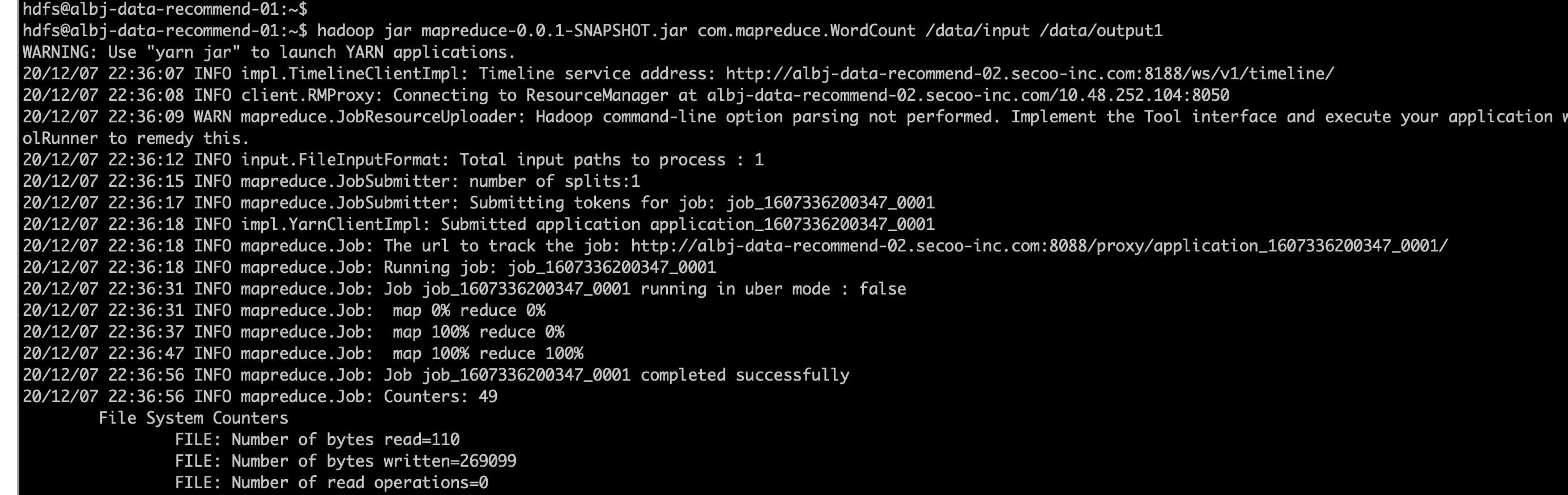

## 進入服務器執行 ### 創建hdfs目錄 可以再http://master:50070/explorer.html#/界面 hdfs dfs -mkdir -p /data/input ### 從服務器上傳文件到hdfs上 hdfs dfs -put 文件 /data/input/ ### 使用官網提供的例子進行測試 hadoop jar hdfs://tesla-cluster/data/hadoop-mapreduce-examples-2.7.1.2.4.0.0-169.jar wordcount /data/input /data/output1

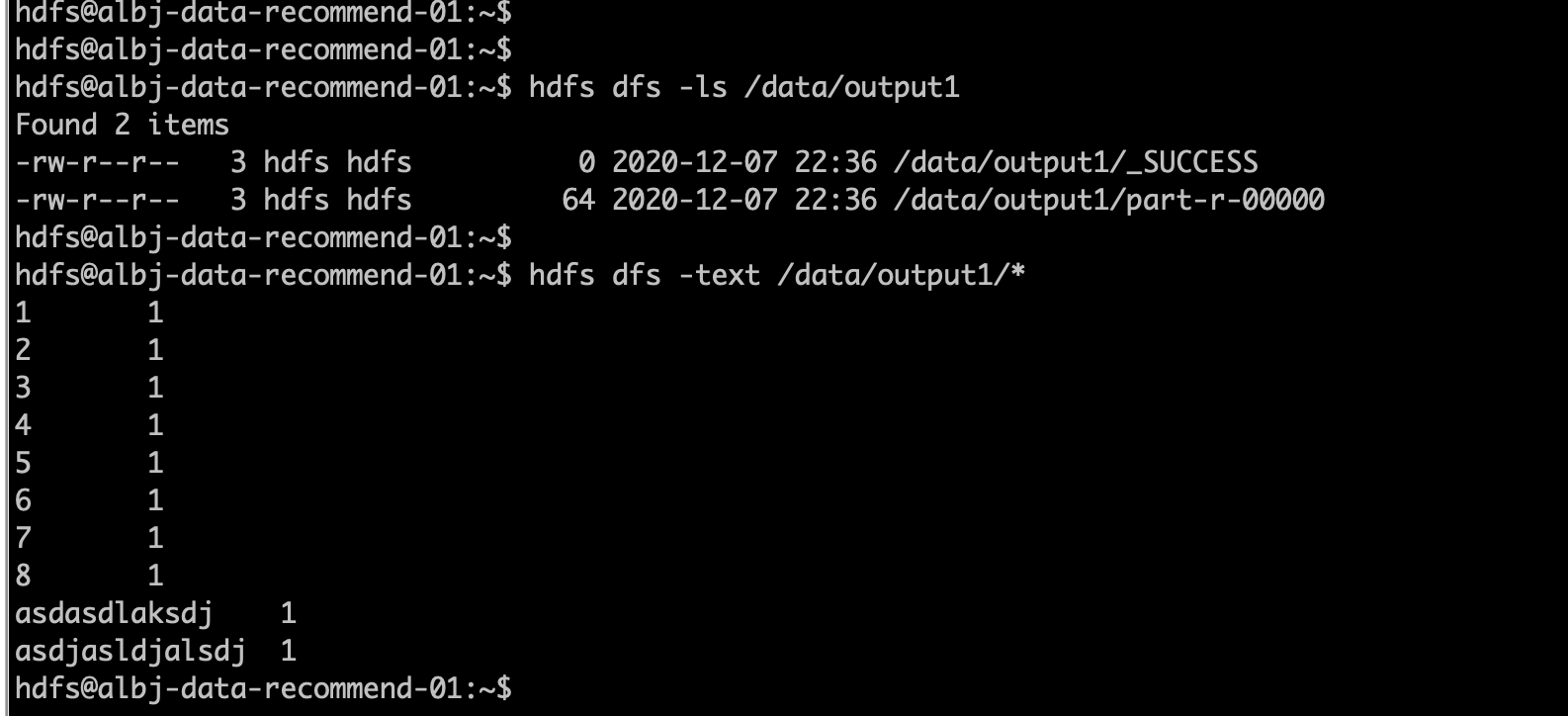

19、結果如下 生成_SUCCESS 和文件

上述就是小編為大家分享的Ambari HDP集群搭建的示例分析了,如果剛好有類似的疑惑,不妨參照上述分析進行理解。如果想知道更多相關知識,歡迎關注億速云行業資訊頻道。

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。