您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

這篇文章主要介紹windows下如何實現kafka+ELK的日志系統,文中介紹的非常詳細,具有一定的參考價值,感興趣的小伙伴們一定要看完!

用到的軟件:zookeeper、kafka、logstash(6.3.2版本)、ES(6.3.2版本)、Kibana(6.3.2版本)。具體安裝步驟不在此說明,基本都是下載解壓,改一下配置文件,即可使用。(以下所述均在Windows下)

1、zookeeper:

kafka中自帶zookeeper,可以不用裝zookeeper,如果想自己另裝,需配置環境變量,如下:

ZOOKEEPER_HOME => D:\nomalAPP\zookeeper-3.4.13

path 里面加入 %ZOOKEEPER_HOME%\bin

如果配置好以后,在cmd里運行zkserver報找不到java錯誤的話,可能是java環境變量的位置放置有問題,可以將path里面配置的java環境位置移到最前面。</b>

2、kafka:

kafka如果啟動報找不到java的錯誤,原因在于kafka-run-class.bat的179行,找到里面的 %CLASSPATH% ,將其用雙引號括起來。即改為:set COMMAND=%JAVA% %KAFKA_HEAP_OPTS% %KAFKA_JVM_PERFORMANCE_OPTS% %KAFKA_JMX_OPTS% %KAFKA_LOG4J_OPTS% -cp "%CLASSPATH%" %KAFKA_OPTS% %* </b>

kafka的配置文件server.properties里面要修改的:

日志所放置的目錄(可以選擇用默認的):log.dirs=D:/nomalAPP/kafka_2.12-2.0.0/kafka-logs,

連接zookeeper的ip和端口:zookeeper.connect=localhost:2181

其他的均可用默認配置。</b>

啟動命令:cmd鎖定安裝目錄,然后 .\bin\windows\kafka-server-start.bat .\config\server.properties

</b>

3、logstash:

在config目錄下,logstash.yml里面,如果想啟動多個,在里面可以配置 http.port=9600-9700,如果沒有配置這一項,會使用默認的9600端口。

在config目錄下,增加一個logstash.conf的配置文件,用來配置數據源,和數據過濾,數據輸出的位置,如下:

input {

# ==> 用kafka的日志作為數據源

kafka{

····#(kafka的IP和端口)

bootstrap_servers => "10.8.22.15:9092"

# (在有多個相同類型的數據源時,需要配置)

client_id => "test1"

# (消費者分組,可以通過組 ID 去指定,不同的組之間消費是相互不受影響的,相互隔離)

group_id => "test1"

auto_offset_reset => "latest"

# (消費者線程個數)

consumer_threads => 5

# (在輸出消息的時候會輸出自身的信息包括:消費消息的大小, topic 來源以及 consumer 的 group 信息)

decorate_events => true

# (主題)

topics => ["bas-binding-topic"]

# (用于ES索引)

type => "bas-binding-topic"

# (數據格式)

codec => "json"

tags => ["bas-binding-topic"]

}

kafka{

bootstrap_servers => "10.8.22.15:9092"

client_id => "test2"

group_id => "test2"

auto_offset_reset => "latest"

consumer_threads => 5

#decorate_events => true

topics => ["bas-cus-request-topic"]

type => "bas-cus-request-topic"

codec => "json"

tags => ["bas-cus-request-topic"]

}

}

filter {

filter插件負責過濾解析input讀取的數據,可以用grok插件正則解析數據,

date插件解析日期,json插件解析json等等

}

output {

# 輸出到ES

if "bas-binding-topic" in [tags] {

elasticsearch{

# ES的IP和端口

hosts => ["localhost:9201"]

# 索引名稱:主題+時間

index => "bas-binding-topic-%{+YYYY.MM.dd+HH:mm:ss}"

timeout => 300

}

stdout {

codec => rubydebug

}

}

if "bas-cus-request-topic" in [tags] {

elasticsearch{

hosts => ["localhost:9201"]

index => "bas-cus-request-topic-%{+YYYY.MM.dd+HH:mm:ss}"

timeout => 300

}

stdout {

codec => rubydebug

}

}

}啟動logstash的命令: .\bin\logstash.bat -f .\config\logstash.conf </b>

4、ES:

在config目錄下,elasticsearch.yml配置文件中,ES的默認端口為9200,可以通過http.port=9201來修改

啟動命令: .\bin\elasticsearch.bat

啟動后,在瀏覽器訪問: http://localhost:9201,

如果出現了一些信息,表示啟動成功。</b>

5、Kibana:

在config目錄下,kibana.yml配置文件中,通過elasticsearch.url: "http://localhost:9201" 來配置地址

啟動命令: .\bin\kibana.bat

訪問 "http://localhost:9201" ,如果出現需要輸入用戶名密碼的界面,表示ES啟動失敗,如果直接顯示Kibana界面,則啟動成功。</b>

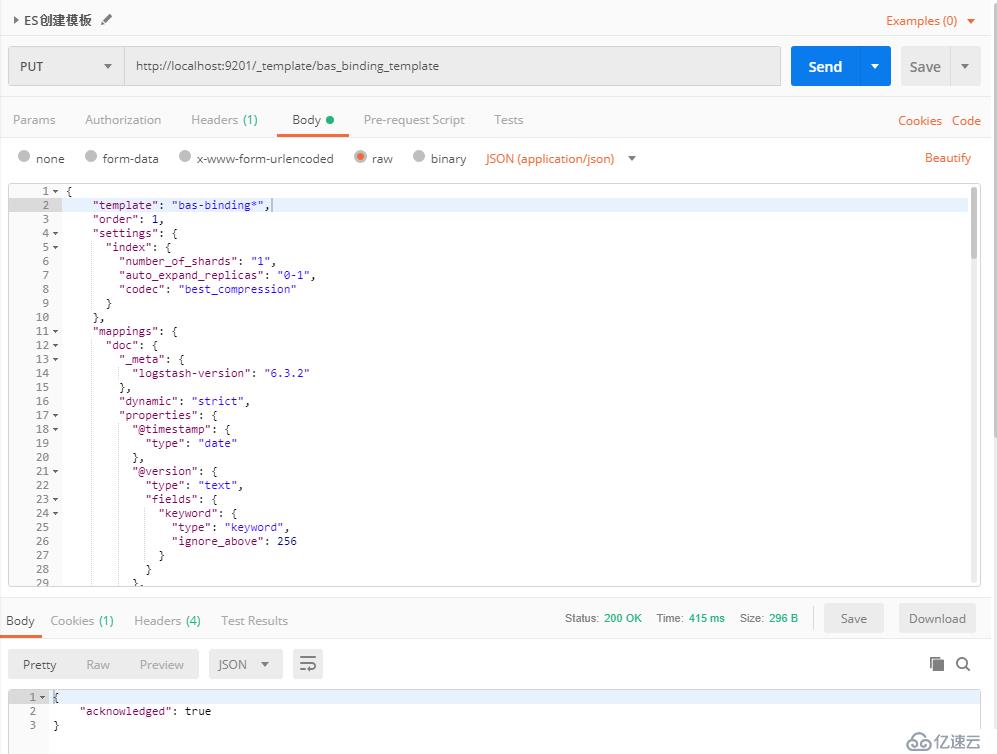

logstash數據輸出到ES時,會選擇ES默認的映射來解析數據。如果覺得默認映射不滿足使用條件,可以自定模板:

借助postman工具創建ES模板,如下:

收到此響應表示創建成功。然后可以通過GET請求查詢你剛才創建的模板,通過DELETE請求刪除剛才創建的模板。</b>

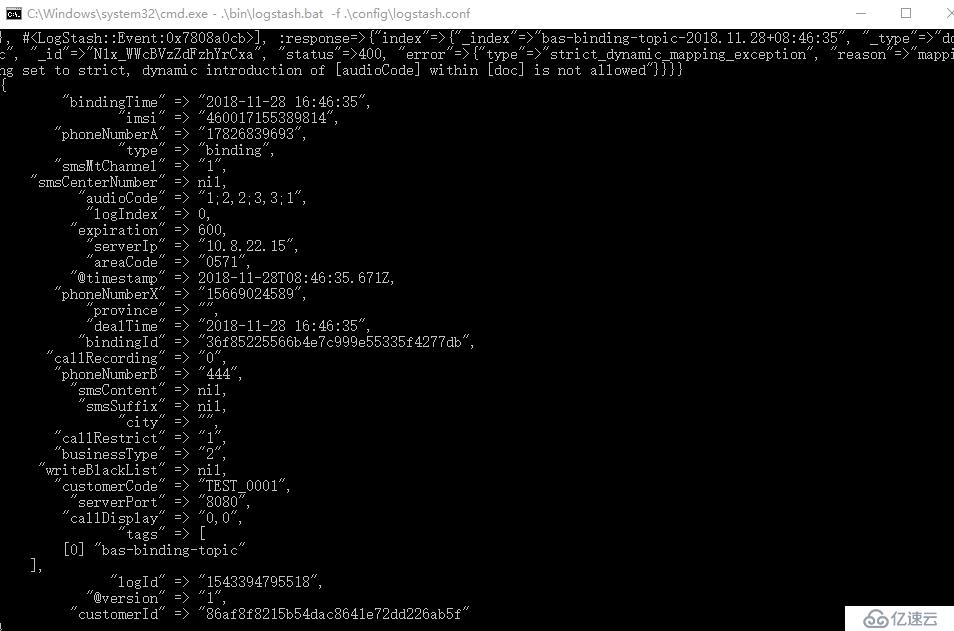

向kafka主題中發送日志信息,發送的信息會在cmd窗口顯示,如下:

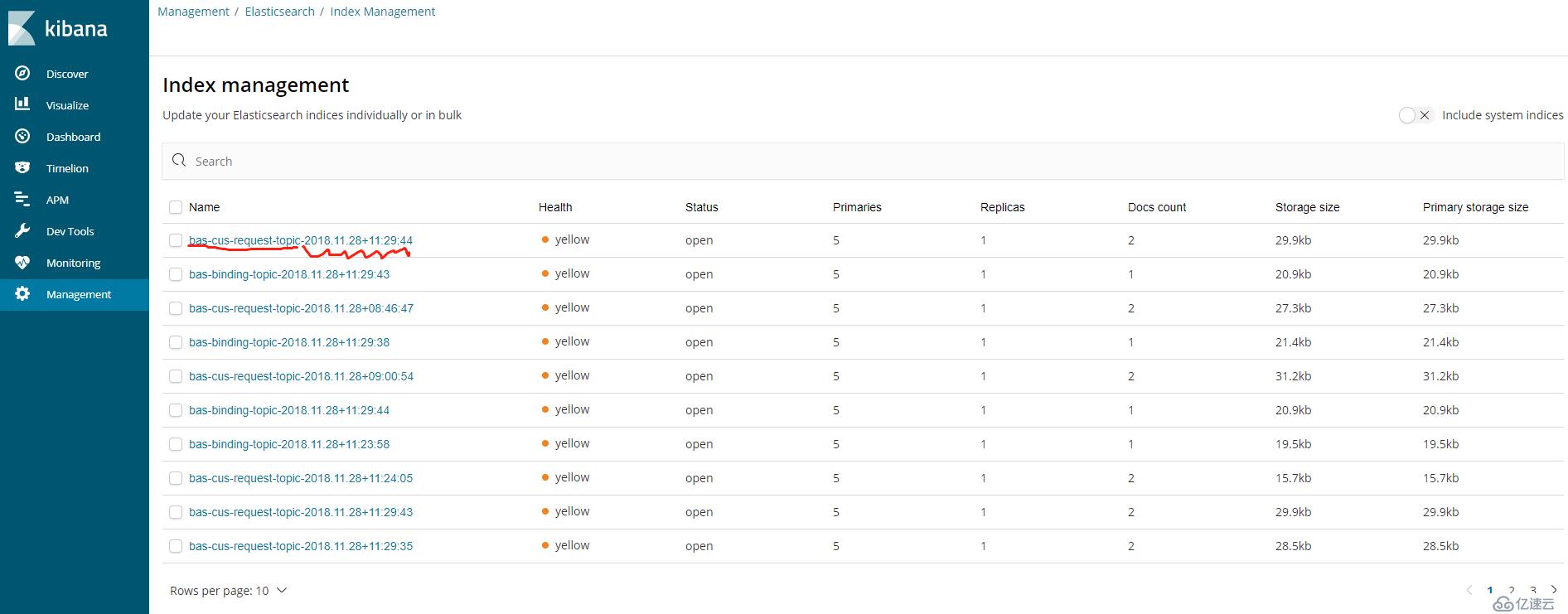

同時,在Kibana界面會看到相應的索引,索引名稱就是在logstash.conf的輸出中配置的,如下:

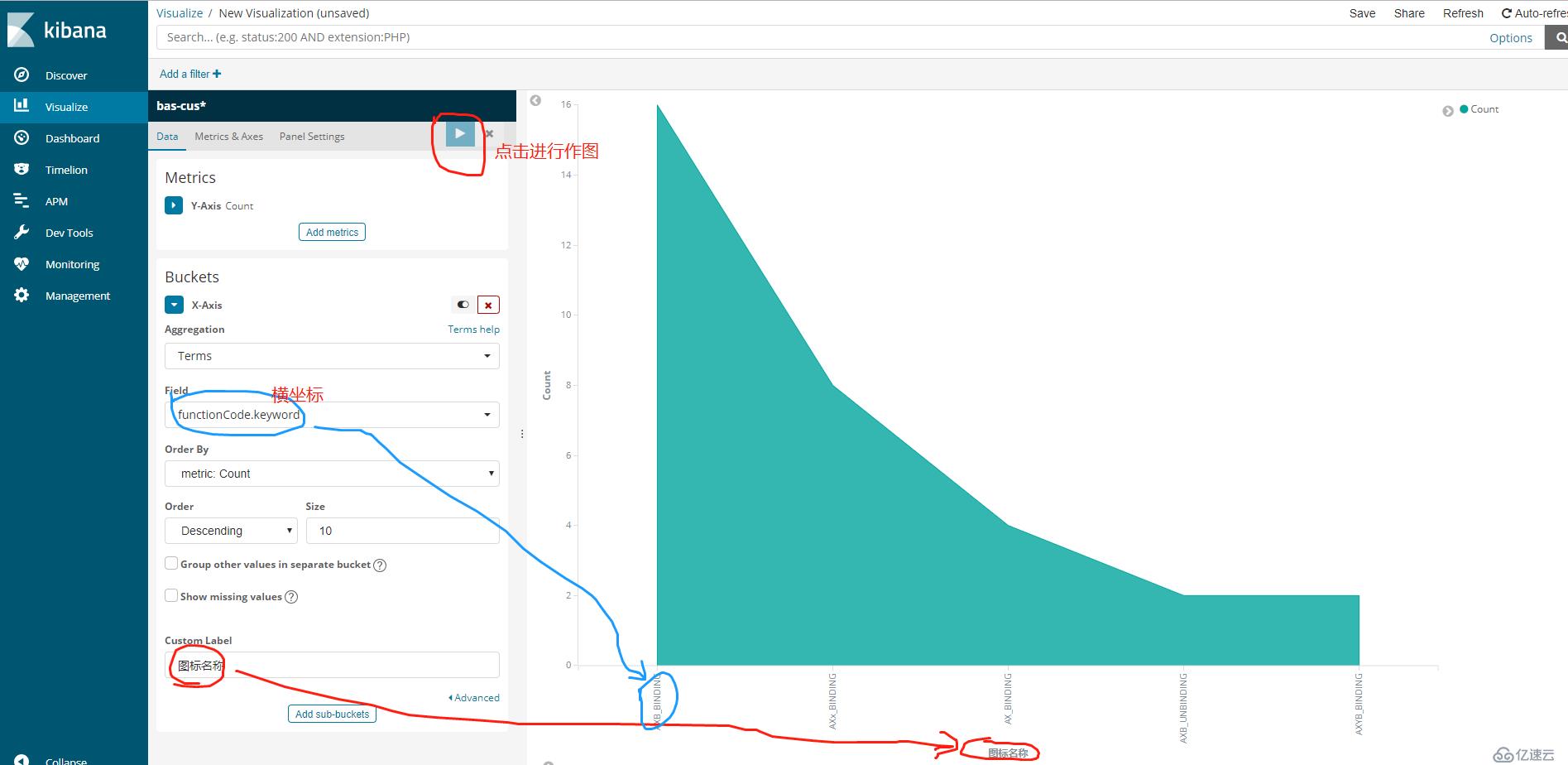

Visualize:可以選擇自己想要的索引去進行圖形分析,效果如下:

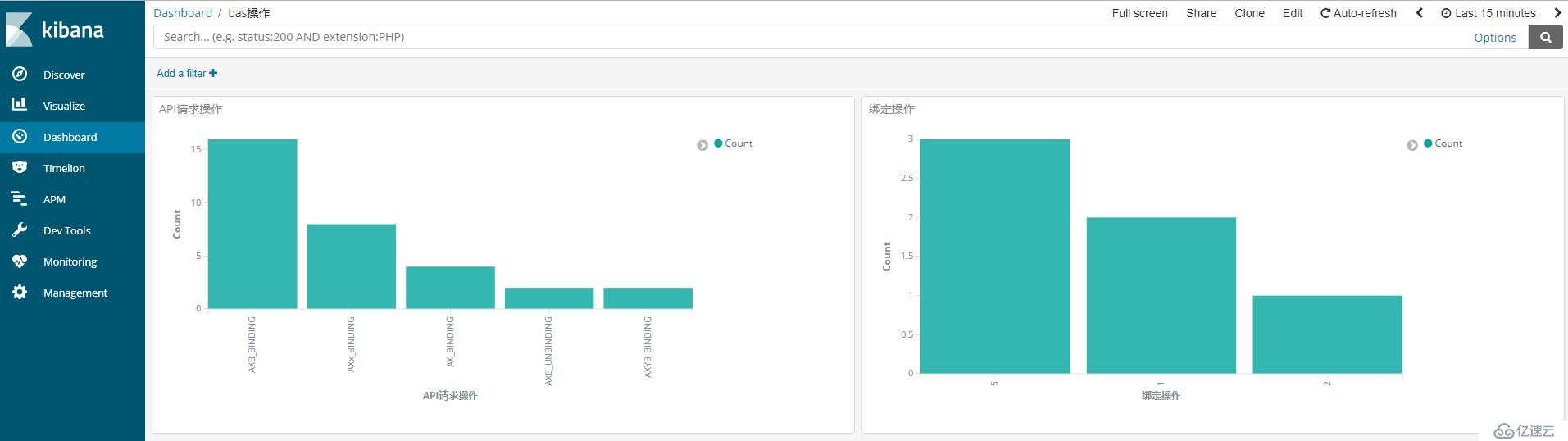

Dashboard:將做過的圖整合到儀表盤,效果如下:

另外,可以設置自動刷新,即當有新的數據發送到kafka時,所做的圖會自動根據主題來進行刷新。

項目中,可以通過logback來講日志輸出到kafka,具體配置如下:

<appender name="bingdings-log-to-kafka" class="com.github.danielwegener.logback.kafka.KafkaAppender"> <encoder> <pattern>%msg%n</pattern> </encoder> <!-- 指定kafka主題,消費時要用到--> <topic>bas-binding-topic</topic> <keyingStrategy class="com.github.danielwegener.logback.kafka.keying.NoKeyKeyingStrategy" /> <deliveryStrategy class="com.github.danielwegener.logback.kafka.delivery.AsynchronousDeliveryStrategy" /> <!-- 配置輸出到指定ip、端口的kafka --> <producerConfig>bootstrap.servers=localhost:9092,10.8.22.13:9092</producerConfig> <!-- this is the fallback appender if kafka is not available. --> </appender> <logger name = "bingdings-log-to-kafka" level="INFO" additivity = "false"> <appender-ref ref="bingdings-log-to-kafka"/> </logger>

然后在記日志的時候,記到對應的主題,日志就會寫到kafka相應的位置。可以通過消費者來消費主題,查看日志是否成功寫入,如下:

@SuppressWarnings("resource")

public static void main(String[] args) {

Properties properties = new Properties();

properties.put("bootstrap.servers", "127.0.0.1:9092");

properties.put("group.id", "group-1");

properties.put("enable.auto.commit", "false");

properties.put("auto.commit.interval.ms", "1000");

properties.put("auto.offset.reset", "earliest");

properties.put("session.timeout.ms", "30000");

properties.put("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

properties.put("value.deserializer",

"org.apache.kafka.common.serialization.StringDeserializer");

KafkaConsumer<String, String> kafkaConsumer = new KafkaConsumer<>(properties);

kafkaConsumer.subscribe(Arrays.asList("bas-cus-request-topic", "bas-binding-topic"));

while (true) {

ConsumerRecords<String, String> records = kafkaConsumer.poll(Long.MAX_VALUE);

System.err.println("+++++++++++++++++++++++++++++++++++++++++");

for (ConsumerRecord<String, String> record : records) {

System.err.println(record.offset() + ">>>>>>" + record.value());

}

System.err.println("+++++++++++++++++++++++++++++++++++++++++++++");

break;

}

}以上是“windows下如何實現kafka+ELK的日志系統”這篇文章的所有內容,感謝各位的閱讀!希望分享的內容對大家有幫助,更多相關知識,歡迎關注億速云行業資訊頻道!

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。