您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

使用pytorch怎么計算 kl散度 ?很多新手對此不是很清楚,為了幫助大家解決這個難題,下面小編將為大家詳細講解,有這方面需求的人可以來學習下,希望你能有所收獲。

如果現在想用Y指導X,第一個參數要傳X,第二個要傳Y。就是被指導的放在前面,然后求相應的概率和對數概率就可以了。

import torch import torch.nn.functional as F # 定義兩個矩陣 x = torch.randn((4, 5)) y = torch.randn((4, 5)) # 因為要用y指導x,所以求x的對數概率,y的概率 logp_x = F.log_softmax(x, dim=-1) p_y = F.softmax(y, dim=-1) kl_sum = F.kl_div(logp_x, p_y, reduction='sum') kl_mean = F.kl_div(logp_x, p_y, reduction='mean') print(kl_sum, kl_mean) >>> tensor(3.4165) tensor(0.1708)

補充:pytorch中的kl散度,為什么kl散度是負數?

F.kl_div()或者nn.KLDivLoss()是pytroch中計算kl散度的函數,它的用法有很多需要注意的細節。

第一個參數傳入的是一個對數概率矩陣,第二個參數傳入的是概率矩陣。并且因為kl散度具有不對稱性,存在一個指導和被指導的關系,因此這連個矩陣輸入的順序需要確定一下。如果現在想用Y指導X,第一個參數要傳X,第二個要傳Y。就是被指導的放在前面,然后求相應的概率和對數概率就可以了。

所以,一隨機初始化一個tensor為例,對于第一個輸入,我們需要先對這個tensor進行softmax(確保各維度和為1),然后再取log;對于第二個輸入,我們需要對這個tensor進行softmax。

import torch import torch.nn.functional as F a = torch.tensor([[0,0,1.1,2,0,10,0],[0,0,1,2,0,10,0]]) log_a =F.log_softmax(a) b = torch.tensor([[0,0,1.1,2,0,7,0],[0,0,1,2,0,10,0]]) softmax_b =F.softmax(b,dim=-1) kl_mean = F.kl_div(log_a, softmax_b, reduction='mean') print(kl_mean)

先確保對第一個輸入進行了softmax+log操作,對第二個參數進行了softmax操作。不進行softmax操作就可能為負。

然后查看自己的輸入是否是小數點后有很多位,當小數點后很多位的時候,pytorch下的softmax會產生各維度和不為1的現象,導致kl散度為負,如下所示:

a = torch.tensor([[0.,0,0.000001,0.0000002,0,0.0000007,0]])

log_a =F.log_softmax(a,dim=-1)

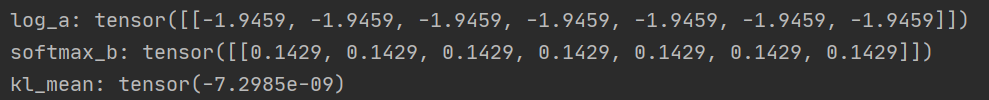

print("log_a:",log_a)

b = torch.tensor([[0.,0,0.000001,0.0000002,0,0.0000007,0]])

softmax_b =F.softmax(b,dim=-1)

print("softmax_b:",softmax_b)

kl_mean = F.kl_div(log_a, softmax_b,reduction='mean')

print("kl_mean:",kl_mean)輸出如下,我們可以看到softmax_b的各維度和不為1:

1.PyTorch是相當簡潔且高效快速的框架;2.設計追求最少的封裝;3.設計符合人類思維,它讓用戶盡可能地專注于實現自己的想法;4.與google的Tensorflow類似,FAIR的支持足以確保PyTorch獲得持續的開發更新;5.PyTorch作者親自維護的論壇 供用戶交流和求教問題6.入門簡單

看完上述內容是否對您有幫助呢?如果還想對相關知識有進一步的了解或閱讀更多相關文章,請關注億速云行業資訊頻道,感謝您對億速云的支持。

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。