您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

日前,由阿里巴巴研究型實習生張雪舟、螞蟻金服高級算法專家婁寅撰寫的論文《Axiomatic Interpretability for Multiclass Additive Models》入選全球數據挖掘頂級會議KDD 2019,本文為該論文的詳細解讀。論文地址:https://www.kdd.org/kdd2019/a...

模型可解釋性是機器學習研究中的一個重要課題。這里我們研究的對象是廣義加性模型(Generalized Additive Models,簡稱GAMs)。GAM在醫療等對解釋性要求較高的場景下已經有了廣泛的應用 [1]。

GAM作為一個完全白盒化的模型提供了比(廣義)線性模型(GLMs)更好的模型表達能力:GAM能對單特征和雙特征交叉(pairwise interaction)做非線性的變換。帶pairwiseinteraction的GAM往往被稱為GA2M。以下是GA2

M模型的數學表達:

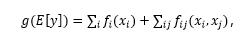

其中g是linkfunction,fi和fij被稱為shape function,分別為模型所需要學習的特征變換函數。由于fi和fij都是低緯度的函數,模型中每一個函數都可以被可視化出來,從而方便建模人員了解每個特征是如何影響最終預測的。例如在[1]中,年齡對肺炎致死率的影響就可以用一張圖來表示。

由于GAM對特征做了非線性變換,這使得GAM往往能提供比線性模型更強大的建模能力。在一些研究中GAM的效果往往能逼近Boosted Trees或者Random Forests [1, 2, 3]。

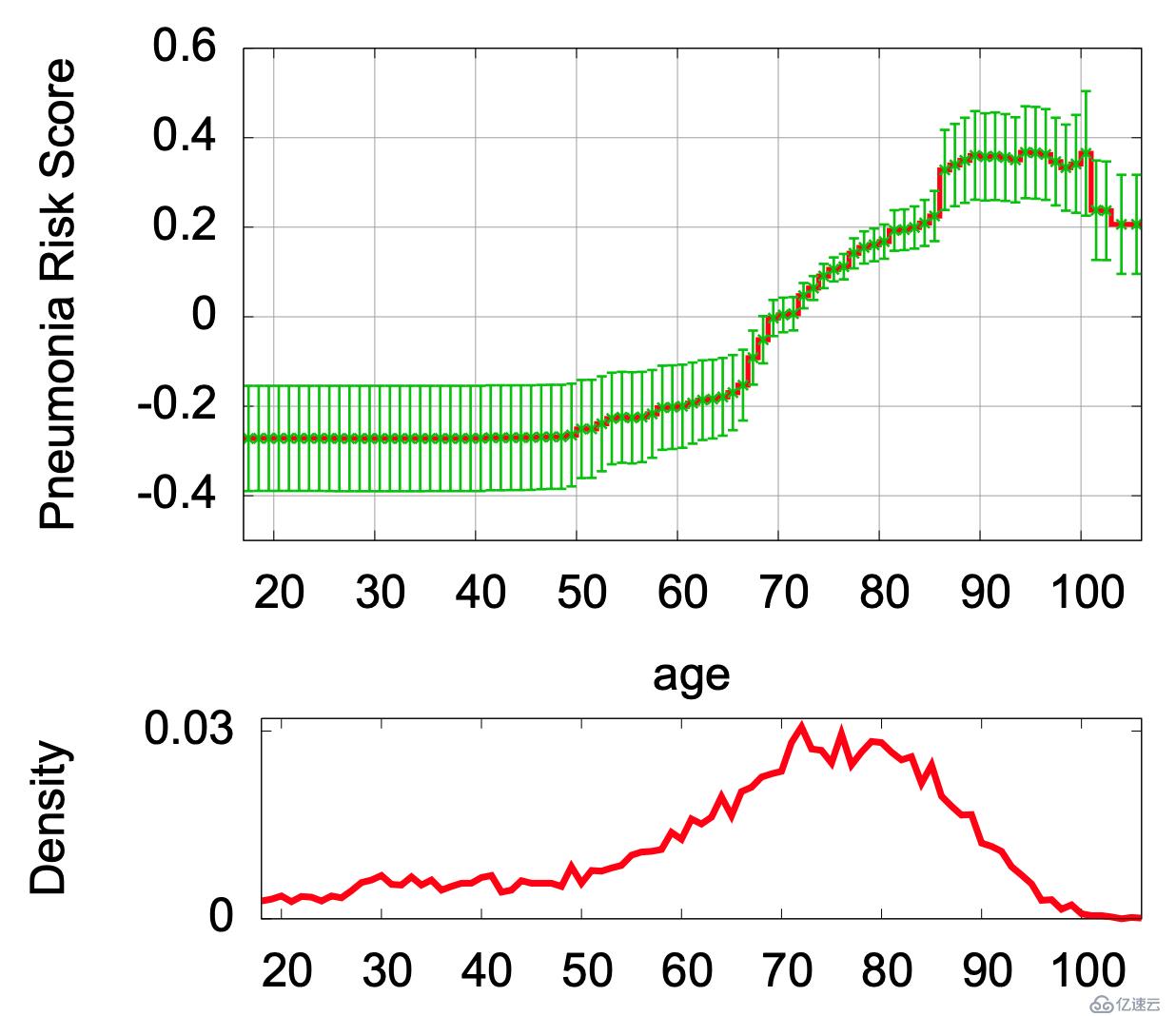

本文首先討論了在多分類問題的下,傳統可解釋性算法(例如邏輯回歸,SVM)的可視化圖像與模型的預測機制之間存在的矛盾。如果直接通過這些未經加工的可視化圖像理解模型預測機制,有可能造成建模人員對模型預測機制的錯誤解讀。如圖1所示,左邊是在一個多分類GAM下age的shape function。粗看之下這張圖表示了Diabetes I的風險隨年齡增長而增加。然而當我們看實際的預測概率(右圖),Diabetes I的風險其實應該是隨著年齡的增加而降低的。

為了解決這一問題,本文提出了一種后期處理方法(AdditivePost-Processing for Interpretability, API),能夠對用任意算法訓練的GAM進行處理,使得在不改變模型預測的前提下,處理后模型的可視化圖像與模型的預測機制相符,由此讓建模人員可以安全的通過傳統的可視化方法來觀察和理解模型的預測機制,而不會被錯誤的視覺信息誤導。

API的設計理念來源于兩個在長期使用GAM的過程中得到的可解釋性定理(Axioms of Interpretability)。我們希望一個GAM模型具備如下兩個性質:

任意一個shape function fik (對應feature i和class k)的形狀,必須要和真實的預測概率Pk的形狀相符,即我們不希望看到一個shape function是遞增的,但實際上預測概率是遞減的情況。

Shape function應該避免任何不必要的不平滑。不平滑的shape function會讓建模人員難以理解模型的預測趨勢。

現在我們知道我們想要的模型需要滿足什么性質,那么如何找到這樣的模型,而不改變原模型的預測呢?這里就要用到一個重要的softmax函數的性質。

對于一個softmax函數,如果在每一個輸入項中加上同一個函數,由此得來的模型是和原模型完全等價的。也就是說,這兩個模型在任何情況下的預測結果都相同。基于這樣的性質,我們就可以設計一個g 函數,讓加入g函數之后的模型滿足我們想要的性質。

我們在文章中從數學上證明,以上這個優化問題永遠有唯一的全局最優解,并且我們給出了這個解的解析形式。我們基于此設計的后期處理方法幾乎不消耗任何計算資源,卻可以把具有誤導性的GAM模型轉化成可以放心觀察的可解釋模型。

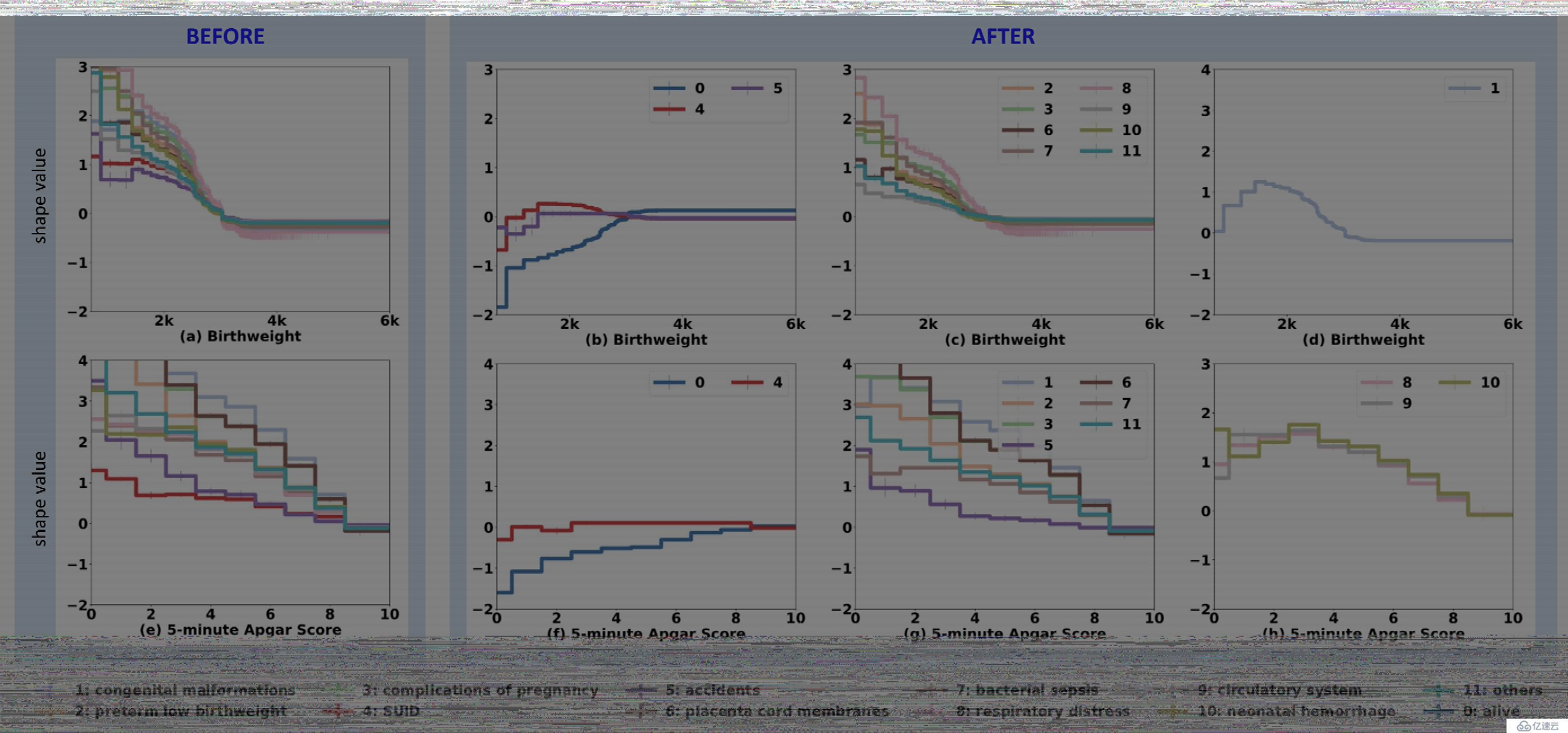

在一個預測嬰兒死因的數據上(12類分類問題),我們采用API對shapefunction做了處理,從而使得他們能真實地反應預測概率變化的趨勢。這里可以看到,在采用API之前,模型可視化提供的信息是所有死因都和嬰兒體重和Apgar值成負相關趨勢。但是在采用API之后我們發現,實際上不同的死因與嬰兒體重和Apgar值的關系

是不一樣的:其中一些死因是正相關,一些死因是負相關,另外一些在嬰兒體重和Apgar值達到某個中間值得時候死亡率達到最高。API使得醫療人員能夠通過模型得到更準確的預測信息。

在很多mission-critical的場景下(醫療,金融等),模型可解釋性往往比模型自身的準確性更重要。廣義加性模型作為一個高精確度又完全白盒化的模型,預期能在更多的應用場景上落地。

[1] Caruana et al. Intelligible Modelsfor HealthCare: Predicting Pneumonia Risk and Hospital 30-day Readmission. In KDD2015.

[2] Lou et al. Intelligible Models for Classification and Regression. In KDD2012.

[3] Lou et al. Accurate Intelligible Models withPairwise Interactions. In KDD 2013.

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。