您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

“超融合”這個概念,可以簡單理解為:將虛擬計算平臺和存儲融合到一起,將每臺服務器里面自帶的硬盤組成存儲池,以虛擬化的形式提供數據中心所需要的計算、網絡、安全以及存儲等IT基礎架構。在這里,也講解一下超融合相對于傳統虛擬化方案的優勢。橫向與縱向的擴展性

顧名思義,橫向擴展就是當發現存儲和計算資源不夠用了,按需添加服務器即可。比如,當用戶的共享存儲寫滿了,用戶不得不花大價錢去購買一個新的存儲機柜,然而此時存儲機柜的資源利用率是很低的。而使用超融合方案的用戶,他們只需要投入較少的費用去購買一個新的服務器加入集群,即可擴展存儲空間。

便捷提供多副本,提高數據安全

超融合方案可便捷支持2-3個副本。當某些服務器損壞時,若采用超融合方案,所需要的數據還會存在對應的副本里,工作還能正常進行。而對比于傳統的共享存儲,用戶想做兩個副本時,只好硬著頭皮再買一個一模一樣的存儲設備做備份,增加了不少IT投資。

分布式存儲,拉近計算和存儲的距離

傳統的共享存儲在數據讀寫時,都需要通過網線或光纖進行數據傳輸。而超融合分布式的存儲在讀數據的時候,基本都是直接讀取本地的副本數據,減少數據流經網線或光纖的時間,加快數據讀取速度。

軟硬件一體化,省錢省力省心

超融合方案所支持的軟硬件一體化,即用戶可以一次性輕松地把云數據中心部署好,其中包括服務器、服務器虛擬化、存儲虛擬化等虛擬化軟件。對比不少用戶會分開購買硬件和軟件,采購成本較高。同時,軟硬件一體機在出廠時已將軟件植入到硬件當中,并且已經通過兼容測試,用戶可直接架到機房,通電并簡單配置即可使用。

總結超融合特點及優勢:

? 去中心化:沒有專門的控制節點,無需考慮控制節點的單點問題。

? 去集中存儲:傳統的私有云集群架構,保障可用性是以共享存儲方式實現的。但共享存儲本身就是單點,雖然可以以多磁盤冗余已經雙控制器的方式提高可用性,但仍然存在IO集中、性能無法提升的困境。

? 更低的建設成本:去掉昂貴的中心化存儲,磁盤分布到本地物理服務器,投資成本大幅度降低。

? 在線擴容:不停止服務,對物理機配件(內存、cpu等)進行擴容,甚至新增物理節點。

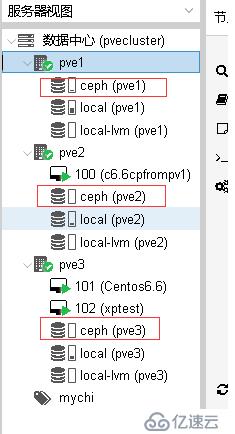

PVE集群搭建過程簡述:(3個結點PVE1-PVE3:192.168.26.210-212)

1、安裝下載pve官方ISO鏡像安裝即可,操作很簡單跟著提示下一步即可(如果有特別的存儲配置注意安裝的時候配置下,也可以后期再進行設置不過相對可能要繁瑣些)

安裝成功后使用瀏覽器WEB登陸效果:

2、登陸(通過ssh)三個結點更新源及系統。

rm -f /etc/apt/sources.list.d/pve-enterprise.list

echo "deb http://download.proxmox.com/debian/pve stretch pve-no-subscription" >/etc/apt/sources.list.d/pve-install-repo.list

wget http://download.proxmox.com/debian/proxmox-ve-release-5.x.gpg -O /etc/apt/trusted.gpg.d/proxmox-ve-release-5.x.gpg

apt update && apt dist-upgrade

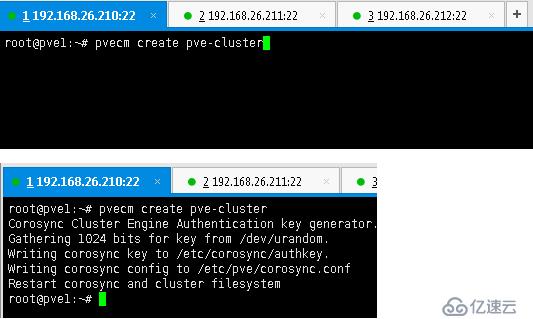

3、開始創建集群在pve1上執行root@pve1:~# pvecm create pve-cluster

4、在pve2上執行root@pve2:~# pvecm add 192.168.26.210注意需要輸入密碼認證。

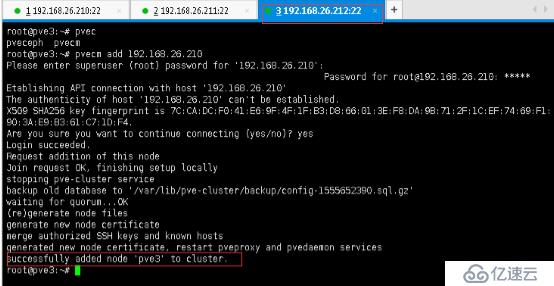

5、同樣在PVE3結點上執行命令root@pve3:~# pvecm add 192.168.26.210同樣需要輸入密碼認證

6、集群成功創建查看集群狀態:三個結點任一一個上面都可以。

root@pve1:~# pvecm status

再切換一個結點試下查看狀態

root@pve2:~# pvecm status

7、回到WEB管理臺發現三個結點都已經出現了(集中中任一結點都可以)

8、為集群建立可靠的存儲(Ceph存儲,注意三個集群結點都需要執行)

root@pve3:~# pveceph install --version luminous

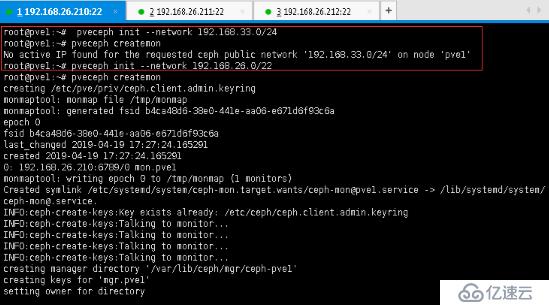

9、初始化存儲集群網絡段,以便進行通信,注意需要和PVE集群同網段,否則會報錯(只需在PVE1結點上執行一次即可):

root@pve1:~# pveceph init --network 192.168.33.0/24

No active IP found for the requested ceph public network '192.168.33.0/24' on node 'pve1'

換成同網段:

root@pve1:~# pveceph init --network 192.168.26.0/22

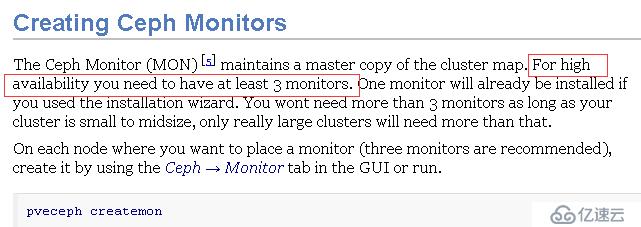

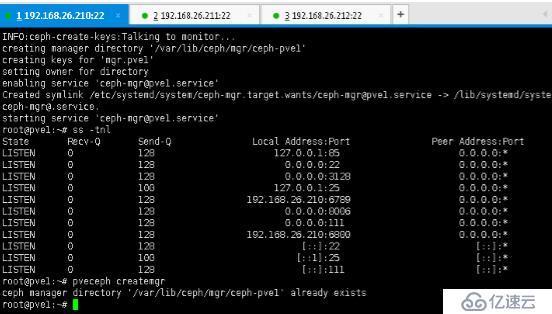

10、創建ceph集群存儲Mon監控(三個結點都需要,不然高可用都無效,實測有結點故障時會一直卡住,至到MON結點恢復)

11、創建ceph集群存儲mgr(Creating Ceph Manager)同樣需要三個結點都安裝不然無法實現高可用。

pveceph createmgr #但提示已經存在,原因是安裝監控MON的時候自動已經安裝上了。

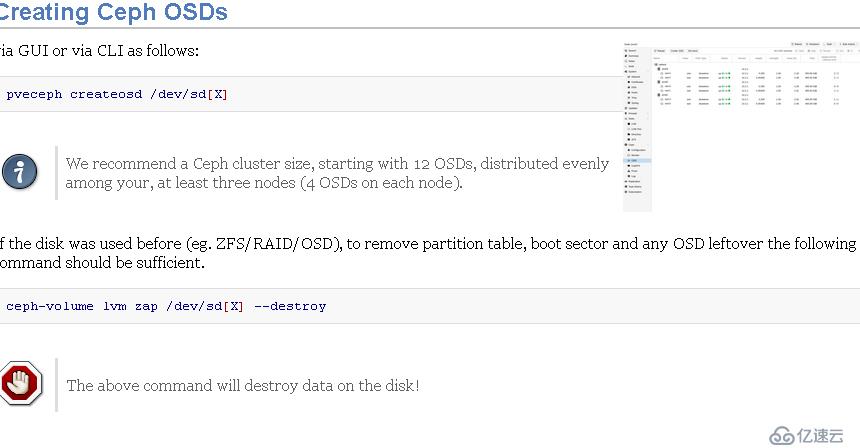

12、創建Ceph OSDs(Creating Ceph OSDs)同樣三個結點都需要執行一樣操作。

13、創建集群存儲資源池(Creating Ceph Pools)此操作只需要任一結點上執行即可。

root@pve1:~# ceph osd pool create pvepool 128 128

此時查看下存儲集群狀態ceph -s

有報警:ceph:health_warn clock skew detected on mon的解決辦法

造成集群狀態health_warn:clock skew detected on mon節點的原因一般有兩個,一個是mon節點上ntp服務器未啟動,另一個是ceph設置的mon的時間偏差閾值比較小。排查時也應遵循先第一個原因,后第二個原因的方式。

修改時間偏差閾值(記得重啟服務)

# vi ceph.conf

在global字段下添加:

mon clock drift allowed = 2 mon clock drift warn backoff = 30

# ceph -s

顯示health_ok說明問題解決

14、添加RBD集群存儲(打開瀏覽器登陸WEB控制臺配置)

注意選擇使用超融合CEPH池。

查看rbd集群存儲配置信息

15、測試創建虛擬服務器PVE1上

安裝CENTOS6.6

pve3安裝XP

關閉其它節點(節點1)不影響安裝操作

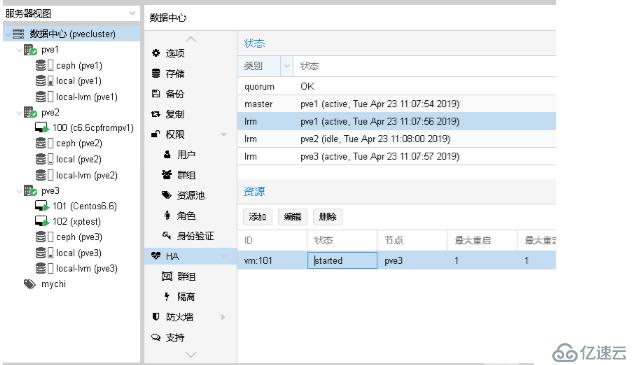

測試高可用:先配置

測試:PVE3關機后收到報警(安裝的時候配置了郵件地址的)

過兩分鐘還會收到一封郵件:提示故障已經成功轉移。

虛擬服務器已經轉移

看下WEB平臺瀏覽的狀態:

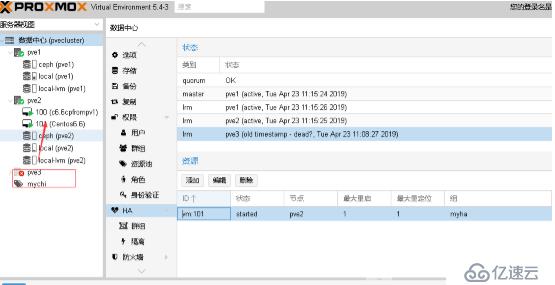

我們恢復PVE3.

恢復后自動遷移回去了,因為其權重高些(生產環環境不建議直接又回切,根據需要配置)。

Proxmox中克隆虛擬服務器

Proxmox中遷移虛擬服務器(pve3到pve1)

配置spice模擬終端登陸(實現可以直接使用終端設置聯接操作虛擬機實現云桌面):

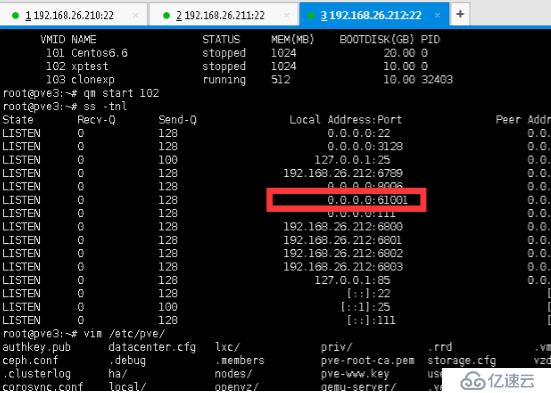

配置文件中添加內容:args: -spice port=61001,disable-ticketing,seamless-migration=on

啟動102 虛擬服務器qm start 102(這里通過命令啟動的)也可以通過WEB控制臺效果一樣。

啟動后發現多開放了一個端口,配置終端機聯接此端口即可聯接操作服務器。這里通過VirtViewer軟件模擬登陸。

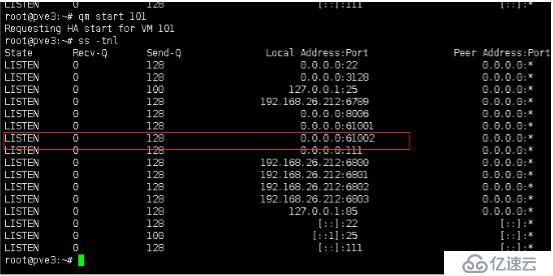

換臺服務器再試(linux):

同樣需要修改配置文件:

root@pve3:~# cat /etc/pve/qemu-server/101.conf

bootdisk: sata2

cores: 1

ide2: none,media=cdrom

memory: 1024

name: Centos6.6

net0: e1000=26:24:01:00:69:7D,bridge=vmbr0

numa: 0

ostype: l26

sata2: ceph:vm-101-disk-0,size=20G

scsihw: virtio-scsi-pci

smbios1: uuid=73100396-3804-4002-815b-4017d81199a9

sockets: 1

vmgenid: bb0d8fc0-a6c7-4283-81f3-6766c4f150a2

args: -spice port=61002,disable-ticketing,seamless-migration=on

保存退出啟動虛擬服務器

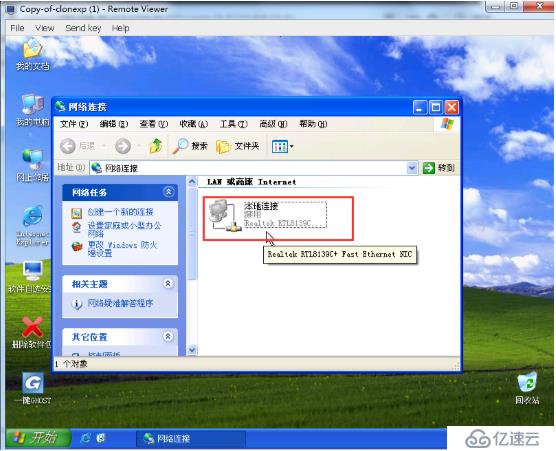

聯接效果:

需要說明的是終端聯接的是平臺服務器IP加上端口,是基于端口的應用,而我們聯上服務器后配置的虛擬服務器上網用的IP地址,因此不要混了,即使我們把網卡禁用了通過終端還是能聯接的,只是服務器不能上外網絡(和其它服務器通信)看下圖片中效果,和我們平常開啟遠程訪問是有區別的。

cd

功能效果暫時展示到這,其它功能及補充后續文章再完善,好久沒寫文了,草文堆了一大堆。

參考:https://pve.proxmox.com/pve-docs/chapter-pveceph.html

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。